por Isaac García | Last updated May 9, 2025 | Pandora FMS

Uno podría pensar que, con lo efectivas que son ciertas empresas registrando todo lo que hacemos para mostrarnos anuncios, usarían eso para que, al menos, sepamos qué ocurre en nuestros sistemas y monitoricemos su rendimiento y seguridad. Pero en el caso de Windows, los logs tradicionales se quedan cortos y de ahí viene la importancia de Sysmon.

Sysmon es un servicio de Windows que registra la actividad del sistema operativo en un log de eventos. Pero no viene instalado por defecto, así que podemos descargarlo desde aquí.

Una vez instalado, los logs de Sysmon son mucho más avanzados y exhaustivos que el registro de eventos de Windows por defecto, lo cual es fundamental para la seguridad de nuestros sistemas.

Por eso, veamos Sysmon en detalle.

Cómo instalar Sysmon

Sysmon no se instala como un programa habitual de Windows y estos son los pasos para hacerlo sin errores extraños:

- Ejecuta Powershell como administrador.

- Navega con la línea de comandos hasta la ubicación en la que hayas descomprimido el archivo enlazado antes.

- Ahora ejecuta: .\Sysmon64.exe -i -accepteula

- Verás unos mensajes de instalación y ya lo tienes funcionando.

Ubicación y gestión de los logs de Sysmon

Ahora, ¿cómo podemos ver los registros de Sysmon? A Microsoft le gusta escondernos las cosas, pero es «fácil»:

- Pulsa la tecla Windows y busca Visor de Eventos. Ejecútalo.

- Verás varias carpetas, ve a: Registros de Aplicaciones y Servicios.

- Entra en la carpeta Microsoft y luego en la carpeta Windows.

- En la pantalla central, baja hasta que encuentres Sysmon y pulsa en él. Verás un log llamado Operational, que puedes gestionar con las opciones que verás a la derecha. Haz clic y ábrelo.

- Ahí está todo lo que ocurre y puedes seleccionar eventos, copiarlos, guardarlos…

Por qué los logs de Sysmon son fundamentales para un SIEM

Con esos logs exhaustivos de Sysmon, nuestro SIEM, como Pandora SIEM, puede analizar y correlacionar esos registros, detectando y alertando al SOC sobre amenazas que, con logs básicos pasarían desapercibidas.

Por ejemplo, un ataque de process hollowing, en el que un actor malicioso crea un proceso «legítimo» como svchost.exe, pero que en realidad lleva dentro código malicioso, pasaría por debajo del radar de los registros de evento por defecto, y eso si no los ha deshabilitado primero.

Pero gracias a Sysmon, nuestro SIEM detectaría y alertaría sobre esta y otras técnicas al analizar su log. Por eso, en el panorama de seguridad actual, Sysmon es imprescindible si manejas equipos Windows y te enfrentas a cosas más avanzadas que un ataque DDoS.

Los eventos que registra Sysmon

Con Sysmon pasamos casi de la nada al todo en cuanto a eventos registrados. El servicio asigna un número ID a cada tipo de evento y estos son los que guarda:

- 1: Creación del proceso.

- 2: Un proceso cambió la hora de creación de un archivo.

- 3: Conexión de red.

- 4: Estado del servicio Sysmon cambiado.

- 5: Proceso finalizado.

- 6: Controlador cargado.

- 7: Imagen cargada.

- 8: CreateRemoteThread.

- 9: RawAccessRead.

- 10: ProcessAccess.

- 11: FileCreate.

- 12: RegistryEvent (Creación y eliminación de objetos).

- 13: RegistryEvent (conjunto de valores).

- 14: RegistryEvent (nombre de clave y valor).

- 15: FileCreateStreamHash.

- 16: ServiceConfigurationChange.

- 17: PipeEvent (canalización creada).

- 18: PipeEvent (canalización conectada).

- 19: WmiEvent (actividad WmiEventFilter detectada).

- 20: WmiEvent (actividad WmiEventConsumer detectada).

- 21: WmiEvent (actividad WmiEventConsumerToFilter detectada).

- 22: DNSEvent (consulta DNS).

- 23: FileDelete (eliminación de archivo archivado).

- 24: ClipboardChange (nuevo contenido en el Portapapeles).

- 25: ProcessTampering (procesar cambio de imagen).

- 26: FileDeleteDetected (eliminación de archivos registrada).

- 27: FileBlockExecutable.

- 28: FileBlockShredding.

- 29: FileExecutableDetected.

- 255: Error. Reservado a cuando no puede realizar alguna tarea y otros fallos.

Como vemos, guarda la creación o modificación de archivos, el Portapapeles, peticiones de red… Con este registro granular, podemos correlacionar hechos aparentemente inocentes por sí mismos, pero que juntos pueden ser piezas de un ataque sofisticado.

Ciclo de vida de los logs de Sysmon

Para una gestión eficiente de registros, debemos definir qué ocurrirá en cada paso de su ciclo de vida.

Sysmon comienza registrando eventos en tiempo real según la configuración que hayamos definido en un archivo XML.

Obviamente, tiene una configuración por defecto con la que empieza a registrar, pero el poder y el interés de cualquier SOC es adaptar ese XML a lo que más necesita su organización, sus políticas de seguridad y gestión de riesgos o su infraestructura, como el SIEM que use.

Así, podemos configurar Sysmon para que no registre «ruido» o demasiadas cosas que no interesan, centrándonos en las que sí.

A partir de ese nacimiento de nuestro log registrando eventos, estos se almacenarán hasta alcanzar el tamaño definido del registro, que podemos ajustar desde el Visor de Eventos.

Para ello, nos vamos de nuevo hasta Operational, pulsamos con botón derecho, elegimos Propiedades y ahí podemos definir:

- Tamaño máximo del log.

- Qué se hace cuando se alcanza: Sobreescribir empezando por los eventos más antiguos, Archivar el log de modo que no se sobreescriba o bien no sobreescribir, porque limpiarás el registro manualmente (lo que siempre prometes y no cumples, probablemente).

Ese registro alcanza su mayor utilidad cuando lo analiza un SIEM, porque estar navegando por cada línea de Sysmon forja héroes, pero también miopes, siendo infinitamente más lento que el SIEM, con elevada probabilidad de pasar cosas por alto, como indicios de malware.

Por ejemplo, el agente de Pandora SIEM recoge el registro y lo envía a un servidor centralizado para analizar y correlacionar con otros logs sin que se nos caigan las pestañas. Así, detendremos en tiempo real posibles amenazas escondidas entre las incontables líneas y que conecten con actividades de otros registros, como los de red u otras máquinas, aunque no sean Windows.

No solo eso, aunque el endpoint Windows quede comprometido hasta ser inservible, tendremos el registro centralizado en nuestro SIEM, permitiendo saber qué ha producido ese fallo catastrófico en el análisis forense.

¿Y qué se hace con los logs una vez analizados?

Dependerá del equilibrio entre un archivado y borrado sensatos, junto las necesidades forenses o las exigencias normativas de almacenaje de logs en el tiempo.

Cómo analiza los logs de Sysmon Eventlog Analyzer

Un log de Sysmon registra mucha información, pero nosotros necesitamos conocimiento accionable para nuestras estrategias de defensa. Para ello, varias aplicaciones pueden usar Sysmon para detectar patrones maliciosos y avisarnos.

Eventlog Analyzer es una herramienta de ManageEngine que, dentro de sus prestaciones, tiene el análisis de logs, no solo de Sysmon, sino también de routers, IDS, etc.

Así, los normaliza, correla y muestra lo importante de manera visual en Dashboards y alertas.

Eso facilita la detección de amenazas, la labor forense en brechas, el cumplimiento de normativas…

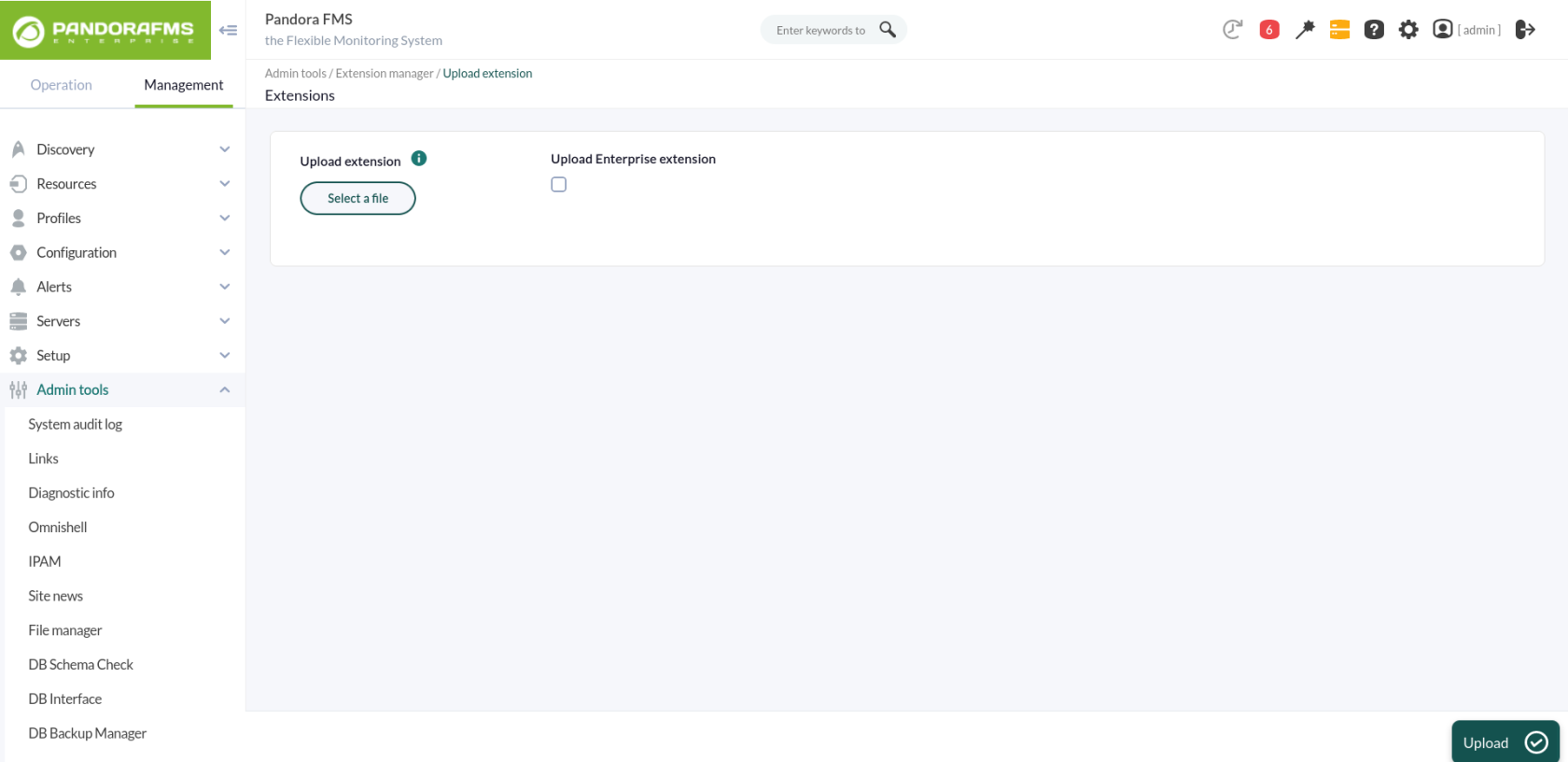

Monitorización de Sysmon con Pandora FMS y Pandora SIEM

Pandora SIEM también permite centralizar y analizar de manera más avanzada los registros de Sysmon (y de otras partes de la infraestructura IT) vía Log Collector. Luego, transforma esa información en conocimiento y detecta amenazas, avisando enseguida. No importa si tienes máquinas Windows y Linux, por ejemplo, y la información de Sysmon debe jugar en equipo con Syslog o Auditd. Todo se integra y analiza.

Una de las prestaciones más poderosas de Pandora es que podemos adaptar siempre la herramienta a cómo trabajemos, personalizándola para nuestra organización y necesidades.

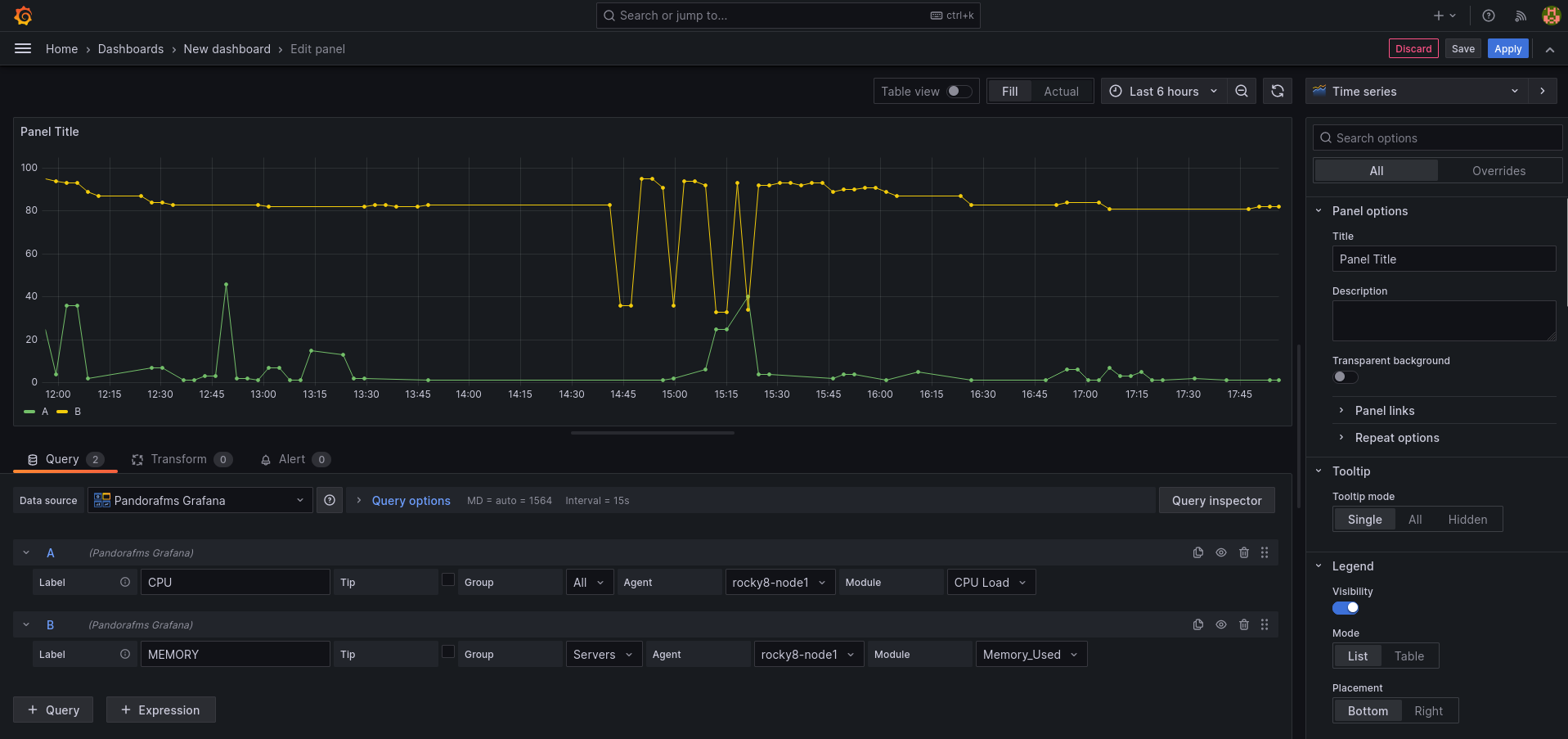

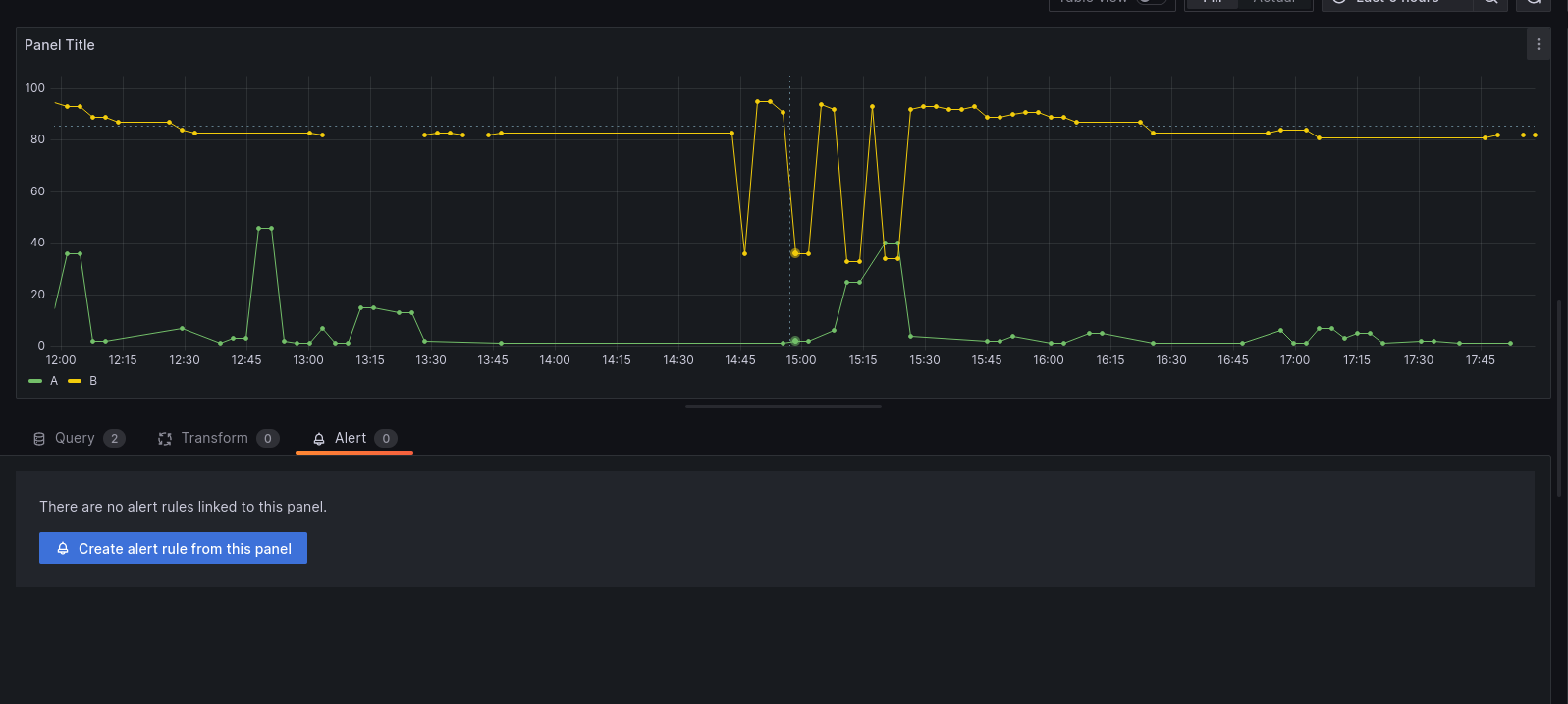

Del mismo modo, Pandora muestra exactamente lo que queremos en dashboards que nosotros mismos definimos (como listar eventos Sysmon ordenados por criticidad) y que nos alerte de lo que deseamos y nada más, callando el ruido.

Además, también puede realizar informes y búsquedas poderosas, que van mucho más allá de las prestaciones de otras herramientas.

Pandora es una solución integral, la computadora del Enterprise, capaz de monitorizar y manejar sistemas dispares, para que trabajen como un reloj. Su SIEM es sinónimo de la seguridad más avanzada, pero también se puede incluir monitorización y control remoto o ticketing en un solo lugar.

Eso evita que parezcamos el Doctor Frankenstein cosiendo mil herramientas diferentes hasta que sale un monstruo que se rompe por las costuras. Algo demasiado habitual en IT, que además añade un soporte fragmentado en cada herramienta, que siempre responderá que la culpa es de «las otras aplicaciones».

Cómo configurar Sysmon correctamente

Un gran poder conlleva una gran responsabilidad… y complejidad. Es por eso que, para cualquiera que necesite filtrar «ruido» y recibir solamente información crítica de Sysmon, usar un XML personalizado de configuración es recomendable.

Eso lo hacemos con la instrucción:

.\Sysmon64.exe -i -accepteula c:\micarpeta\mixmlpersonal.xml

Pero componer ese XML desde cero resulta uno de los trabajos de Hércules, por eso, Pandora te ofrece uno base para empezar, que puedes descargar aquí.

Este fichero está basado en las mejores prácticas y adaptado especialmente para que Pandora extraiga la información clave que permita proteger con eficacia, pero el XML debe ser siempre adaptado a cada entorno.

El archivo viene comentado (lo que permite trabajar mucho mejor con él) y con ciertas reglas específicas de Pandora, pero puedes modificarlo según tu necesidad.

Puntos clave del XML que querremos personalizar podrían ser:

- Procesos clave (busca

![]()

- Puertos a los que se conectan atacantes (busca

- Cambios en el registro (busca

- Ejecutables desde ubicaciones sospechosas, como /temp o la Papelera de Reciclaje…

Familiarizarse con el XML, su estructura y lo que significa cada cosa es una de las mejores habilidades a adquirir para proteger equipos Windows.

Así, podemos estar seguros de que el potencial de Sysmon no se queda olvidado en registros que ocupan gigas, mientras recogen polvo virtual.

Como vemos, si manejamos equipos Windows, Sysmon es imprescindible, porque Microsoft quizá lo sepa todo de nosotros, pero con los eventos registrados por defecto nosotros sabemos poco de Windows. Por eso es necesario comenzar a registrar con Sysmon, pero no solo quedarse ahí.

Su enorme poder de registro es también su reto y, por eso, a fin de aprovechar Sysmon para asegurar nuestra organización, lo ideal es personalizar su XML e integrarlo con un SIEM. Él realizará el trabajo duro de detectar las amenazas escondidas entre las miles de líneas del log.

por Isaac García | Last updated May 7, 2025 | Pandora FMS

No puedes defenderte de lo que no ves. Por eso, el primer requisito imprescindible en ciberseguridad es saber todo lo que ocurre en nuestros sistemas. Para ello, implementamos un IDS (Intrusion Detection System o Sistema de Detección de Intrusiones), que vigila sin descanso cada rincón de nuestra red como el ojo de Sauron, notificando al instante intentos de brecha y comportamientos sospechosos. Y entre las opciones IDS, Snort es una de las más populares.

Esto se debe a su efectividad, su código abierto, su calidad al estar desarrollado por Cisco y sus versiones para Windows, Linux y Unix.

Trabajando en equipo con un SIEM (Security Information and Event Management), que analice y alerte de manera global y avanzada, e incluso permita actuar enviando a los Nazgûl (o al SOC, que viene a ser lo mismo), protegeremos nuestro Mordor particular de manera efectiva.

Por eso, vamos a ver cómo trabaja Snort y su coordinación con un SIEM, como Pandora SIEM.

Cómo funciona Snort

Snort es un software que vigila nuestra red analizando los paquetes que pasan por ella como si fuera un perro policía en el aeropuerto, y que también tiene ciertas capacidades de prevención, por lo que él mismo se autodenomina IPS (Intrusion Prevention System).

El funcionamiento de Snort se basa en reglas, que definen posible actividad maliciosa. Actuando conforme a dichas reglas, cuando detecta algo que coincide con ellas, da la voz de alarma. Como si tuviera esos carteles de «Se Busca» de las pelis del Oeste y fuera contrastándolos con lo que analiza, de modo que puede detectar DDoS, escaneos de puertos, buffer overflows, etc.

Pero no se queda ahí, porque Snort es una herramienta híbrida que combina principalmente esa detección basada en reglas (firmas) con análisis de protocolos y, en cierta medida, detección de anomalías.

Snort usa dos clases de reglas:

- Reglas de la comunidad (Community Ruleset), que puedes descargar y actualizar gratis, ya que son mantenidas por otros usuarios expertos.

- Reglas para suscriptores (Subscriber Ruleset), que son desarrolladas, probadas y aprobadas por Cisco Talos. De esta manera, por un precio mensual, te aseguras una detección similar a la de los clientes de Cisco.

Dentro de esas reglas, se sigue una sintaxis compuesta de una cabecera, o parte inicial, y unas opciones en la parte final de la regla.

Y a la hora de elaborar o modificar esas reglas, es muy importante el comienzo de la cabecera, porque indica la acción que tomará Snort ante lo que sucede. Estas son:

- alert: Registra el paquete y emite una alerta.

- log: Registra el paquete y nada más.

- pass: Ignora el paquete.

Estas son reglas IDS, que detectan y anotan sin hacer nada, pero Snort tiene ciertas capacidades de prevención en sus acciones, como:

- sdrop: Lo más básico, bloquea el paquete y no lo registra.

- drop: El paquete es bloqueado preventivamente y también registrado.

- reject: Lo anterior, más enviar un paquete de vuelta dependiendo del protocolo (reset si es TCP/ICMP o port unreachable si es UDP).

Tras la acción, viene el resto de la cabecera con protocolos, puertos y direcciones de origen y destino, más sus opciones. Así, comprendiendo y usando la sintaxis, podemos escribir reglas de todo tipo, como esta muy básica que avisa de tráfico HTTP:

alert tcp any any -> 192.168.1.0/24 80 (msg:»HTTP Traffic Detected»; flow:to_server,established; sid:100001;)

Básicamente, emite una alerta de protocolo TCP llegado desde cualquier IP y puerto, con un mensaje de que estamos teniendo tráfico HTTP (tras la flecha vemos cómo se centra en tráfico hacia el puerto 80 web). La parte final sid significa Snort ID y sirve para asignar un número a la regla, facilitando su gestión mediante esos identificadores asignados.

Como vemos, este ojo de Sauron es muy versátil, pudiendo crear reglas propias o usando y adaptando los mejores ejemplos de otros. De este modo, Snort permite:

- Ser usuario no registrado y usar libremente las reglas de la comunidad.

- Ser usuario registrado y usar también reglas de Cisco, pero 30 días después que los suscriptores de pago.

- Ser suscriptor de pago (personal o empresarial) y recibir actualizaciones en tiempo real de esas reglas Cisco.

Snort realiza su labor de varias formas:

- En modo Packet Sniffer, donde lee todos los paquetes IP de nuestra red, mostrándolos al usuario en la consola de control.

- En modo Packet Logger, donde guarda en un log todos esos paquetes, para que el administrador sepa quién visita y usa su red, y cómo.

- En modo NIPDS (Network Intrusion and Prevention Detection System). En este caso, el perro no solo «huele y ladra», sino que puede «morder» de manera básica, dejando de ser un IDS puro y actuando para prevenir la intrusión.

Para entidades con infraestructuras sencillas y sin grandes riesgos, esto es genial, porque Snort no solo es agencia de espionaje, sino también policía local que puede hacer «detenciones simples». Sin embargo, muchas organizaciones necesitarán más, porque los ataques sofisticados (como los catalogados en el MITRE ATT&CK) llegan como naves romulanas con dispositivos de ocultación, tratando de evadir con técnicas muy ingeniosas.

Integración de Snort con un SIEM

Snort sobrevuela la red con vista de águila y examina todo, lo cual es genial y también un problema, porque ya sea en modo Sniffer o Logger, analiza cada paquete, generando una enorme cantidad de información y potenciales alertas.

Pero mucha información no es lo mismo que mucho conocimiento.

De hecho, demasiada nos llena el granero de paja, pero nosotros queremos la aguja, y quitarla antes de pincharnos. Ahí entra la integración con un SIEM, experto en convertir información bruta en conocimiento, destilando lo importante y detectando amenazas avanzadas.

Esto es gracias a su capacidad de correlacionar lo que Snort registra en la red, junto a lo que el SIEM recibe de otros elementos de seguridad (como EDRs en equipos, por ejemplo).

Así, aunque la configuración concreta de Snort con un SIEM dependerá del SIEM en sí, el funcionamiento básico es que este último incluya los logs de Snort en sus análisis.

De este modo, el SIEM ve la Matrix completa.

Algunas soluciones, como Pandora SIEM, son capaces de realizar correlaciones globales y utilizar Machine Learning para detectar anomalías complejas, más allá de lo establecido en las firmas de Snort o del ámbito de la red que vigila. De esa forma, pillaremos a la nave romulana oculta cuando invade la Zona Neutral.

Obviamente, podemos mejorar la integración y el trabajo de ambas herramientas aplicando buenas prácticas como:

- Filtrar bien las alertas de Snort. Aunque el SIEM tenga capacidades de análisis y correlación avanzadas, no hay que sobrecargarlo con lo que enviamos, por ejemplo, filtrando tráfico legítimo (como una actualización Windows).

- Actualizar siempre Snort y el SIEM.

- Probar y comprobar a menudo que las funciones de Snort están funcionando y los logs no están en blanco o llenos de esa paja que lastra al SIEM.

- Personalización de reglas y alertas. Cada organización tiene una superficie de amenazas diferente y lo que es prioritario para unas puede ser irrelevante para otras. Por eso, aunque estas herramientas están genial por defecto, el administrador debe modificar reglas existentes o crear otras a medida según el perfil de su organización.

Beneficios de la detección avanzada de amenazas con Snort y SIEM

Las ventajas de usar a la vez Snort y SIEM resultan claras después de lo visto.

- Una visibilidad centralizada de los eventos de seguridad. Porque no todo comienza y termina en la red que vigila Snort, y hay más elementos a correlacionar. Por ejemplo, un malware que, en lugar de introducirse mediante un click de phishing, lo haga a través de un puerto USB, porque alguien ha encontrado un pendrive «inofensivo» que resulta ser un rubber ducky malicioso. De esta manera, tenemos el ojo de Sauron en la red, pero también Palantires como el de Saruman rastreando otros elementos de la infraestructura IT.

- Una detección más sofisticada. Porque no importa lo mucho que personalicemos los ficheros de reglas de Snort, no va a detectar eventos más allá de la red, ni ataques complejos.

- Una automatización de respuestas mediante SIEM. Pudiendo llegar mucho más allá de las capacidades básicas IPS de Snort.

- Una reducción de falsos positivos, alertas y trabajo en general. Debido a que el SIEM es capaz de gestionar la enorme cantidad de información que un IDS suele generar. Así no perdemos vida y dioptrías entre las incontables líneas de los logs.

Los desafíos del uso de Snort con un SIEM

Todo lo anterior es genial, porque podemos convertir nuestro reino IT en una fortaleza, por donde no se van a colar dos hobbits con un anillo que nos traiga la ruina.

Sin embargo, eso tiene un precio y unos desafíos, como:

- La eterna balanza de dinero y conocimiento. Aunque Snort puede ser usado sin coste monetario al ser de código abierto, en la vida nada es realmente gratis y hay que compensar la balanza con conocimientos, tanto a la hora de configurar inicialmente Snort, como en la de adaptar reglas y conectar con el SIEM.

- Mantenimiento y actualización constante.

- Comprobación habitual de que todo funciona bien tras esas actualizaciones o la implantación de una nueva regla.

- El ruido, que se puede paliar con un ajuste fino de configuraciones, reglas avanzadas y personalizadas (usando opciones como threshold para elevar el umbral de alertas) y que, a lo mejor, no sea necesaria una alarma cada vez que haya tráfico HTTP, como en el ejemplo analizado antes.

En definitiva, Snort pone al alcance de cualquier organización capacidades avanzadas de detección de intrusiones en su red. Unido a un SIEM, puede alzar unos poderosos escudos alrededor de nuestra infraestructura IT, pero no es algo plug and play.

Ese es el principal desafío, pero cuando se trata de organizaciones con una IT mínimamente compleja, que quieran seguir metodologías como NIST, estén bajo legislación como la NIS2 o en las que un incidente sale caro, esta combinación es imprescindible.

por Pandora FMS team | Last updated Apr 29, 2025 | Comunidad, Pandora FMS

Madrid, abril de 2025 – La plataforma de monitorización y observabilidad Pandora FMS ha sido reconocida en 35 informes destacados en la edición G2 Spring 2025, consolidando su posición como una de las soluciones más versátiles para la gestión de infraestructuras TI complejas, entornos híbridos y operaciones críticas.

Este reconocimiento refleja la confianza de miles de profesionales técnicos que valoran su rendimiento, escalabilidad y capacidad de adaptación a sectores tan diversos como telecomunicaciones, industria, administración pública o servicios digitales.

Más de 270 menciones y 35 informes clave

Pandora FMS ha sido mencionada en 277 informes G2, con presencia destacada en 35 de los más influyentes, tanto por categoría funcional como por región, segmento empresarial e índices específicos.

Principales categorías funcionales:

- Enterprise Monitoring

- Cloud Infrastructure Monitoring

- Server Monitoring

- Log Monitoring

- Application Performance Monitoring (APM)

- Database Monitoring

- IT Alerting

- Remote Monitoring & Management (RMM)

- SIEM (Security Information and Event Management)

Informes por región y segmento:

- EMEA Regional Grid® Reports

- Small-Business, Mid-Market y Enterprise Grid® Reports

Índices de rendimiento:

- Usability, Results, Relationship, Implementation, Momentum Grid®

Foco en ciberseguridad: 5 informes clave de SIEM

Este año, Pandora FMS consolida su avance en el ámbito de la ciberseguridad con presencia simultánea en cinco informes clave de SIEM:

- Momentum Grid®

- Enterprise Grid®

- Small-Business Grid®

- EMEA Grid®

- Usability Index for SIEM

Una evolución que refuerza su apuesta por una monitorización con detección temprana de amenazas, correlación de eventos, análisis de logs y visibilidad integral, alineada con normativas como NIS2 y DORA, centradas en resiliencia y trazabilidad digital.

“Gracias a Pandora FMS rastreamos en tiempo real nuestros equipos de construcción, como excavadoras y grúas. Ha sido clave para evitar fallos críticos.”

— Loring D., Ingeniero de procesos

Opiniones verificadas: alta satisfacción del usuario

Las valoraciones recogidas en G2 destacan una experiencia de uso sobresaliente:

- 98% considera que el producto avanza en la dirección correcta

- 94% destaca la facilidad para hacer negocios

- 94% afirma que cumple con sus necesidades

Algunas opiniones de usuarios verificados:

“Nos ayuda a garantizar el tiempo de actividad del sistema y mejorar la respuesta a incidentes desde una única consola.”

— Henry R., Administrador de TI

“Lo que más valoramos es la personalización. Creamos paneles a medida e integramos con Slack y Jira sin complicaciones.”

— Nina S., Desarrolladora móvil

“Como proveedor de internet, necesitamos asegurar la disponibilidad de nuestros servidores. Pandora FMS cubre todo: red, servidores, aplicaciones y web services.”

— Christian N., Supervisor de seguridad TI

“Un verdadero software AIO que permite gestionar todo desde una consola unificada, con mapas, alarmas, descubrimiento automático y gran soporte.”

— Pedro G., Desarrollador

Una solución modular, escalable y sin dependencias

Con un enfoque modular, multiplataforma y vendor-neutral, Pandora FMS se adapta a:

- Entornos on-premise, cloud e híbridos

- Sistemas legacy y modernos con contenedores

- Supervisión de redes, servidores, bases de datos, logs, aplicaciones y procesos de negocio

- Integración con herramientas ITSM, CMDB, plataformas DevOps y sistemas de alerta

Todo gestionado desde un único panel de control para mejorar la visibilidad, reducir incidentes y optimizar decisiones operativas.

“Pandora FMS automatiza tareas repetitivas y nos permite ofrecer un servicio de alta calidad en entornos exigentes.”

— Omar B., Ingeniero eléctrico

Posiciones líderes en los informes G2® Spring 2025

Con 277 informes y 167 medallas, Pandora FMS ha alcanzado un nivel sin precedentes, logrando el primer puesto en más de 25 informes clave, superando a competidores consolidados en múltiples categorías funcionales y de experiencia del usuario.

Informes donde Pandora FMS ocupa el primer puesto:

- Momentum Grid® Reports: APM, Enterprise Monitoring, IT Alerting, Server Monitoring

- Usability Index: Server, Enterprise y Cloud Infrastructure Monitoring, SIEM

- Results Index: SIEM

- Small-Business Grid® Reports: Enterprise Monitoring

- Mid-Market Usability Index: Enterprise Monitoring

- Enterprise Relationship Index: SIEM

Informes donde ocupa el segundo o tercer puesto:

- Momentum Grid® Report for Cloud Infrastructure Monitoring

- Relationship Index for Database Monitoring

- Usability Index for APM

- Implementation Index for SIEM y Network Monitoring

- Results Index for Cloud Infrastructure Monitoring

- Small-Business Relationship Index for SIEM

Estos logros posicionan a Pandora FMS como una de las soluciones mejor valoradas por su rendimiento técnico, experiencia de uso, escalabilidad y soporte.

Tecnología española con proyección global

“Los resultados en G2 validan el trabajo constante de nuestro equipo para construir una plataforma flexible, escalable y centrada en el usuario técnico. Seguimos escuchando a nuestros clientes para evolucionar junto a ellos.”

— Kornelia Konstantinova, CMO de Pandora FMS

Con más de 50.000 instalaciones activas en más de 60 países, Pandora FMS continúa su crecimiento como alternativa sólida frente a grandes proveedores globales, ayudando a empresas de todos los tamaños a crear infraestructuras más resilientes, eficientes y seguras.

¿Quieres saber más?

Consulta el perfil oficial de Pandora FMS en G2 y descubre por qué miles de usuarios la consideran una de las soluciones más completas y eficaces del mercado.

Ver opiniones en G2 →

por Pandora FMS team | Mar 11, 2025 | Pandora FMS, Release

En la reciente actualización NG 781 RRR, Pandora FMS ha mejorado significativamente su sistema Discovery mediante la potente funcionalidad NetScan, facilitando aún más la detección automática y monitorización integral de activos tecnológicos en redes complejas.

¿Qué novedades trae NetScan en Discovery?

NetScan permite descubrir automáticamente dispositivos en redes, determinar su topología y aplicar monitorización inmediatamente. Esta función puede configurarse en dos modos, adaptados a diferentes necesidades:

- Modo simple: Detección automática de todas las redes accesibles desde el servidor Pandora FMS, mediante traceroute hacia Internet (8.8.8.8), revisión de la tabla de rutas local y escaneo directo de redes conectadas.

- Modo avanzado: Permite personalizar detalladamente parámetros como redes específicas (CIDR), exclusión de IPs concretas, escaneo SNMP avanzado, WMI, resolución de nombres y detección de sistemas operativos.

Principales ventajas del Discovery actualizado

- Automatización y rapidez: Reduce notablemente el tiempo invertido en procesos manuales.

- Validación y control: Confirma manualmente qué activos se añaden tras el escaneo.

- Mapas de red automáticos: Visualiza instantáneamente la topología de activos descubiertos.

- Reglas avanzadas de autoconfiguración: Aplica automáticamente políticas específicas, ejecuta scripts o lanza eventos personalizados según activos detectados.

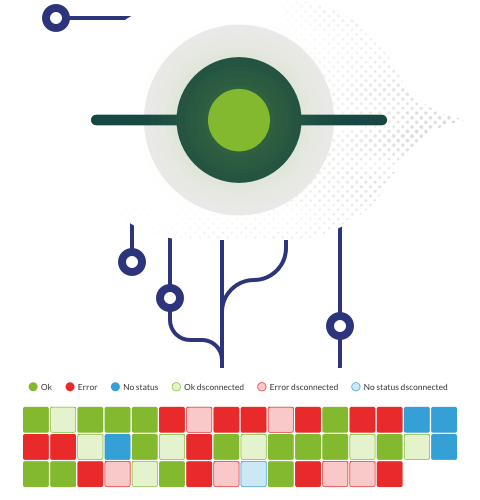

Mejoras visuales y funcionales en los mapas de red

Se han rediseñado los mapas de red para ofrecer mejor experiencia visual y navegación:

- Rejilla intuitiva para movimiento y organización.

- Límites visibles claros para una gestión más precisa.

- Generación dinámica y optimizada con métodos como spring 1 y radial dynamic.

Estos mapas están sincronizados con los resultados del Discovery, actualizándose automáticamente con cada ejecución.

Cómo sacarle el máximo partido

Esta versión está especialmente orientada a administradores con entornos grandes o dinámicos, optimizando recursos mediante automatización del descubrimiento inicial de activos y facilitando así una monitorización más proactiva y estratégica.

La actualización Discovery en Pandora FMS NG 781 RRR transforma la gestión operativa, aumentando considerablemente la eficiencia desde el primer momento.

Explora todas las novedades en nuestra nota de release completa y optimiza tu monitorización desde hoy mismo.

por Isaac García | Mar 10, 2025 | Pandora FMS

Tengo la sospecha nada secreta de que el sueño de todo el que trabaja con tecnología es la computadora del Enterprise en Star Trek. Controlar escudos, comunicaciones, motores y todo lo necesario desde un mismo lugar. Y además, hablando… «Un ‘botón’ para controlarlos a todos», tal y como susurraría Sauron. Pero hasta que esa utopía se haga realidad, al menos podemos implementar una infraestructura hiperconvergente en la tecnología de nuestra organización (HCI en sus siglas en inglés).

Esta infraestructura hiperconvergente permite gestionar de forma unificada:

- Computación.

- Redes.

- Almacenamiento.

Mucho menos atractivo que navegación o motores de curvatura, pero la clave es: ¿cómo manejar de forma homogénea aspectos tan diferentes?

Con una solución habitual en tecnología, creando una capa de abstracción. Introduciendo un intermediario, un software que aglutine todo esto tan distinto, mediante virtualización. El hipervisor, como parte de esta virtualización, actúa como el facilitador que permite gestionar todos estos recursos de manera unificada desde un mismo sitio. Una especie de «traductor universal», otro sueño trekkie.

Así, múltiples tecnologías (hiper)convergen en un lugar y una forma de control.

Esto no es solo una evolución tecnológica, sino un cambio de paradigma: pasar de gestionar «piezas sueltas» a orquestar un organismo unificado, donde la infraestructura responde como un todo.

Ventajas de una infraestructura hiperconvergente frente a una tradicional

Para quien lidia con el caos heterogéneo de una infraestructura tecnológica tradicional, lo anterior habrá iluminado varias bombillas en su mente con las ventajas de una solución así, como son:

La simplicidad. De infraestructura y manejo, de modo que no tenemos que saber de cada uno de los elementos que la componen, integrar hardware heterogéneo o controlar mil actualizaciones de firmware, sino conocer el software que controla todo.

Veamos una comparación sencilla que ilustre esta ventaja:

|

Infraestructura Tradicional

|

HCI

|

|

Silos fragmentados: Servidores físicos, almacenamiento (SAN/NAS) y redes gestionados por equipos y herramientas separadas.

|

Unificación: Computación, almacenamiento y redes integrados en nodos estandarizados gestionados por software.

|

|

Ejemplo: Un clúster VMware con almacenamiento NetApp y switches Cisco independientes.

|

Ejemplo: Nutanix o VMware vSAN, donde el almacenamiento se distribuye en discos locales de los nodos.

|

La escalabilidad. Pudiendo redimensionar de manera modular, o añadir y quitar prestaciones según necesitemos, de forma más rápida y menos costosa. Ejemplo:

|

Infraestructura Tradicional

|

HCI

|

|

Añadir almacenamiento requiere expandir el SAN, escalar computación implica nuevos servidores.

Y eso, con el riesgo de overprovisioning, al comprar capacidad «por si acaso».

|

Agregar nodos estandarizados incrementa todos los recursos (CPU, almacenamiento, red) simultáneamente.

En este caso, escalamos según demanda, sin recursos desperdiciados (ni su sobrecoste, claro).

|

La eficiencia. Que permite gestionar de manera centralizada y sencilla, automatizar, usar menos hardware…

|

Infraestructura Tradicional

|

HCI

|

|

Múltiples consolas: vSphere para VMs, NetApp OnCommand para almacenamiento, Cisco Prime para redes…

|

Gestión unificada: Una interfaz para aprovisionar, gestionar y monitorizar toda la infraestructura.

|

|

Tiempos de respuesta lentos: Coordinar equipos para resolver incidentes.

|

Automatización nativa: Políticas predefinidas (ej: auto-reparación de nodos).

|

Respecto a qué solución de HCI elegir, cada organización debe considerar sus necesidades y cómo se adaptan las diversas opciones existentes. Algunas de ellas son:

- VMware vSAN. Especialmente indicada para quienes ya estén familiarizados con las soluciones VMware.

- Nutanix. Para quien depende mucho de la nube e infraestructuras multi-cloud, por ejemplo.

- Microsoft Azure Stack HCI. Dentro de Azure Local, para el omnipresente ecosistema de Redmond en muchas organizaciones.

- HPE SimpliVity. Con su apuesta por IA, tendencia cada vez más presente en estas soluciones.

Pero sea cual sea la elegida, todas tienen un desafío común…

El desafío de la monitorización de Infraestructuras Hiperconvergentes

La gran ventaja de la HCI es que tienes todo en un mismo lugar. Su gran reto es que tienes todo en un mismo lugar.

No, lo anterior no es una errata.

El hecho de que todo lo importante esté en un solo «sitio», plantea el desafío de monitorizarlo adecuadamente, por la enorme cantidad de factores diferentes a controlar.

Todo está bajo un mismo paraguas, pero ese todo es mucho, y puede resultar apabullante por la cantidad de información y datos. Es el concepto de métrica overload, que se resume en que, en medio de un mar de indicadores, es fundamental distinguir las gotas importantes, pero resulta complicado.

Ahí radica el valor crítico de un sistema especializado, como Pandora FMS que, de una forma similar a cómo la HCI facilita la gestión de infraestructura, esta herramienta también nos facilita monitorizar de forma sencilla las múltiples variables críticas.

Los retos en la monitorización y observabilidad en HCI

Quienes trabajan con HCIs suelen encontrar ciertos problemas habituales, derivados de la naturaleza de la solución, ya que algunas capas críticas quedan algo más opacas debido a la integración.

Esto genera desafíos de monitorización, como por ejemplo:

- Falta de visibilidad sobre el rendimiento en infraestructuras hiperconvergentes. Es genial que todo funcione unificado, pero ¿funciona bien? ¿Tenemos los indicadores clave de rendimiento siempre a la vista? ¿Alertas automatizadas para que, cuando algo suceda, lo sepamos al instante?

- Dificultades en la predicción de degradaciones. Dos máquinas virtuales, por ejemplo, compiten por almacenamiento en un mismo nodo HCI, eso puede degradar la infraestructura global fácilmente pero, ¿cómo sabemos si ocurrirá? ¿Cómo sabemos si ese es el motivo real de la bajada de rendimiento que estamos experimentando?

- La necesidad de correlacionar métricas entre almacenamiento, redes y virtualización.

- Falta de visibilidad granular. Si tenemos un problema de latencia, por ejemplo, ¿cómo sabemos si es un cuello de botella de la red física que hay por debajo o un problema de software?

- El problema de la interdependencia de componentes. Ya que un fallo en un nodo HCI afecta simultáneamente a computación, almacenamiento y redes, provocando un efecto dominó.

- Métrica overload. Al monitorizar no solo VM/containers, sino también hipervisor, pool de almacenamiento distribuido, tráfico interno East-West o políticas de Quality of Service (QoS), lo que puede sobrecargar enseguida.

¿Cómo ayuda Pandora FMS a la monitorización de HCI?

Pandora FMS se erige como la clave para superar esos retos, porque los hemos vivido y esa frustración nos guió para crear una solución experta. Porque las soluciones HCI integran cierta monitorización, pero suele tener unas limitaciones comunes:

- Prestaciones básicas. Con monitorización sencilla, alertas simples preconfiguradas e integración limitada. Buena para su ecosistema, pero cuando también hay que jugar con tecnologías externas, adiós a poder hacerlo en equipo.

- Visión fragmentada. Al no correlacionar datos de otras posibles infraestructuras (¿y si no podemos evitar ese servidor legacy del sótano, que nadie sabe cómo apareció, pero es vital y tiene ese aterrador cartel de «no desenchufar»?). No solo eso, la fragmentación de dashboards la tendremos también en un entorno Multivendor (Nutanix + Proxmox, por ejemplo).

- Poca personalización. Por ejemplo, cuando precisamos alertas personalizadas para nuestras operaciones específicas como organización.

Es ahí donde una herramienta como Pandora FMS, que permite monitorización experta de infraestructuras hiperconvergentes, soluciona eso permitiendo:

- Observabilidad en tiempo real. Unificando métricas multientorno, ya que las HCI rara vez existen aisladas. Así, tenemos una supervisión en entornos híbridos y multi-cloud, por ejemplo.

- Monitorización de virtualización. Gracias a su integración con VMware, Proxmox, Nutanix y KVM.

- Supervisión de almacenamiento y redes. En cuanto a latencia, disponibilidad y uso de recursos.

- Detección de anomalías e incidentes. Con alertas y correlación de eventos que ayudan a encontrar causas raíz, no solo detectar síntomas.

- Integración con SIEM y logs. Proporcionado seguridad y capacidad de auditoría de eventos. Indispensable para actividades críticas que, por ejemplo, estén bajo la normativa NIS2 y su exigencia de pasar controles. Buena suerte unificando los logs necesarios de mil sitios diferentes bajo la mirada del auditor que, por alguna razón, nunca pestañea.

- Análisis de tendencias y capacity planning. Con la implementación de Machine learning para una optimización más sencilla y adecuada de esa capacidad.

En algo tan crítico como monitorizar infraestructuras hiperconvergentes, no solo es necesario «llamar al especialista», como Pandora FMS. Es que su implementación va más allá, porque permite tener toda la información crítica en un punto, tanto de la HCI, como del resto de elementos clave de nuestra tecnología, como equipos portátiles, otros servidores o incluso móviles.

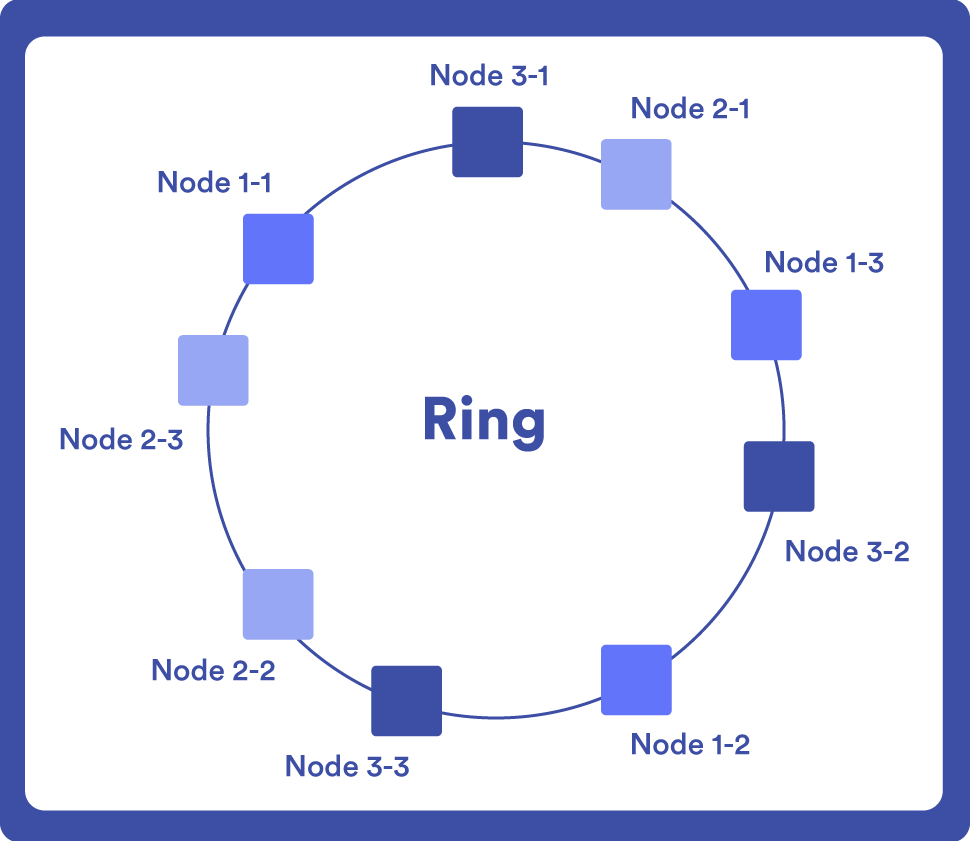

Eso completa de forma natural el círculo de la filosofía HCI, porque podemos decir que Pandora FMS permite a su vez la hiperconvergencia de la monitorización en un solo lugar.

El ansiado «Anillo Único» para dominarlos a todos.

(Pandora FMS no incluye un anillo mágico, el equipo legal me obliga a aclarar esto).

Beneficios de usar Pandora FMS en entornos HCI

Las decisiones serán tan buenas como la información que tengamos para tomarlas, y ese es uno de los valores estratégicos principales que proporciona Pandora FMS.

En su monitorización de HCIs, eso se traduce en estos beneficios directos:

- Reducción del tiempo de respuesta ante incidentes.

- Optimización del rendimiento y predicción de fallos.

- Mayor seguridad con correlación de eventos y supervisión de actividad sospechosa.

- Compatibilidad con múltiples tecnologías sin necesidad de herramientas adicionales.

- Reducción de costes operativos, mediante automatización y mejor distribución de recursos.

- Escalabilidad sin impacto en la operativa.

Y sobre todo, sensación de control, cordura y paz mental, porque sabes qué está pasando en todo momento.

En un entorno cada vez más complejo y diverso, las infraestructuras hiperconvergentes contribuyen a optimizar y simplificar. Y como si estuviéramos en la película Origen de Christopher Nolan, podemos ir un nivel más allá en esa gesta por la hiperconvergencia, optimizando y facilitando también la monitorización de dichas infraestructuras con Pandora FMS.

Sin eso, es imposible operar de una forma óptima que nos sitúe en la punta de lanza de nuestra actividad.

Y si quieres saber más sobre Pandora FMS en Infraestructuras Hiperconvergentes, no dudes en contactar con nosotros, porque te demostraremos estas palabras con acciones.

por Isaac García | Mar 3, 2025 | Pandora FMS

Los endpoints son el blanco principal de los ciberataques. Los datos más conservadores cuantifican que, entre un 68% y un 70% de las brechas, comienzan en estos dispositivos. Por eso, la implantación de un EDR (Endpoint Detection and Response) es imprescindible para protegerlos en el contexto actual de amenazas informáticas.

Este EDR es una herramienta avanzada de seguridad que se instala en los dispositivos finales de la infraestructura tecnológica (ordenadores personales, servidores, teléfonos…) y que monitoriza su actividad en tiempo real, sabiendo qué sucede exactamente en cada uno de esos endpoints.

Esto hace posible detectar, analizar y responder a amenazas de seguridad de manera proactiva e inteligente. Y en caso de incidencia, también permite al equipo de respuesta tener toda la información necesaria para investigarlo y solventarlo.

Esto va más allá de las capacidades de un antivirus, solución tradicional para la protección de algunos endpoints, pero que resulta insuficiente para el contexto de seguridad actual en las organizaciones.

Cómo funciona un EDR

Las prestaciones de un EDR y la seguridad que ofrecen en el endpoint dependen en última instancia de cada fabricante, pero todos se basan en tres pilares fundamentales, que permiten comprender su funcionamiento y la protección que ofrecen:

- Monitoreo constante de la actividad: desde los procesos, hasta las conexiones del dispositivo, recopilando datos y analizándolos de manera inteligente.

- Detección de amenazas: cuando lo anterior alerta sobre comportamientos anormales, como movimientos laterales, malware, intentos de phishing y otras acciones maliciosas.

- Respuesta automática ante esas amenazas: como aislar el dispositivo comprometido del resto de la red, bloquear procesos con actividades dudosas o eliminar archivos dañinos.

Los EDR se diferencian de los antivirus tradicionales, tanto en capacidades de detección (afrontando amenazas desconocidas y sofisticadas), como de respuesta, siendo capaces de aislar un dispositivo de la red, por ejemplo. En contraposición, un antivirus, como mucho, pone en cuarentena o borra un archivo infectado.

Así, un actor malicioso puede haber creado un malware nuevo que extraiga datos críticos de una organización, como credenciales o información privilegiada.

Mientras que un antivirus no reconocerá el malware y le dejará hacer, un EDR puede detectar, entre otras cosas, la actividad de ese archivo malicioso, como puede ser la fuga de información. Así, puede detenerla si detecta una conexión desconocida y un flujo masivo de datos hacia ella.

Algo similar ocurre si esa exfiltración de datos se produce, por ejemplo, por la acción de un empleado descontento, sin malware de por medio.

Este usuario puede tratar de copiar información a un dispositivo externo y, mientras que un antivirus no reaccionará ante eso, un EDR puede detectar la conexión de una llave USB o el comportamiento anómalo de una copia de gran volumen de datos, y actuar en consecuencia ante este acto sospechoso.

La diferencia entre gestión de seguridad y gestión de infraestructura

Para una óptima protección de endpoints y de nuestro sistema en general, es importante comprender esta diferencia y conseguir que ambos conceptos estén alineados.

La gestión de la infraestructura tecnológica tiene como fin que esta funcione adecuadamente y ayude a los objetivos de la organización. Pero esto quedará comprometido si no tiene también la seguridad en mente.

Por su parte, la gestión de la seguridad implica poner los medios y políticas que protejan la infraestructura, como una integración de SIEM (Security Information and Event Management) y EDR, por ejemplo. Sin embargo, no es lo mismo poner medidas para proteger un edificio de paja construido de cualquier manera, que para un castillo de piedra bien planificado.

Así una gestión de infraestructura tecnológica adecuada facilitará:

- La gestión de la seguridad.

- El trabajo integrado de EDR y SIEM.

- La labor de nuestro blue team en caso de tenerlo.

- La respuesta a posibles incidentes.

Veamos un ejemplo de la diferencia que marca una infraestructura bien gestionada de una desprotegida.

Imaginemos una gestión con una segmentación adecuada de redes, un buen control de accesos de dispositivos y una política de parcheo constante.

Incluso en el caso de que algún elemento de la infraestructura falle (como la actualización tardía del firmware de un dispositivo IoT ante una vulnerabilidad), si ese dispositivo ha sido configurado con políticas adecuadas de red y acceso, contribuiremos a la seguridad. Así, reduciremos las probabilidades de que un actor malicioso que haya comprometido ese endpoint pueda moverse lateralmente a otro elemento más crítico de la red.

Si, además de esa gestión adecuada de la infraestructura, tenemos una buena gestión de seguridad con un EDR integrado con SIEM, se detectará el intento de movimiento extraño, avisando y mitigando.

Pero si ese dispositivo IoT sigue teniendo configurado el usuario y contraseña de fábrica (algo demasiado habitual, por desgracia) o bien no se ha limitado a qué tiene acceso en nuestra red, dicho actor malicioso tiene enormes posibilidades de moverse por ella hasta elementos fundamentales, o comprometer el dispositivo de otras maneras, como grabarnos con una webcam.

Enfoques desde la gestión de infraestructura para fortalecer la seguridad

Siguiendo con el símil anterior, ¿cómo levantamos nuestro castillo con piedra robusta y un diseño resistente?

Una gestión de infraestructura así pasaría por estrategias prácticas como estas:

- Políticas estrictas de actualización y parcheo: para evitar la acción de malware o técnicas que exploten vulnerabilidades de versiones antiguas. Esto implica actualización tanto de software como de firmware en los endpoints.

- Diseño óptimo de redes: segmentándolas adecuadamente y con la política de que cada dispositivo acceda solamente a lo mínimo necesario para funcionar correctamente, tanto en lo que se refiere a datos, como a otros dispositivos.

- Implementación de soluciones SIEM: que recoja información para el Network Operations Center (NOC) de lo que sucede en nuestra infraestructura, la unifique, analice y alerte ante cualquier hecho sospechoso.

- Políticas de supervisión y análisis de logs: que detecten anomalías en esos registros. Actualmente las políticas de seguridad permiten a las empresas cumplir con los más altos estándares y certificaciones de seguridad como la ISO 27001 y normativas a nivel gubernamental como la nueva NIS2, que muchas empresas ya están comenzando a implementar.

Con estas premisas, nuestra infraestructura será más sólida por sí misma a ataques, a la vez que cumple su objetivo principal, apoyar los objetivos y el trabajo de la organización.

Se suele hablar de la elección entre seguridad y conveniencia, o seguridad y rendimiento, pero es una falsa dicotomía. Una buena gestión de infraestructuras apoya seguridad y funcionamiento, no tiene que elegir. Aunque las infraestructuras actuales de los sistemas y los entornos de naturaleza híbrida constituyan un bache a sortear para obtener una visión unificada, Pandora FMS unifica fuentes de datos y permite llevar a cabo una gestión centralizada.

Cómo abordan la seguridad diferentes EDR y Antivirus (A/V)

Aunque hablamos de EDRs y antivirus como de dos enfoques generales en seguridad de endpoints, es cierto que no todo es homogéneo dentro de cada opción.

Por eso, es interesante conocer las principales características de cada solución, y cómo pueden variar en ocasiones según el fabricante de la misma.

|

EDR

|

Antivirus

|

|

Monitorización constante de la actividad en los endpoints para detectar comportamientos sospechosos.

|

Escanea archivos y aplicaciones en busca de firmas de malware conocidas.

|

|

Utiliza análisis de comportamiento para identificar amenazas desconocidas.

|

Utiliza bases de datos de firmas para identificar malware conocido.

|

|

Algunas opciones usan IA predictiva, como Pandora FMS, para detección y toma de decisiones.

|

Algunos fabricantes usan heurística (reglas predefinidas de comportamientos sospechosos), una tecnología menos avanzada con más falsos positivos.

|

|

Respuesta automatizada sofisticada: puede aislar dispositivos, bloquear procesos sospechosos y generar alertas avanzadas (el alcance de dicha respuesta dependerá de las prestaciones de cada fabricante).

|

Respuesta automatizada limitada a cuarentena o eliminación de archivos infectados.

|

|

Capacidad forense avanzada, registrando todo lo ocurrido para facilitar auditorías o la labor del equipo de respuesta a incidentes.

|

Capacidad forense limitada a registrar detecciones básicas.

|

|

Protección activa y reactiva.

|

Protección reactiva basada en el fichero de firmas.

|

|

Elevada capacidad de integración con SIEM y la infraestructura en general.

|

Integración limitada.

|

Ese último aspecto de integración de SIEM y EDR es crítico hoy y la clave de la seguridad en un entorno tan cambiante.

Sin embargo, en el otro plato de la balanza, la capacidad de los antivirus es mucho más reducida, tanto en información que pueden enviar a un SIEM, como en capacidad de integración con estos. Además, algunos antivirus son proclives a no llevarse bien con el resto de la infraestructura tecnológica o de seguridad, produciendo problemas de compatibilidad con firewalls u otras herramientas de protección.

Ventajas e inconvenientes de un EDR frente a un antivirus tradicional

Lo anterior no significa que todo sean puntos positivos en el caso de los EDRs, de modo que un análisis imparcial debe poner sobre la mesa dichas ventajas, pero también inconvenientes y desafíos.

Ventajas de un EDR frente a un antivirus

- Mayor capacidad de detección y protección ante amenazas, conocidas o no.

- Mayor capacidad de respuesta automatizada ante incidentes.

- Mayor capacidad de gestión de seguridad gracias a una visibilidad detallada sobre qué ocurre exactamente en cada endpoint.

Desventajas de un EDR frente a un antivirus

- Más complejo de implementar y gestionar.

- Requiere de personal capacitado para interpretar y responder a los incidentes. También para su instalación e integración, especialmente en soluciones on-premise.

- Mayor coste económico por regla general.

Ventajas de un antivirus frente a un EDR

- Facilidad y rapidez de implementación.

- Eficaz contra malware conocido y amenazas comunes.

- Más económico que los EDR, e incluso gratis.

Desventajas de un antivirus frente a un EDR

- Protección insuficiente en el contexto actual de ciberseguridad para casos más allá de un usuario individual de bajo riesgo.

- Puede generar problemas de gestión, como falsos positivos o interacciones con otras aplicaciones.

- Capacidad de respuesta muy limitada ante sucesos de seguridad.

Enfoques prácticos para la seguridad de endpoints en entornos on-premise

Ya sea por exigencias legales, como protección y gestión de datos sensibles, o por estrategia tecnológica, como la necesidad de un mayor control o rendimiento de los equipos, las soluciones on-premise ganan atractivo frente al enfoque de 100% en la nube.

Por eso, es interesante tener en cuenta estas estrategias fundamentales para implementar con éxito soluciones EDR en estos entornos on-premise.

- Análisis y evaluación de necesidades de nuestra infraestructura. Toda acción realmente estratégica, del tipo que sea, empieza por este paso. Debemos conocer bien nuestra red, sus activos críticos y las principales amenazas a las que nos enfrentamos, lo que conformará una parte importante de nuestro threat model particular, que será diferente del de otras organizaciones.

- Elección de la solución EDR adecuada. Según las conclusiones del punto anterior y nuestro presupuesto.

- Poner en marcha una fase de pruebas. En un entorno controlado que nos permita ver si la elección ha sido adecuada.

- Establecer una estrategia de despliegue gradual. Aunque las pruebas hayan sido exitosas, es importante ir poco a poco, para localizar y corregir los inconvenientes y desafíos que aparecerán inevitablemente.

- Integración con el resto de herramientas. En especial con un SIEM, configurando reglas y probando que funcionen.

- Establecer una buena política de monitoreo y auditoría. La herramienta no es nada sin un buen proceso detrás, con lo que es conveniente sistematizar las labores de supervisión.

- Establecer planes de contingencia. ¿Qué ocurriría si todo fallara? La seguridad debe hacerse siempre esta pregunta, incluso cuando aplique las mejores prácticas, ya que la probabilidad de eventos imprevistos de cisne negro nunca es cero. Para esos casos, debemos tener un plan de «botón rojo» que permita continuar el funcionamiento y la restauración de datos e infraestructura en el menor tiempo posible.

Si bien la noción on-premise vuelve a ganar adeptos, nada es una cuestión de absolutos, con lo que se puede optar por una solución híbrida.

Por eso, estas son las diferencias entre una implementación 100% local (también conocida como on-premise), una híbrida y una 100% en la nube.

- 100% local: la infraestructura de seguridad se encuentra dentro de las instalaciones de la organización. Su beneficio principal es el control total sobre datos, dispositivos y seguridad, así como un probable mayor rendimiento y menor latencia. A cambio, su desafío es que es más costosa en cuanto a recursos económicos y humanos. Estos, además de ser más numerosos, deben tener también mayor capacitación y realizarán una labor más intensiva de gestión. Hay que destacar que muchas veces por requerimientos de ENS o NIS2 ciertas piezas de infraestructura deben ser on-premise.

- Implementación Híbrida: combina elementos on-premise y en nube. La clave es aprovechar lo mejor de ambos mundos y, por ejemplo, que los datos sensibles se mantengan en local, pero que el análisis de amenazas y su respuesta se gestionen en la nube. Una buena planificación híbrida nos da la ventaja de reducir costes y aumentar la flexibilidad. El mayor desafío es que no dependeremos solamente de nosotros, existiendo puntos de fallo que escaparán a nuestro control.

- 100% nube: Su principal beneficio es la reducción de coste económico y humano, así como una menor complejidad tecnológica, que descansa en el proveedor de la nube. La otra cara de la moneda es que ponemos lo más importante en manos ajenas, en las que deberemos confiar. Y en caso de incidencia, dependeremos también de su capacidad de respuesta.

Esto no es cualquier cosa y en la mente de todo responsable de seguridad resuenan los ecos del 19 de julio de 2024. Aquella mañana, millones de sistemas Windows mostraron la famosa pantalla azul de fallo catastrófico, provocada por una mala actualización remota de CrowdStrike, uno de los EDRs más famosos.

Cómo complementa la seguridad de los endpoints el uso de Pandora FMS

Durante todo este recorrido, se ha hecho hincapié en que las soluciones de EDR son más avanzadas, pero también tan efectivas como la capacidad de supervisión y detección de amenazas en tiempo real que tengamos.

Ahí es donde conecta el siguiente eslabón de la cadena de seguridad, con un sistema de monitorización flexible como Pandora FMS, que complementa la seguridad de los endpoints.

¿Cómo?

- Mediante la integración con Pandora SIEM, que recoge y centraliza todo, para saber siempre de un vistazo lo que ocurre.

- Con el análisis de registros y auditorías, que refuerzan aún más la protección de endpoints. Cada empresa es un mundo y sus amenazas propias, también. Eso implica que debemos conocer exactamente lo que ocurre en nuestra infraestructura, sus particularidades propias y sus desviaciones sospechosas frente a la norma, que serán diferentes de las de otros.

- Con una correlación avanzada de eventos de seguridad, para identificar eficazmente esas anomalías en nuestro caso concreto, respondiendo de forma adecuada.

- Con una integración sin fisuras con dispositivos de red y firewalls, asegurando que todo funcione suavemente.

- Con una recogida de eventos desde agentes en endpoints multiplataforma (Windows, macOS o Linux).

Como hemos visto, para una organización que se tome en serio la seguridad, el uso de EDR, más una estrategia SIEM, es imprescindible.

El entorno de ciberamenazas cambia mucho y muy rápido. Los ataques son cada vez más frecuentes y los actores maliciosos, más sofisticados. Apoyados por la irrupción de las IAs, estas permiten, incluso a adversarios con poco conocimiento técnico, modificar malware para comprometer las defensas y evadir sistemas tradicionales de detección como antivirus, por ejemplo. O incluso crear nuevos programas maliciosos desde cero.

Así, amenazas que antes eran territorio exclusivo de actores con gran conocimiento y motivación, ahora están al alcance de muchos. De ahí la importancia de diseñar nuestra infraestructura con la resiliencia en mente e integrar medidas de seguridad capaces de anticiparse a ese panorama cambiante.

Sin eso, nos adentraremos desprotegidos cada mañana en un contexto más hostil y complejo que nunca.

por Isaac García | Feb 26, 2025 | Pandora FMS

Los tiempos en los que un antivirus y sentido común garantizaban la ciberseguridad de una organización, quedan lejos en el retrovisor. Especialmente, si trabajas en un sector crítico. Por eso, la Directiva NIS2 (2022/2555) de la Unión Europea establece las obligaciones de ciberseguridad para dichas actividades clave… y las consecuencias de no cumplirlas.

Estas últimas son importantes, así que analicemos la normativa, cuándo corresponde aplicarla y cómo debemos hacerlo.

Qué es la Directiva NIS2 y qué cambia respecto a NIS1

Los actores maliciosos cada vez más sofisticados (estatales o no), la omnipresencia del malware o la proliferación de brechas de datos dejan clara una cosa:

La Unión Europea debe mejorar su gestión de ciberseguridad en sectores críticos y la directiva NIS1 ya no era suficiente.

Por eso, en noviembre de 2022 se aprobó la nueva directiva NIS2, que afecta a las llamadas entidades esenciales e importantes, y los diversos países ya la están aplicando con este horizonte temporal:

- 16/01/2023. Entrada en vigor.

- 18/10/2024. Derogación de la NIS1. Adopción y publicación de las medidas por estados miembros.

- 17/01/2025. Comienza la actuación de las redes estatales de CSIRT (Computer Security Incident Response Team) y se establece el régimen sancionador.

- 17/04/2025. Fin del plazo para elaboración del registro de entidades esenciales e importantes. Comunicación del número de las mismas a la Comisión y Grupo de Cooperación. Comienzo de las evaluaciones de las estrategias nacionales de ciberseguridad (al menos cada 5 años).

¿Y qué cambia respecto a la NIS1?

- Requisitos de seguridad más estrictos.

- Mayor control de cumplimiento.

- Sanciones más elevadas (máximo 10 millones de euros o 2% de la facturación a entidades esenciales y 7 millones de euros o 1,4% de facturación a entidades importantes).

- Ampliación de lo que se considera entidad esencial o importante.

Esto es clave, porque muchas organizaciones que no se veían obligadas a la NIS1 sí entran ahora dentro del ámbito de aplicación de la NIS2.

Quién está obligado a cumplir la Directiva NIS2

La directiva se aplica con carácter general a empresas medianas y grandes, ya sean públicas o privadas, que operen en sectores de alta criticidad (los establecidos en el Anexo I de la Directiva) y otros sectores críticos (los incluidos en el Anexo II).

Así pues, lo primero a considerar es el tamaño de la organización:

- Mediana empresa es la que tiene entre 50 y 250 empleados y un volumen de negocio de hasta 50 millones de euros, o un balance que supere los 43 millones.

- Gran empresa es la que sobrepasa esas condiciones: más de 250 empleados y volumen de negocio o balance de 43 millones de euros o más.

¿Y cuáles son esos sectores críticos y altamente críticos?

La lista es más amplia que la NIS1 que, por ejemplo, consideraba al sector energía como altamente crítico. Pero ahora, la NIS2, dentro de dicho sector, ha añadido a los sistemas urbanos de climatización o hidrógeno, que la NIS1 excluía.

El Anexo I de alta criticidad incluye:

- Energía.

- Transporte.

- Sanidad.

- Banca.

- Agua potable y residual.

- Infraestructuras financieras y digitales (proveedores de dominios, cloud, etc.).

- Gestión de servicios TIC B2B.

- Algunas Administraciones públicas.

- Espacio.

En el Anexo II de sectores críticos encontramos:

- Servicios postales y de mensajería.

- Gestión de residuos.

- Fabricación, producción y distribución de sustancias químicas y alimentos.

- Fabricación de productos clave (sanitarios, eléctricos y electrónicos, informáticos, maquinaria y transporte).

- Proveedores de servicios digitales (buscadores, marketplaces en línea y proveedores de redes sociales).

Si una organización es mediana o grande, y opera en estos ámbitos, la NIS2 debe estar como lectura en su mesilla de noche.

Nuestra recomendación práctica es descargar esta guía del INCIBE que detalla más claramente esos Anexos con actividades. Así solo perderemos las dioptrías justas entre las líneas de la Directiva.

Cumplimiento de la NIS2 por pequeñas empresas y microempresas

Tras lo anterior, la pregunta es clara: «Si soy microempresa o pequeña empresa, ¿entonces no me afecta?».

La respuesta correcta es la palabra más temida: «Depende».

Porque la ley dice que pequeñas empresas y microempresas que tengan un papel clave para la sociedad, la economía o ciertos tipos de servicios fundamentales, también están obligadas.

Son entidades críticas (definidas en el artículo 6 de la directiva UE 2022/2557), las que prestan servicios esenciales y en las que “un incidente tendría efectos perturbadores significativos”. En ese caso, aunque fuera una organización de menor tamaño, también estaría bajo la directiva.

Pero la propia NIS2, en su consideración inicial número 20, comprende implícitamente que esta definición es compleja. Por eso, cada estado miembro de la unión debe decidir si una pequeña empresa es crítica y proporcionarle pautas e información para que pueda cumplir la ley.

Recomendación práctica: Si se sospecha que lo anterior podría aplicarse a una organización, por pequeña que sea, mejor consultar con el INCIBE u otro organismo similar del país en cuestión.

Requisitos clave de la NIS2 en ciberseguridad

Si se está obligado, la siguiente cuestión lógica es: «¿A qué, exactamente?».

La normativa establece unos mínimos en su artículo 21.2. Estos pretenden que la seguridad europea esté unificada y abarcan todo el proceso de la misma: desde prevención a respuesta ante incidentes, pasando por defensa de sistemas de información, garantía de continuidad de la actividad y concienciación y formación del personal.

Cada país de la UE debe integrar la NIS2 en sus leyes, y la directiva tiene un margen a la interpretación, lo que provoca inseguridad en el día a día de los CISOs. Sobre todo, cuando se establece que las medidas deben ser: proporcionadas al tamaño, coste y riesgo de la actividad y tener en cuenta el estado de la técnica.

Como pasa siempre en tecnología, no puedes dar indicaciones prácticas concretas porque, en el momento en el que las pones en un papel, para entonces seguramente hayan quedado obsoletas. De ahí lo de “tener en cuenta el estado de la técnica”, como frase para decir que debemos estar a la vanguardia de la misma.

Además, qué es proporcionado o no puede quedar a discreción de quien aplica la norma, de modo que mejor curarse en salud con estas consideraciones prácticas.

Seguridad de sistemas según la NIS2

Debemos demostrar que somos capaces de defender la organización crítica, y eso implica dos vertientes.

La primera es construir una infraestructura fuerte, un castillo de murallas resistentes bien gestionado por nuestro NOC (Network Operations Center), lo que significa principalmente:

- Un hardening de servidores y endpoints, blindando cada elemento con las mejores prácticas.

- Una buena gestión de los accesos a esas murallas, con autenticación multifactor y una política estricta de accesos e identidades, tanto de usuarios como de dispositivos.

- Sistemas de cifrado, backup, redundancias y lo necesario para la resiliencia y continuación de las operaciones que exige la NIS2.

La segunda vertiente es que, una vez construidas unas murallas robustas, las defendamos activamente, lo que implica:

- El uso de EDR (Endpoint Detection and Response).

- Sistemas de detección y prevención de intrusiones (IPS/IDS) para una monitorización de seguridad adecuada.

- Uso de SIEM (Security Information and Event Management).

Actuación y gestión de incidentes según la NIS2

Este es otro punto clave de la ley, que exige:

- La comunicación rápida y clara de dichos incidentes (al CSIRT ya nombrado) en 24 horas o menos desde el descubrimiento.

- La gestión adecuada de los mismos.

Considerando lo cuantiosas que son las sanciones de la NIS2 por alguna dejación en estos aspectos, es interesante profundizar un poco más.

SIEM e IPS/IDS como elementos clave para cumplir la Directiva NIS2

Para una organización crítica es imprescindible el uso de sistemas SIEM y de detección de amenazas a la hora de una defensa suficiente.

En combinación con los EDRs que protegen los endpoints, y los IDS e IPS que operan a nivel red y host, un sistema como Pandora SIEM es el equivalente al cerebro de tu operación de seguridad, ya que:

- Recolecta logs: De redes, servidores y hasta la cafetera de la oficina, porque se nos ocurrió comprarla «inteligente».

- Correlaciona eventos: Si alguien en Bangladesh accede al servidor en Barcelona y ese «empleado» descarga un archivo extraño, el SIEM une los puntos y actúa, alertando y mitigando. Las funcionalidades IA de Pandora, por ejemplo, hacen que esa correlación sea aún más efectiva.

- Genera informes automáticos, para que no tengas que quemarte las pestañas con Excel en la auditoría.

De esta forma, nos aseguramos de tener siempre en cuenta “el estado de la técnica” y sus avances.

Requisitos de recolección de logs según NIS2

Podemos ser los mejores en seguridad, pero el proverbio siempre tiene razón: No se trata de si ocurrirá un incidente, sino de cuándo ocurrirá.

Los requisitos de actuación y comunicación que establece la NIS2 requieren una recolección, almacenamiento y gestión adecuada de logs, que también necesitaremos para pasar las revisiones a las que estaremos obligados.

Porque sí, el Capítulo VII (Artículo 32) es claro al respecto y debemos ser capaces de pasar esas auditorías y revisiones, incluso en ausencia de incidentes. Eso significa recogida, almacenaje y revisión sencilla de registros, garantizando su integridad y veracidad.

Para una organización crítica, esto implica herramientas profesionales que nos hagan la vida fácil en este sentido.

La tentación de aplicaciones gratuitas es poderosa, pero no alcanzan para las amenazas actuales que sobrevuelan los sectores clave… Ni para asegurar que el auditor no levante la ceja y acaricie el sello de «no apto».

Cómo Pandora FMS y Pandora SIEM ayudan a cumplir con la NIS2

Todo lo que no sean las mejores prácticas de seguridad, apoyadas con herramientas avanzadas, es insuficiente para una organización crítica, nos complica el trabajo y el cumplimiento de la ley.

Por eso, Pandora SIEM permite:

- La monitorización de seguridad avanzada con detección de amenazas en tiempo real.

- Una correlación de eventos de seguridad apoyada por IA, en la punta de lanza de las mejores prácticas y tecnología de seguridad que exige la NIS2.

- La generación de informes que demuestran el cumplimiento normativo en auditorías y controles.

- La recogida, centralización y análisis de logs, con retención prolongada, para una comunicación clara en caso de incidente y una resolución más fácil de este, detectando de un vistazo qué ha pasado, cómo y dónde.

La NIS2 es la respuesta europea a un escenario global más agitado que nunca en ciberseguridad, pero afrontémoslo, las leyes sobre tecnología suelen ir un paso por detrás de esta y, en ocasiones, resultar nebulosas en el ámbito o la interpretación.

Esto causa pesadillas a CISOs y profesionales para el cumplimiento, pero la solución es clara: Adelantarnos a la legislación. Ponernos a la vanguardia de las mejores prácticas y herramientas para que, cuando la normativa de turno descienda con el peso de sus mil folios, estemos un paso más allá y no caiga en nuestras cabezas.

De esta forma, nos aseguraremos de que las líneas de la ley no se unirán a las de código malicioso para complicarnos el día a día.

por Pandora FMS team | Last updated Feb 13, 2025 | ITSM

Con la nueva versión de Pandora ITSM, ahora cuentas con funcionalidades diseñadas para mejorar tu flujo de trabajo y optimizar la administración de tickets y proyectos.

Mejoras clave en Pandora ITSM 105

Nuevo sistema de filtros

Ahora puedes filtrar y visualizar resultados de manera más eficiente en Tickets, Usuarios, Board de Proyectos, Contratos y Facturas. Este sistema se expandirá a más secciones en futuras versiones, permitiendo una mayor flexibilidad en la gestión diaria.

Vista de tickets mejorada

Se ha reorganizado la disposición de los campos en los tickets para mejorar la visibilidad y facilitar su uso. Además, se ha incluido una nueva sección de contratos para agilizar la consulta de información relevante, asegurando una mejor experiencia de usuario.

Diseño personalizable de tickets

Ahora puedes reordenar, agregar o eliminar campos en la vista de tickets según tus necesidades, con una configuración editable en tiempo real a través de los nuevos filtros. Esta flexibilidad permite a cada equipo adaptar Pandora ITSM a su flujo de trabajo específico.

Optimización del timetracker en móvil

La versión móvil del timetracker ha sido rediseñada para ser más intuitiva y funcional. Se han incorporado todas las opciones disponibles en la consola web, asegurando que los usuarios puedan gestionar su tiempo de manera eficiente en cualquier momento y desde cualquier dispositivo.

Soporte para ChatGPT en el chat

Se ha integrado ChatGPT en la funcionalidad de chat de Pandora ITSM, permitiendo obtener respuestas rápidas y precisas a consultas técnicas o de soporte. Esta integración mejora la asistencia al usuario y facilita la resolución de dudas en tiempo real.

Tags en tickets y proyectos

Ahora es posible añadir etiquetas en tickets y proyectos, facilitando la categorización y búsqueda de información relevante. Esta funcionalidad permite un acceso más ágil a los elementos de trabajo y mejora la organización interna.

Nueva vista de gestión de proyectos

Con una interfaz visual similar a Trello, esta nueva vista facilita la gestión de tareas y proyectos con etiquetas, estados personalizados y mayor flexibilidad organizativa. Además, permite mover tareas de manera sencilla entre columnas para un seguimiento más dinámico.

Nuevo workflow para timetracker

Se ha optimizado el flujo de trabajo del timetracker, permitiendo configurar alertas y automatizar recordatorios para mejorar el registro de jornada laboral. Ahora es posible programar notificaciones que avisen sobre el límite de jornada o fichajes olvidados.

Mejoras en gestión y seguridad

Nuevo sistema de licenciamiento

A partir de esta versión, los clientes que actualicen necesitarán solicitar una nueva licencia a través del menú Warp Update > License. Este cambio garantiza una mayor seguridad y control sobre las licencias activas en la plataforma.

Actualización de la base de datos

Para optimizar el rendimiento y compatibilidad, la actualización a Pandora ITSM 105 requiere la migración de MySQL 5 a MySQL 8. Esta actualización asegura mayor estabilidad y rendimiento en la gestión de datos, mejorando el funcionamiento general de la plataforma. Consulta la documentación oficial para más información.

Otras mejoras y correcciones

- Se ha añadido una nueva sección de notificaciones para superadministradores.

- Mejoras en la exportación de datos y personalización de informes.

- Interfaz optimizada en la gestión de unidades de trabajo.

- Actualización en la integración con sistemas de terceros para mayor compatibilidad.

Explora todas las novedades de Pandora ITSM 105 y optimiza la gestión de tu equipo →

Accede a nuestra Wiki oficial o revisa la documentación técnica para conocer más detalles sobre esta versión.

por Sancho Lerena | Last updated Feb 4, 2025 | Pandora FMS

En el mundo de la gestión de infraestructuras y software empresarial, la elección entre soluciones on-premise y SaaS (Software as a Service) se ha convertido en una decisión estratégica para toda organización que influye en áreas clave como la seguridad, la flexibilidad y los costes operativos.

Ambos modelos presentan enfoques diferentes de implementación y uso del software. Mientras que SaaS destaca por su accesibilidad y facilidad de adopción, el modelo on-premise nos ofrece un control absoluto sobre los datos y la infraestructura, siendo especialmente relevante en sectores donde la seguridad y el cumplimiento normativo son prioritarios.

En este artículo analizamos las ventajas y desventajas de cada modelo, abordando casos prácticos y ofreciendo consejos estratégicos para ayudar a las organizaciones a tomar decisiones informadas. Independientemente de tus necesidades, entender estos enfoques te permitirá optimizar tu gestión de infraestructuras de forma efectiva.

¿Qué es el modelo on-premise?

El término on-premise se refiere a un modelo en el que el software se instala y opera en los servidores locales de la organización. En lugar de depender de un proveedor externo para el alojamiento y gestión de la aplicación, la empresa adquiere una licencia perpetua y mantiene un control total sobre su infraestructura y datos. Esto implica que todos los recursos necesarios para operar el sistema—hardware, almacenamiento, red y personal de TI—están bajo el control directo de la organización. Por ejemplo, una empresa del sector financiero puede optar por un modelo on-premise para garantizar que sus datos sensibles permanezcan completamente bajo su dominio y cumplan con estrictas normativas locales.

En el ámbito del software de gestión de infraestructuras, este modelo es común en herramientas como:

- ITIM (IT Infrastructure Management): Supervisión y optimización de infraestructuras críticas, como servidores y redes.

- ITOM (IT Operations Management): Automatización y gestión de tareas operativas en entornos TI complejos.

- SIEM (Security Information and Event Management): Permite la monitorización y análisis de seguridad.

- ITSM (IT Service Management): Gestión de servicios TI.

- CMDB (Configuration Management Database): Documenta los activos y sus relaciones con los servicios.

El modelo on-premise proporciona una experiencia personalizada y controlada, lo que muchas empresas consideran imprescindible, especialmente en sectores donde la seguridad y el cumplimiento normativo son fundamentales.

¿Qué es el modelo SaaS?

El modelo SaaS (Software as a Service) se basa en aplicaciones alojadas en la nube y ofrecidas como un servicio por proveedores externos. Este enfoque es especialmente beneficioso para empresas con equipos distribuidos o que necesitan escalar rápidamente, ya que permite acceder a las herramientas desde cualquier lugar con conexión a internet y ajustar la capacidad según las necesidades en tiempo real.

En lugar de instalar el software localmente, las empresas acceden a él a través de Internet mediante una suscripción mensual o anual. Este modelo es común en herramientas como:

- RMM (Remote Monitoring and Management): Gestión remota de dispositivos.

- APM (Application Performance Management): Optimización del rendimiento de las aplicaciones.

- ESM (Enterprise Service Management): Amplía las capacidades de ITSM a toda la organización.

El SaaS ha ganado popularidad debido a ventajas como:

- Facilidad de implementación: Permite comenzar a utilizar las herramientas casi de inmediato, eliminando la necesidad de complejas configuraciones iniciales.

- Costes iniciales reducidos: Ofrece una inversión inicial baja en comparación con las soluciones on-premise, con tarifas recurrentes que pueden ser previsibles.