Мониторинг виртуальных сред

Мониторинг виртуальных сред

Виртуальные среды занимают важное место в ИТ-архитектурах всех компаний, поэтому их мониторинг крайне важен. С помощью Pandora FMS Enterprise вы сможете получить доступ к Amazon EC2, VMware, RHEV, Nutanix, XenServer, OpenNebula, IBM HMC, HPVM.

Amazon EC2

Для мониторинга EC2 в корпоративных средах, пожалуйста, перейдите на Discovery

Это руководство соответствует компоненту OpenSource для мониторинга EC2.

Этот специфический мониторинг использует CloudWatch API для мониторинга ваших экземпляров на службе Amazon EC2. На вашем экземпляре должна быть включена функция Cloudwatch. Вы можете получить бесплатный плагин в разделе библиотека модулей.

Основная цель этого удаленного плагина сервера заключается в получении информации от ваших экземпляров с помощью плагина сервера Pandora FMS. Это означает, что вам нужно будет зарегистрировать плагин на сервере и настроить различные модули для получения информации с ваших серверов EC2.

Пример выполнения с использованием коннектора \>

/home/slerena/ec2_plugin.sh \

-A AKIAILTVCAS26GTKLD4A \

-S CgmQ6DxUWES05txju alJLoM57acDudHogkLotWk \

-i i_9d0b4af1 \

-n AWS/EC2 \

-m CPUUtilization

Возвращает числовое значение (процент) метрики CPUUtilization в экземпляре i_9d0b4af1.

Для установки вам понадобятся:

1. На вашем сервере Pandora FMS должна быть доступна JAVA с соответствующим каталогом JAVAHOME.

2. Скопировать этот плагин на путь и установить разрешения в 755, настроить базовый путь в переменной AWS_CLOUDWATCH_HOME, которая присутствует в первых строках плагина. Вы должны отредактировать первые несколько строк плагина .

Plugin состоит из нескольких файлов:

/ec2_plugin.sh - Это сам плагин. /bin/* - Компоненты Amazon CloudWatch (Monitoring) Command Line Tools, включенные в этот пакет. Эти скрипты распространяются по лицензии Apache.

Поместите весь пакет в каталог, доступный серверу, например:

/usr/share/pandora_server/plugin/ec2

И установите AWS_CLOUDWATCH_HOME в /usr/share/pandora_server/plugin/ec2.

Чтобы подтвердить установку, выполните:

/usr/share/pandora_server/plugin/ec2/mon-cmd --version

В результате должно вернуться что-то похожее на:

Amazon CloudWatch CLI version 1.0.9.5 (API 2010-08-01)

Если вы получите ту же строку, значит, все готово к использованию плагина.

Если нет, вам, вероятно, потребуется установить и правильно настроить инструменты командной строки Amazon CloudWatch (мониторинг).

Установка

Требования:

- Убедитесь, что в вашей системе установлена Java версии 1.5 или выше, для этого выполните:

java -version

- Распакуйте файл

.zipразвертывания . - Установите следующие переменные среды:

AWS_CLOUDWATCH_HOME- Каталог, в который были скопированы файлы развертывания для их проверки с помощью:

Unix: ls ${AWS_CLOUDWATCH_HOME}/bin (should list mon-list-metrics ...)

Windows: dir %AWS_CLOUDWATCH_HOME%\bin (should list mon-list-metrics ...)

JAVA_HOME- Каталог Home установки Java.- Добавьте к пути по умолчанию (path) следующее:

${AWS_CLOUDWATCH_HOME}/bin

- В Windows:

%AWS_CLOUDWATCH_HOME%\bin

Конфигурация

Установите учетные данные пользователя AWS в инструменте командной строки. Существует два способа предоставления учетных данных:

- Пароли AWS.

- Использование сертификатов X.509.

Использование паролей AWS

Вы можете явно указать учетные данные в командной строке:

- -I ACCESS_KEY –S SECRET_KEY

Вы также можете создать файл учетных данных. Развертывание включает файл шаблона:

${AWS_CLOUDWATCH_HOME}/credential-file-path.template.

Вы должны отредактировать копию этого файла, чтобы добавить свою информацию. В UNIX это также происходит путем ограничения разрешений для владельца файла учетных данных ( credential-file ):

$ chmod 600 <credential-file>.

Когда файл будет создан, обратитесь к нему следующим образом:

- Установите следующую переменную среды:

export AWS_CREDENTIAL_FILE=<credential-file>

- Вы также можете указать следующую опцию для каждой команды:

- -aws-credential-file <credential-file>

Использование сертификатов X.509

Сохраните личный сертификат и пароль в файлах: my_cert.pem и my-pk.pem.

Существует два способа предоставления сертифицированной информации в командную строку:

- Установите следующие переменные среды:

EC2_CERT=/path/to/cert/file EC2_PRIVATE_KEY=/path/to/key/file

- Укажите файлы непосредственно в командной строке для всех команд:

<command> \

--ec2-cert-file-path=/path/to/cert/file \

--ec2-private-key-file-path=/path/to/key/file

Установка свойств JVM

Установив переменную среды SERVICE_JVM_ARGS, вы можете произвольно передавать свойства JVM в командную строку.

Например, следующая строка устанавливает свойства в Linux/UNIX

export SERVICE_JVM_ARGS="-Dhttp.proxyHost=http://my.proxy.com -Dhttp.proxyPort=8080"

Ввод в эксплуатацию

Убедитесь, что ваша установка работает правильно, выполнив следующую команду:

$ mon-cmd --help

Вы должны увидеть страницу использования для всех команд мониторинга.

$ mon-list-metrics --headers

Вы также должны увидеть строку заголовка. Если у вас есть еще какие-либо определенные метрики, они также должны появиться.

VMware

С Pandora FMS Enterprise вы можете получить доступ к VMware Monitoring Plugin, плагину, который позволяет вам контролировать виртуальную архитектуру VMware простым способом.

Архитектура VMware для мониторинга

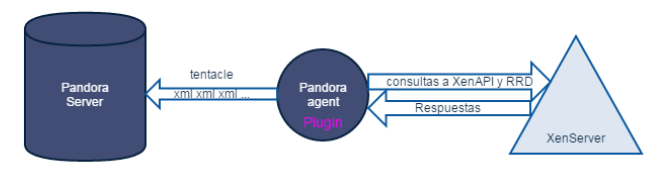

С помощью этой системы можно контролировать архитектуры, подобные той, что показана на следующей схеме:

Pandora FMS может контролировать VCenter, серверы ESXi и компоненты виртуализации: Datastores и виртуальных машин. Pandora FMS полагается на API, который предоставляет SDK от VMware® для Perl для сбора данных.

Мониторинг с Discovery Application VMware

Выполните действия, описанные в разделе Discovery для мониторинга инфраструктуры VMware®.

Требования для плагина VMware

Требования для осуществления задачи мониторинга VMware® следующие:

- Pandora FMS v7.0NG.732 или выше.

- VMware vSphere® SDK для языка Perl.

Конфигурация vCenter для мониторинга

Discovery Applications VMware использует метрики, предоставляемые API vCenter® и ESXi VMware®. Доступность этих метрик зависит от уровней, настроенных для сбора статистики.

Эти уровни можно изменить в меню vCenter Server Settings и в опции Statistics. Для каждого варианта времени и каждого уровня вы получите описание счетчиков, которые собирает vCenter. Минимальный уровень для мониторинга с помощью плагина Pandora FMS - Уровень 2.

В зависимости от конфигурации vCenter, возможно, что некоторые модули не будут сообщать данные в Pandora FMS.. Это может быть связано с тем, что:

- Отсутствует установка какого-нибудь плагина в vCenter.

- Необходимо установить Агент VMware® (vmware-tools) в структуру.

- Просто потому, что структура выключена (виртуальная машина или ESXi).

Для устранения этих проблем следует обратиться к документации VMware..

Некоторые решения, такие как мониторинг состояния оборудования (Hardware Status), могут потребовать расширенной настройки как vCenter, так и хостов, поддерживающих ESX.

Развертывание системы мониторинга VMware

Начиная с версии 732 Pandora FMS, мониторинг VMware осуществляется с помощью системы Discovery Applications (дополнительная информация в разделе Discovery VMware).

Если по какой-то причине вы хотите вручную настроить плагин вне этой функции, вы можете использовать классический режим, описанный ниже.

Если вам необходимо развернуть или обновить вашу версию плагина VMware до более новой, выполните действия, описанные в следующих пунктах:

Ручное развертывание плагинов

1.- Перейдите в каталог, в который были извлечены файлы плагина VMWare®.

2.- Скопируйте vmware-plugin.{pl,conf} в соответствующий каталог.

sudo cp vmware-plugin.pl vmware-plugin.conf /usr/share/pandora_server/util/plugin/

sudo chown pandora:apache /usr/share/pandora_server/util/plugin/vmware-plugin.{pl,conf}

sudo chmod g w /usr/share/pandora_server/util/plugin/vmware-plugin.conf

3.- Проверьте данные, необходимые для настройки плагина.

В меню "Конфигурация" консоли Pandora FMS назначьте пароль для API, а также разрешенные источники.

4.- Отредактируйте файл конфигурации vmware-plugin.conf.

5.- Проверьте доступность VMware® SDK для Perl.

Для проверки установки VMware® SDK Perl можно запустить скрипт со следующим содержанием:

#!/usr/bin/perl use strict; use warnings; use VMware::VIRuntime; print "VMware SDK Version: " . $VMware::VIRuntime::VERSION . "\n";

Выполните скрипт:

perl check_vmware.pl

Вывод должен быть похож на следующий:

VMware SDK Version: 6.5.0

Убедитесь, что версия SDK выше или равна версии ваших продуктов VMware®.

Начиная с версии 717 плагина для VMware® вам также необходимо установить библиотеку Perl PluginTools.pm, (доступна вместе с сервером в /usr/lib/perl5/PandoraFMS) на устройстве, где вы хотите его развернуть (скопируйте в /usr/lib/perl5/PandoraFMS на устройстве, на котором будет запущен плагин).

Установка VMware vSphere SDK для Perl

URL-адрес центра загрузки необходимого программного обеспечения VMware®:

https://my.vmware.com/web/vmware/details?downloadGroup=VS-PERL-SDK65&productId=614

Установка SDK для Linux

Версии SDK, протестированные с помощью этого процесса установки, были 4.1, 5.1, 6.0 и 6.5

Всегда рекомендуется использовать версию SDK с соответствующей ей версией программного обеспечения. VMware®. Например, рекомендуется использовать программное обеспечение 4.1 VMware® с версией SDK 4.1.

Сначала распакуйте SDK с помощью следующей команды:

# tar -xzvf VMware-vSphere-Perl-SDK-x.x.x-xxxxxx.i386.tar.gz

Теперь скомпилируйте и установите SDK с помощью следующих команд:

# perl Makefile.PL # make # make install

Если установка прошла успешно и ошибок не возникло, вы можете подключиться к vCenter® с помощью следующей команды, используя такой коннектор строк :

# /usr/lib/vmware-viperl/apps/general/connect.pl \

--server <vcenter_ip> \

--username <vcenter_user> \

--password <vcenter_pass>

Ответ должен быть похож на приведенный ниже:

Connection Successful Server Time : 2013-02-21T16:24:05.213672Z

Обновление SDK до версии 6.5 с других версий

Если вы выполняете обновление VMware SDK, выполните следующие действия:

- Установите инструменты для разработчиков:

yum groupinstall "Developer Tools"

- Установите CPAN:

yum install perl-CPAN

- Установите некоторые зависимости:

yum install openssl-devel perl-Class-MethodMaker yum install epel-release

- Распакуйте установочные файлы VMware® SDK Perl:

tar xvzf VMware-vSphere-Perl-SDK-6.5.0-4566394.x86_64.tar.gz

- Получите доступ к каталогу:

cd vmware-vsphere-cli-distrib

- Запустите программу установки:

./vmware-install.pl

Для CentOS 8 вам также следует выполнить следующие шаги:

# Enable epel repo: yum install epel-release # Enable powertools: yum install dnf-utils yum config-manager --set-enabled PowerTools # Note: For centos 8 install custom made RPMs from Artica repo: `yum install http://firefly.artica.es/centos8/perl-Crypt-SSLeay-0.73_07-1.gf.el8.x86_64.rpm` before install SDK # Install the vmware SDK -- Custom RPM 6.5: `yum install http://firefly.artica.es/centos8/VMware-vSphere-Perl-SDK-6.5.0-4566394.x86_64.rpm`

Во время установки:

- Согласитесь с условиями лицензии.

- Укажите не использовать предварительно созданные модули для VMware® SDK.

- Согласитесь с автоматической установкой модулей через автоматизированную систему CPAN.

- Убедитесь, что все требования были установлены правильно.

- Укажите каталог, в котором нужно будет установить модули VMware® SDK Perl

Nota: Иногда пакет Perl UUID может выдавать ошибки при установке на CentOS 7. Выполните следующие действия, чтобы добавить компонент:

- Установите необходимые зависимости для UUID-0.03:

yum install libuuid-devel perl-JSON-PP

- Загрузите пакет с кодом:

wget https://cpan.metacpan.org/authors/id/C/CF/CFABER/UUID-0.03.tar.gz

- Распакуйте файл и откройте каталог:

tar xvzf UUID-0.03.tar.gz cd UUID-0.03

- Сгенерируйте файлы, необходимые для компиляции модуля Perl:

perl Makefile.PL

- Скомпилируйте модуль Perl:

make

- Вы должны получить ответ, аналогичный следующему:

Manifying blib/man3/UUID.3pm

- Установите новый скомпилированный модуль:

make install

После установки ожидающих модулей снова запустите процесс установки VMware® SDK Perl:

./vmware-install.pl

Примечание: деинсталлятор VMware® не полностью удаляет предыдущие библиотеки модулей VMware.

Убедитесь, что библиотеки установлены правильно в /usr/lib/vmware-vcli/VMware/share/ прежде чем продолжить

Вы должны выполнить следующие действия вручную:

- Очистить старые библиотеки.

rm -rf /usr/share/perl5/vendor_perl/VMware rm -rf /usr/share/perl5/VMware

- Добавить новые библиотеки VMware®

cp -R /usr/lib/vmware-vcli/VMware/share/VMware /usr/share/perl5/vendor_perl/

После этого можно запустить скрипт со следующим содержанием для проверки установки VMware® SDK Perl.

#!/usr/bin/perl use strict; use warnings; use VMware::VIRuntime; print "VMware SDK Version: " . $VMware::VIRuntime::VERSION . "\n";

Выполните этот script:

perl check_vmware.pl

Вывод должен быть следующим:

VMware SDK Version: 6.5.0

Если выход отличается, проверьте, правильно ли вы выполнили все шаги, или обратитесь в службу поддержки по адресу https://support.pandorafms.com/integria/

Зависимости SDK для CentOS 7 и CentOS 8 следующие:

gdbm-devel glibc-devel glibc-headers kernel-headers libdb-devel libuuid-devel make openssl perl-Business-ISBN perl-Business-ISBN-Data perl-Class-Inspector perl-Class-MethodMaker perl-Convert-BinHex perl-Crypt-SSLeay perl-Digest perl-Digest-MD5 perl-Email-Date-Format perl-Encode-Locale perl-ExtUtils-Install perl-ExtUtils-MakeMaker perl-ExtUtils-Manifest perl-ExtUtils-ParseXS perl-File-Listing perl-HTML-Parser perl-HTML-Tagset perl-HTTP-Cookies perl-HTTP-Daemon perl-HTTP-Date perl-HTTP-Message perl-HTTP-Negotiate perl-IO-HTML perl-IO-SessionData perl-IO-Socket-IP perl-IO-Socket-SSL perl-JSON-PP perl-LWP-MediaTypes perl-LWP-Protocol-https perl-MIME-Lite perl-MIME-Types perl-MIME-tools perl-MailTools perl-Mozilla-CA perl-Net-HTTP perl-Net-LibIDN perl-Net-SMTP-SSL perl-Net-SSLeay perl-SOAP-Lite perl-Test-Harness perl-TimeDate perl-URI perl-WWW-RobotRules perl-XML-LibXML perl-XML-NamespaceSupport perl-XML-Parser perl-XML-SAX perl-XML-SAX-Base perl-devel perl-libwww-perl pyparsing systemtap-sdt-devel glibc glibc-common libblkid libmount libsmartcols libuuid util-linux

Для CentOS 8 установите RPMs perl-Crypt-SSLeay из репозитория Artica:

yum install `http://firefly.artica.es/centos8/perl-Crypt-SSLeay-0.73_07-1.gf.el8.x86_64.rpm`

Вы можете установить дополнительные зависимости плагина с помощью следующей команды:

`yum install perl-Archive-Zip perl-JSON`

Вы можете установить зависимости шифрования пароля с помощью следующей команды:

`yum install openssl-devel perl-Crypt-CBC perl-Digest-SHA`

Вы можете загрузить пользовательские RMP perl-Crypt-OpenSSL-AES из репозитория Artica:

- Для CentOS 7.

`yum install https://sourceforge.net/projects/pandora/files/Tools and dependencies (All versions)/RPM CentOS, RHEL/perl-Crypt-OpenSSL-AES-0.02-1.el7.x86_64.rpm`

- Для CentOS 8.

`yum install https://sourceforge.net/projects/pandora/files/Tools and dependencies (All versions)/RPM CentOS, RHEL/perl-Crypt-OpenSSL-AES-0.02-1.el8.x86_64.rpm`

Установка SDK на Windows

Версия PERL, распространяемая вместе с vSphere® SDK, не работает с библиотеками VMware® для PERL. Чтобы решить эту проблему, выполните следующие действия:

- Установите VMware vSphere® SDK.

- Установите Strawberry PERL версии 5.12 из http://strawberryperl.com/releases.html.

- Скопируйте каталог:

%ProgramFiles%\VMware\VMware vSphere CLI\Perl\lib\VMware

a

C:\strawberry\perl\lib

- Удалите VMware vSphere® SDK.

Конфигурация плагина VMware

Вы можете настроить VMware плагин вручную или с помощью расширения консоли, доступного вместе с загружаемыми файлами плагина VMware®.

Настройка плагина вручную

Для управления несколькими конфигурациями плагина de VMware® рекомендуется использовать расширение, доступное в консоли Pandora FMS.

Вы можете вручную отредактировать файл конфигурации; помните, что строки, начинающиеся с #, будут интерпретироваться как комментарии.

Конфигурационный файл плагина мониторинга среды VMware содержит следующие общие элементы:

server

FQDN или IP сервера VMware® для мониторинга.

user

Пользователь с правами в vCenter®.

pass

Пароль пользователя.

datacenter

Имя центра данных (по умолчанию: ha-datacenter).

temporal

Временный рабочий каталог, по умолчанию: /tmp

logfile

Файл журнала, по умолчанию /tmp/vmware_plugin.log

entities_list

Файл объектов для мониторинга, по умолчанию /tmp/vmware_entitites_list.txt

transfer_mode

Режим передачи XML в Pandora, по умолчанию локальный.

tentacle_ip

Адрес сервера Pandora FMS, по умолчанию 127.0.0.1

tentacle_port

Порт для связи с Tentacle, по умолчанию 41121.

tentacle_opts

Дополнительные опции для удаленного Tentacle

local_folder

При локальной передаче папка назначения для XML-файлов отчета /var/spool/pandora/data_in

pandora_url

Веб-адрес консоли Pandora FMS, по умолчанию http://127.0.0.1/pandora_console .

api_pass

Пароль API консоли Pandora FMS.

api_user

Пользователь с доступом к API Pandora FMS.

api_user_pass

Пароль пользователя с доступом к API.

retry_send

Повторить( 1 ) или нет ( 0 ) отправку XML в случае ошибки (аналогичный buffer_xml).

event_mode

Восстановить информацию ( 1 ) событий VMware или нет ( 0 ).

event_pointer_file

Вспомогательный индексный файл для событий VMware, по умолчанию /tmp/vmware_events_pointer.txt

Virtual network monitoring

Включить мониторинг виртуальных коммутаторов.

Encrypt passwords

Используйте зашифрованные пароли в файле конфигурации.

verbosity

Уровень отладки (рекомендуется 1 ).

threads

Максимальное количество используемых потоков (рекомендуется 4 ).

interval

Интервал в секундах генерируемых агентов и модулей (настраивается в зависимости от частоты выполнения плагина).

Recon Interval

Интервал в секундах, после которого временный файл кэша объектов автоматически удаляется для повторного сканирования инфраструктуры VMware®.

group

Серверы Целевая группа агентов, создаваемых плагином..

virtual_network_monitoring

Включает ( 1 ) или выключает ( 0 ) мониторинг виртуальных коммутаторов (стандарт).

use_ds_alias_as_name

Включает ( 1 ) или выключает ( 0 ) использование алиас в качестве имени Агента в агентах хранения данных.

Сервер, центр данных, пользователь, пароль и интервал можно настроить через консоль Pandora.

Если вы используете Pandora FMS 5.0 или более позднюю версию и хотите использовать расширения плагина или применить мониторинг событий, вам необходимо правильно настроить Pandora FMS API. Для этого вы должны добавить пароль API и предоставить доступ к соответствующим адресам в списке доступа API. Эти поля определены в общей конфигурации Консоли Pandora FMS.

Пользователь, которого вы используете вместе с паролем API, должен иметь права на чтение и запись для записи событий. Также не забудьте включить агентов Datacenter в план мониторинга, поскольку события для консоли происходят от этих агентов.

Раздел «Reject» плагина мониторинга среды VMware® содержит следующий параметр:

- all_ipaddresses

Если эта инструкция присутствует, IP-адрес в XML не будет обновляться. Эта инструкция действительна и для заданий.

Настройка мониторинга VMware

Выполните действия, описанные в VMware Discovery для настройки мониторинга инфраструктуры VMware с помощью Discovery.

Выполнение плагина VMware

Для проверки работы вашей конфигурации вы можете выполнить:

perl \

/usr/share/pandora_server/util/plugin/vmware-plugin.pl \

/usr/share/pandora_server/util/plugin/vmware-plugin.conf

Примечание:

- Для VMware SDK 6.5.0, если во время выполнения плагина вы получили следующий вывод:

Server version unavailable at 'https://your_vmwre_fqdn:443/sdk/vimService.wsdl' at /usr/local/lib64/perl5/VMware/VICommon.pm line 734.

Рекомендуемое решение - настроить версии библиотек Perl LWP:

cpan install GAAS/libwww-perl-5.837.tar.gz

Настоятельно рекомендуется использовать Discovery Applications VMware для мониторинга вашей инфраструктуры.

Планирование выполнения из Агента Pandora FMS

Для использования Агента Pandora FMS необходимо скопировать vmware-plugin.{pl,conf} в место, доступное для Агента Pandora FMS:

sudo cp \

/usr/share/pandora_server/util/plugin/vmware-plugin.{pl,conf} \

/etc/pandora/plugins/

Чтобы создать файл конфигурации

vmware-plugin-events.conf

скопируйте vmware-plugin.conf и измените вручную event_mode a 1.

Теперь вы должны добавить новый модуль типа plugin в конфигурационный файл агента следующей строкой:

module_plugin perl \

/etc/pandora/plugins/vmware-plugin.pl \

/etc/pandora/plugins/vmware-plugin.conf

Если вы также хотите сделать копию событий, вы должны создать другой Модуль плагин с другим конфигурационным файлом, который позволит копировать события. Синтаксис выглядит следующим образом:

module_plugin perl \

/etc/pandora/plugins/vmware-plugin.pl \

/etc/pandora/plugins/vmware-plugin-events.conf

В системах Windows® необходимо указать используемый интерпретатор:

module_plugin perl "%ProgramFiles%\pandora_agent\util\vmware-plugin.pl" "%ProgramFiles%\pandora_agent\util\vmware-plugin.conf"

В следующих разделах подробно описаны параметры конфигурационного файла плагина.

Запуск плагина VMware может занять много времени из-за большого количества зарегистрированных объектов.

Мы рекомендуем проводить мониторинг через Discovery, чтобы DiscoveryServer сам позаботился об этих задачах.

Если вы решите проводить мониторинг другим способом, может потребоваться распределить нагрузку между несколькими программными агентами Pandora FMS или выбрать другой режим программирования. Всю информацию об этом можно найти в следующих разделах

Планирование выполнения из cron системы

Вы можете запланировать выполнение плагина из самого cron системы. Помните, что интервальное значение созданных элементов ( interval в конфигурации) и периодичность выполнения должны быть согласованы:

# Input to add to crontab, set a range of 600 to use this setting/10 * * * * root perl /usr/share/pandora_server/util/plugin/vmware-plugin.pl /usr/share/pandora_server/util/plugin/vmware-plugin.conf

В приведенном выше примере показана строка, которую нужно добавить в crontab. Установите интервал 600 для использования этой конфигурации

Мониторинг виртуальной архитектуры VMware

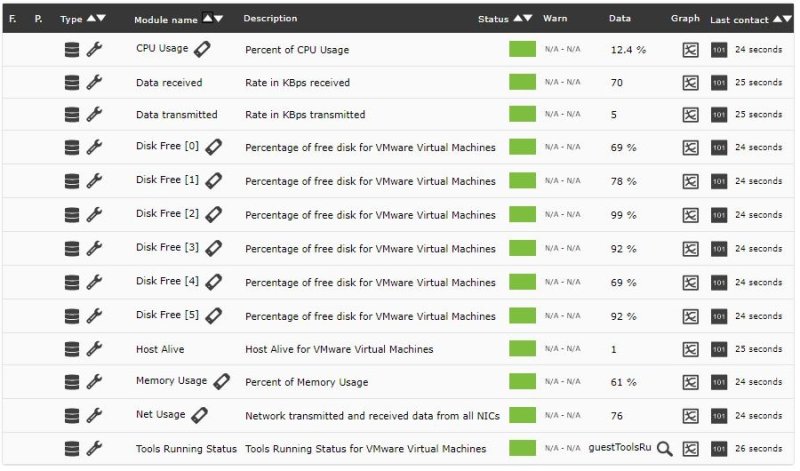

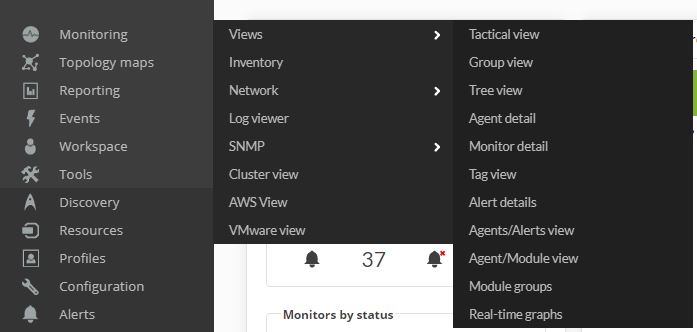

Чтобы увидеть результат выполнения плагина, откройте подменю Agent Detail в меню Views.

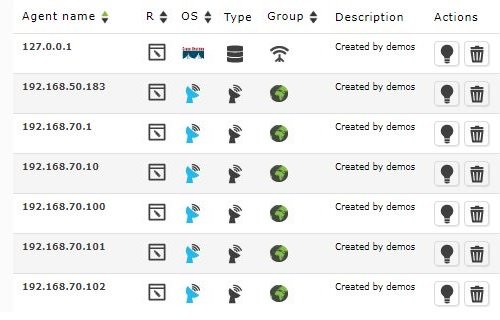

В этом виде появятся Агенты, созданные плагином, вместе с другими Агентами Pandora FMS.

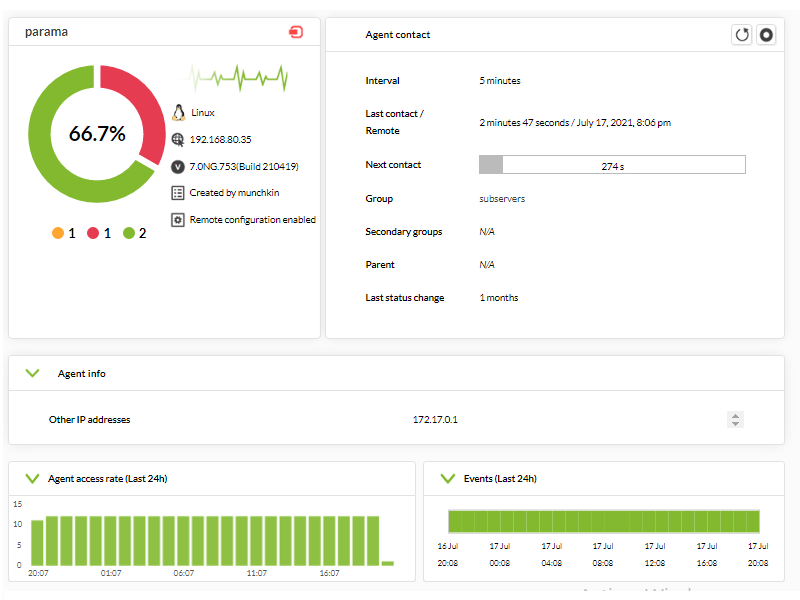

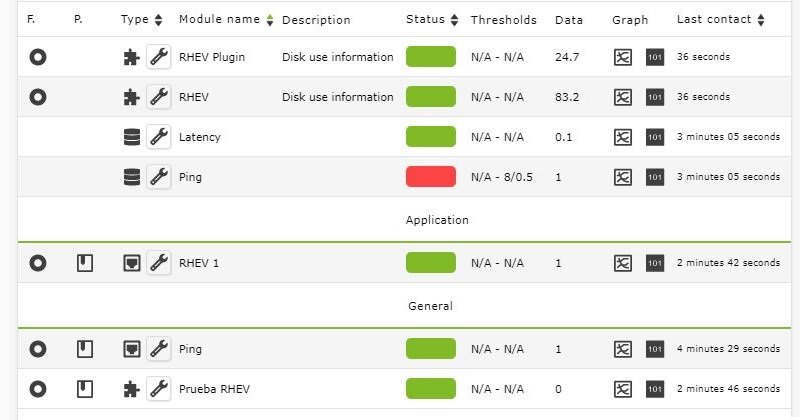

Если вы щелкните на имени агента, вы откроете просмотр агента Pandora FMS, где будут отображаться модули, контролируемые плагином VMware.

По умолчанию плагин развертывает базовый мониторинг для каждого из элементов VMware®.

Мониторинг центра данных по умолчанию

- Ping

- Check 443 port

Мониторинг центра данных по умолчанию

- Capacity

- Free Space

- Disk Overallocation

- Free Space Bytes

Мониторинг ESXi по умолчанию

- CPU Usage

- Memory Usage

- Data received

- Data transmitted

- Disk Read Latency

- Disk Write Latency

- Host Alive

- Disk Rate

- Net Usage

Мониторинг по умолчанию для виртуальных машин

- CPU Usage

- Memory Usage

- Tools Running Status

- Host Alive

- Disk Free

- Disk Read Latency

- Disk Write Latency

- Data received

- Data transmitted

- Net Usage

В следующем разделе подробно описаны все доступные модули и информация, сообщаемая каждым из них.

Модули агентов виртуальной архитектуры VMware

Некоторые модули могут быть недоступны в зависимости от версии VMware и от конфигурации среды. В следующих таблицах описаны различные доступные модули характеристики их доступности.

Плагин позволяет настраивать пользовательские Performance Counters для хостов ESX и виртуальных машин. Вы можете посмотреть, как это делается, в разделе, который подробно описывает содержимое конфигурационного файла.

Модули для агентов типа Datacenter

| Модуль | Описание | Версия API | Доступность |

|---|---|---|---|

| Ping | Проверка Ping на устройстве с поддержкой vCenter | Все | Всегда |

| Check 443 port | Проверка порта 443 устройства, которое поддерживает vCenter | Все | Всегда |

Модули для агентов типа Datastore

| Модуль | Описание | Версия API | Доступность |

|---|---|---|---|

| Capacity | Максимальная емкость хранилища данных Datastore в байтах | Все | Всегда |

| Free Space | Процент свободного пространства в Datastore | Все | Всегда |

| Disk Overallocation | Процент избыточного распределения дисков | ≥v4.0 | Всегда |

| Free Space Bytes | Объем свободного пространства в байтах | Все | Всегда |

Модули для агентов типа host ESXi

| Модуль | Описание | Версия API | Доступность |

|---|---|---|---|

| Boot Time | Последняя дата включения хоста | Все | Всегда |

| CPU Info [x] | Общая информация о процессоре (один модуль создается для каждого процессора ESXi) | Все | Если подключено |

| Memory Size | Общий объем физической памяти хоста в байтах | Все | Если подключено |

| Overall CPU Usage | Сумма использования всех процессоров в МГц | Все | Если подключено |

| Overall Memory Usage | Общее использование памяти хостами VMware | Все | Если подключено |

| Power State | Состояние питания хоста | ≥v2.5 | Всегда |

| SSL Thumbprint | Отпечаток SSL хоста | ≥v4.0 | Если настроено |

| Uptime | Время работы хоста в секундах | ≥v4.1 | Если подключено |

| VNIC Info [x] | Информация о виртуальных сетевых интерфейсах хоста | Все | Если подключено и настроено |

| Host Alive | Модуль равен 1, если ESX подключен, и равен 0 в противном случае. | Все | Всегда |

| Connection State | Состояние соединения с хостом | Все | Всегда |

| Disk Read | Скорость чтения с диска в Кбит/с | Все | Уровень статистики ≥2 |

| Disk Write | Скорость записи на диск Кбит/с | Все | Уровень статистики ≥2 |

| Disk Read Latency | Задержка чтения с диска в миллисекундах | Все | Уровень статистики ≥2 |

| Disk Write Latency | Задержка записи на диск в миллисекундах | Все | Уровень статистики ≥2 |

| Data received | Скорость Кбит/с, полученная от хоста | Все | Уровень статистики ≥2 |

| Data transmitted | Скорость Кбит/с, отправляемая с хоста | Все | Уровень статистики ≥2 |

| Packages Received | Количество пакетов, полученных в интервале | Все | Уровень статистики ≥2 |

| Packages Transmitted | Количество пакетов, отправленных в интервале | Все | Уровень статистики ≥2 |

| CPU Usage | Процент использования процессора | Все | Уровень статистики ≥2 |

| Memory Usage | Процент использования оперативной памяти | Все | Уровень статистики ≥2 |

| Net Usage | Сетевые данные, полученные и отправленные со всех NIC | Все | Уровень статистики ≥2 |

| Disk Rate | Скорость ввода/вывода в КБ/сек | Все | Уровень статистики ≥2 |

| Max. Disk Latency | Максимальная задержка всех дисков | Все | Уровень статистики ≥2 |

| HA Status | Статус хоста HA | ≥v5.0 | Если настроено |

| Sensor* | Состояние аппаратных датчиков (один модуль на датчик) | Все | ESXi >= 3.5 |

Модули для Агентов типа виртуальной машины

Эти модули предлагают информацию с точки зрения архитектуры VMware®. Если вы хотите отслеживать другие параметры, связанные с виртуальной машиной, вам следует рассмотреть другие варианты, такие как Мониторинг с программными Агентами или Удаленный мониторинг

| Модуль | Описание | Версия API | Доступность |

|---|---|---|---|

| Boot Time | Последняя дата включения виртуальной машины | Все | Если подключено |

| Connection State | Состояние соединения | Все | Всегда |

| Consumed Overhead Memory | Объем памяти, потребляемой виртуальной машиной в МБ | ≥v4.0 | Если настроено |

| CPU Allocation | Информация о ресурсах, выделенных центральному процессору виртуальной машины | Все | Если настроено |

| Disk Free [x] | Процент свободного дискового пространства на виртуальной машине. (Для каждого диска, на котором находится виртуальная машина, будет один модуль.) | Все | Если настроено |

| Guest State | Режим работы операционной системы guest | Все | Если настроено |

| Host Info | Информация о хосте VMware | Все | Если настроено |

| Host Alive | Модуль, который равен 1, если виртуальная машина запущена, и 0 в противном случае. | Все | Всегда |

| Host Memory Usage | Память, потребляемая виртуальной машиной в МБ | Все | Если подключено |

| Host Name | Связанное имя хоста | Все | Если настроено |

| IP Address [x] | IP-адрес машины. (Будет отображаться по одному доступному сетевому интерфейсу.) | ≥v4.1 | Если настроено |

| MAC Address [x] | MAC-адрес машины. (Будет отображаться по одному доступному сетевому интерфейсу.) | Все | Если настроено |

| Max CPU Usage | Верхний предел использования ЦП виртуальной машины | Все | Если подключено |

| Max Memory Usage | Верхний предел использования оперативной памяти виртуальной машины | Все | Если подключено |

| Memory Allocation | Предел ресурсов памяти | Все | Если настроено |

| Memory Overhead | Объем памяти, используемой виртуальной машиной сверх требований операционной системы guest, в байтах. | Все | Если настроено |

| Overall CPU Demand | Основные статистические данные о производительности процессора в МГц | ≥v4.0 | Если подключено |

| Overall CPU Usage | Основная статистика использования процессора в МГц | Все | Если подключено |

| Power State | Текущее состояние виртуальной машины | Все | Всегда |

| Private Memory | Объем памяти в МБ, предоставленный виртуальной машине из собственной памяти | ≥v4.0 | Если подключено |

| Shared Memory | Объем памяти в МБ, предоставляемый виртуальной машине в общей памяти | ≥v4.0 | Если подключено |

| Tools Running Status | Текущее состояние запущенных инструментов VMware Tools, установленных в операционной системе guest | ≥v4.0 | Если настроено |

| Trigger Alarm State | Состояние сигналов предупреждения VMware | Все | Если настроено |

| Uptime Seconds | Время работы виртуальной машины в секундах | ≥v4.1 | Если подключено |

| Virtual Image Path | Путь к файлу конфигурации виртуальной машины (.vmx) | Все | Всегда |

| Disk Read | Скорость чтения с диска в Кбит/с | Все | Уровень статистики ≥2 |

| Disk Write | Скорость записи на диск Кбит/с | Все | Уровень статистики ≥2 |

| Disk Read Latency | Задержка чтения с диска в миллисекундах | Все | Уровень статистики ≥2 |

| Disk Write Latency | Задержка записи на диск в миллисекундах | Все | Уровень статистики ≥2 |

| Data received | Скорость Кбит/с, полученная от хоста | Все | Уровень статистики ≥2 |

| Data transmitted | Скорость Кбит/с, отправляемая с хоста | Все | Уровень статистики ≥2 |

| Packages Received | Количество пакетов, полученных в интервале | Все | Уровень статистики ≥2 |

| Packages Transmitted | Количество пакетов, отправленных в интервале | Все | Уровень статистики ≥2 |

| CPU Usage | Процент использования процессора | Все | Уровень статистики ≥2 |

| Memory Usage | Процент использования оперативной памяти | Все | Уровень статистики ≥2 |

| Net Usage | Сетевые данные, полученные и отправленные со всех NIC | Все | Уровень статистики ≥2 |

| Disk Rate | Скорость ввода/вывода в КБ/сек | Все | Уровень статистики ≥2 |

| Max. Disk Latency | Максимальная задержка всех дисков | Все | Уровень статистики ≥2 |

| HeartBeat | Количество Heartbeat-сообщений виртуальной машины | Все | Уровень статистики ≥2 |

| CPU Ready | Процент времени, в течение которого машина находится в списке, но не поставлена в очередь на выполнение на физическом процессоре | Все | Уровень статистики ≥2 |

| Number Snapshots | Количество снапшотов для виртуальной машины (этот модуль может влиять на производительность мониторинга, поэтому рекомендуется запускать его с большим значением интервала, например, каждый час). | Все | Если настроено |

| HA Status | Статус HA для виртуальной машины | ≥v5.0 | Если настроено |

Некоторые модули требуют установки VMware tools®.

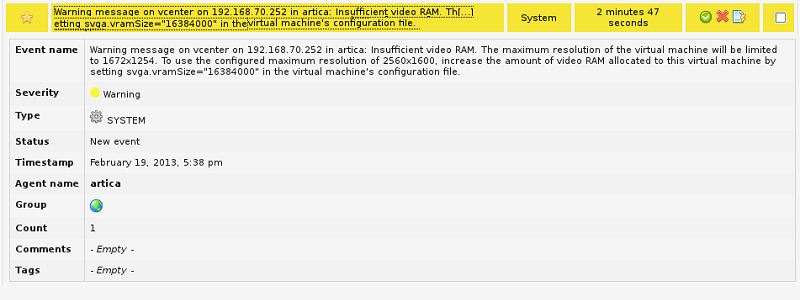

Мониторинг событий VMware

Эта функция делает копию событий, присутствующих в vCenter VMware® в список событий Pandora FMS.

Эти события становятся частью обычного потока событий Pandora FMS и автоматически ассоциируются с агентом, представляющим vCenter, из которого они исходят (если агент существует на момент создания события).

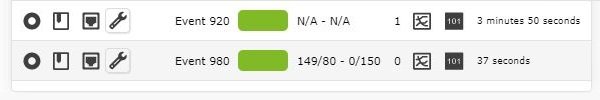

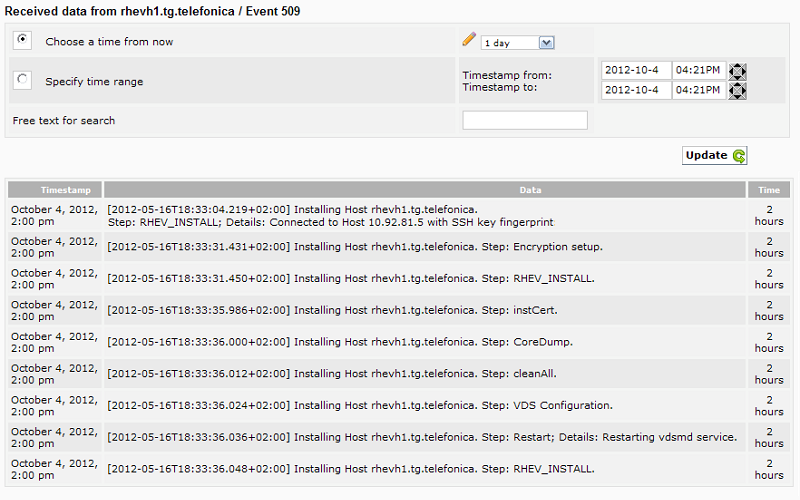

В процессе создания дампа событий учитывается информация и степень серьезности, которые VMware® указывает при создании события, поэтому события с критическим, предупреждающим или информативным уровнем серьезности сохранят эти уровни в Pandora FMS. На следующем изображении показан пример подробной информации о дампе событий из VMware в Pandora FMS.

Со всеми событиями, присутствующими в Pandora FMS, можно выполнять все доступные действия по управлению событиями, такие как: создание предупреждений, настройка фильтров, открытие инцидентов и т.д.

Управление и визуализация виртуальной архитектуры VMware

Вместе с плагином VMware® распространяются два расширения: VMware Manager® и VMware View®. VMware View® позволяет визуализировать все компоненты архитектуры VMware® в удобном виде. Кроме того, с помощью VMware Manager® вы можете управлять большим количеством виртуальных машин, останавливая, запуская, сбрасывая или приостанавливая их активность из консоли Pandora FMS.

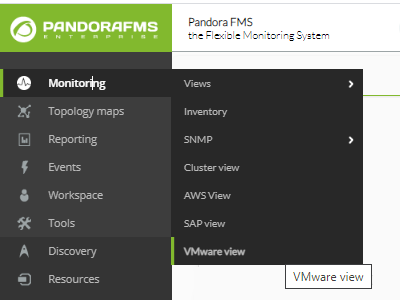

Использование VMware View

Чтобы начать использовать средство просмотра архитектуры VMware®, перейдите в раздел Monitoring → VMware view.

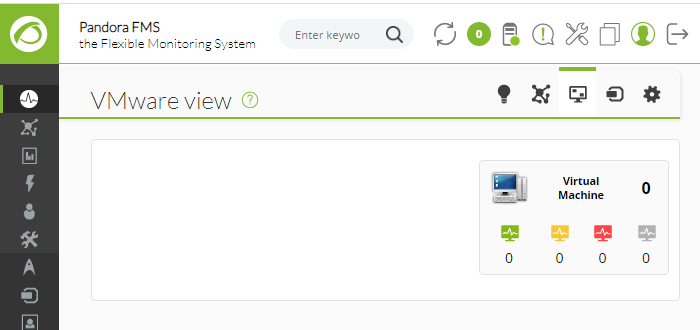

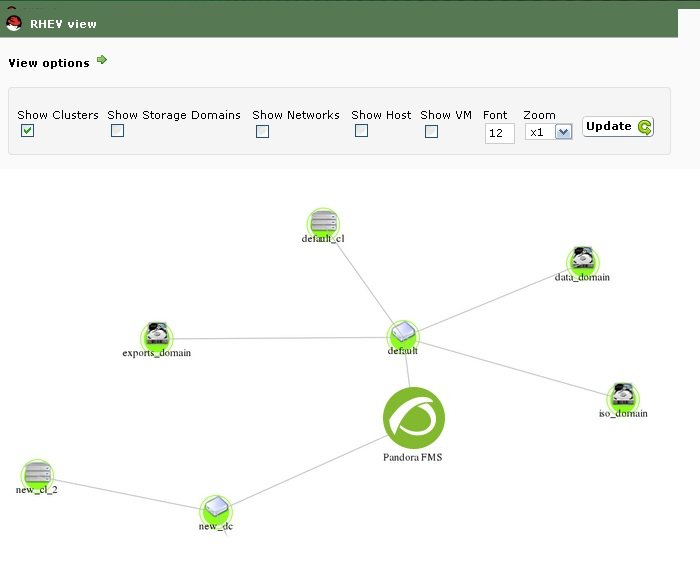

Если у вас нет устройства для мониторинга или вы не настроили API vCenter® и ESXi VMware® вы получите нечто похожее на следующее изображение:

Если плагин находится в рабочем состоянии, вы получите это сообщение (нажмите на Show):

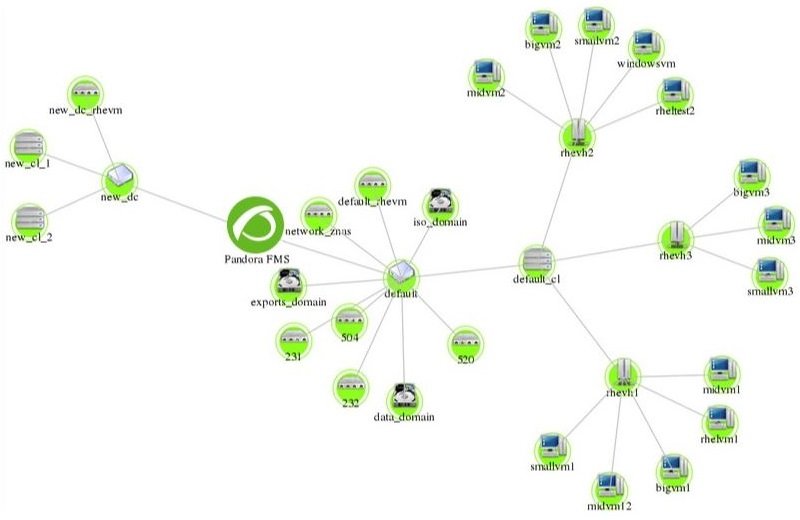

Расширение VMware View® покажет вам карту, подобную приведенной ниже, со всей архитектурой VMware®.

Карта содержит элементы архитектуры VMware® (виртуальные машины, ESX, DataStores и DataCenters) с различными иконками, которые их идентифицируют, а также состояние агентов Pandora FMS, которые представляют каждый элемент. Кроме того, показана взаимосвязь между виртуальными машинами, ESX и DataCenter. Таким образом можно быстро и просто посмотреть состояние архитектуры VMware®.

Это расширение имеет некоторые опции, которые помогают улучшить визуализацию архитектуры, скрывая элементы, увеличивая размер шрифта и позволяя увеличить масштаб, чтобы увидеть элементы с большей детализацией.

Используя приведенные выше параметры, вы можете показать только DataCenter и ESX.

VMware View Dashboards

VMware View® предоставляет два дополнительных вида в дополнение к виду топологической карты виртуальной архитектуры. Новые вкладки позволяют переключаться между различными видами VMware View®.

Первый вид - это общая приборная панель, где можно сразу увидеть общее состояние виртуальной архитектуры в цифрах, т.е. сколько виртуальных машин, хостов ESXi или DataStores имеют проблемы. Вы также сможете увидеть общие параметры производительности благодаря графикам, которые показывают 5 виртуальных машин, потребляющих больше всего памяти, процессора, диска и сети из всей виртуальной архитектуры.

Второй вид позволяет увидеть показатели производительности для каждого хоста ESX. В этом виде вы можете выбрать хост ESX, для которого будет загружена приборная панель, в которой будет отображаться статус хоста и виртуальных машин, а также некоторые показатели производительности, касающиеся использования процессора, памяти, диска и сети хоста ESXi. Кроме того, этот вид также предлагает несколько графиков, которые показывают виртуальные машины, потребляющие больше ресурсов (процессор, память, диск и сеть) выбранного хоста.

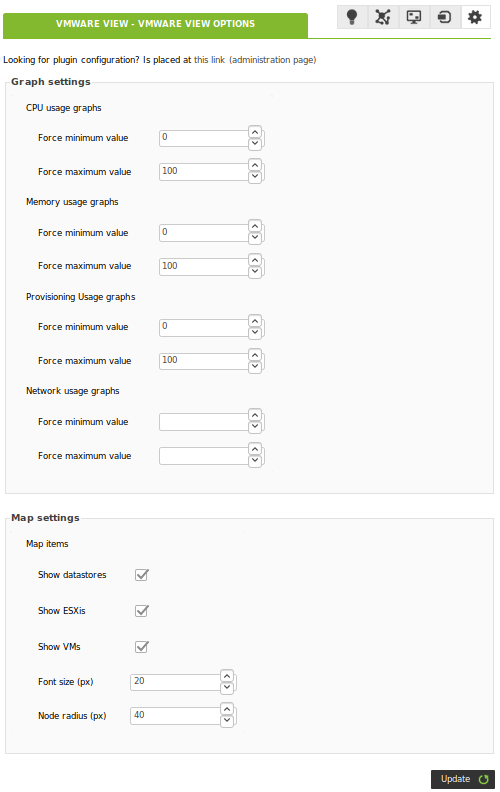

VMware View Options Tab

Расширение VMWare входит в комплект поставки Pandora FMS Console Enterprise. В нем есть панель конфигурации для настройки параметров панелей и карт:

- Вы можете настроить пороги вида (минимум - максимум) графиков приборных панелей.

- Вы можете настроить параметры просмотра карты по умолчанию.

- Содержит ссылку на систему управления конфигурацией.

Доступно во вкладке опций VMWare View®:

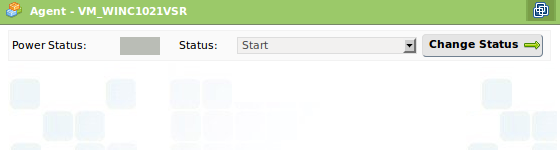

Использование расширения VMware Manager из Агентов

Для использования расширения VMware® Manager необходимо перейти к просмотру операций агента, соответствующего виртуальной машине в этой архитектуре. Внутри этого просмотра вы увидите значок с символом VMware, который соответствует расширению.

Расширение VMware® Manager позволяет управлять виртуальными машинами из консоли Pandora FMS. Расширение показывает текущее состояние виртуальной машины с помощью цветового кода:

- Зеленый = Включена.

- Оранжеваый = На паузе.

- Серый = Остановлена.

Кроме того, в комбинированном режиме оно показывает доступные состояния и позволяет изменить состояние виртуальной машины на выбранное, нажав кнопку Change Status.

Выбор состояния Stop и нажатие на Change status:

Это приведет к остановке машины, а вид расширения VMware Manage изменится и покажет, что машина теперь остановлена:

Данное расширение требует установки VMware SDK® для Perl на той же машине, которая поддерживает Консоль Pandora FMS; без этого требования расширение работать не будет

Если вы настроили мониторинг с помощью RENAME, эта утилита не будет работать с переименованными целями.

Конфигурация плагина VMware

По умолчанию VMware плагин обнаруживает все объекты и добавляет проверки по умолчанию. С помощью конфигурационного файла вы можете настроить мониторинг и выбрать, какие переменные вы хотите отслеживать.

Файл конфигурации содержит всю необходимую для проведения мониторинга информацию, сгруппированную в следующих разделах: Configuration, Rename, Reject, Datacenter, Datastore, ESX, VM.

Все ошибки, связанные с конфигурационным файлом, отображаются в журнале ошибок сервера Pandora FMS, а также в средстве просмотра событий Консоли Pandora FMS. Поэтому вы можете узнать, есть ли какие-либо ошибки в конфигурационном файле, проверив любой из этих двух источников.

Файл Конфигурации

Общая конфигурация

Общая конфигурация определяется токеном Configuration и содержит следующие параметры:

- server: IP-адрес vCenter.

- user: Пользователь vCenter.

- pass: Пароль для доступа к vCenter.

- datacenter: Центр обработки данных для мониторинга.

- temporal: Временный каталог.

- logfile: Расположение файла журнала.

- entities_list: Расположение файла, содержащего список объектов, на которых проводится мониторинг.

- transfer_mode: Режим передачи для XML, он может быть через tentacle или локальным.

- tentacle: Отправка XML-файлов на сервер Pandora FMS, используя протокол Tentacle.

- local: Копирует файлы в локальную папку; Агент должен быть запущен на той же машине, что и локальная папка.

- tentacle_ip: IP-адрес сервера Pandora FMS для отправки информации.

- tentacle_port: Порт сервера Pandora FMS, на который отправляется информация (по умолчанию 41121).

- tentacle_opts: Дополнительные опции для отправки с Tentacle (по умолчанию их нет).

- local_folder: Целевой каталог для копирования XML при включенном локальном режиме.

- pandora_url: URL консоли Pandora FMS (например:

http://192.168.70.81/pandora_console ).

- api_pass: Пароль API консоли Pandora FMS.

- api_user: Пользователь консоли Pandora FMS.

- api_user_pass: Пароль пользователя консоли Pandora FMS.

- retry_send: Включает (1) или отключает (0) пересылку файлов .data в каталоге <i>temporal</i>

- event_mode: Флаг, активирующий режим сбора событий. Если он равен 1, то активируется, если 0 - деактивируется.

- event_pointer_file: Расположение временного файла, в котором хранится указатель для сбора событий.

- verbosity: Уровень лога (0 только ошибки, препятствующие работе плагина, 1 все ошибки).

- threads: Количество потоков плагина (по умолчанию 1).

- interval: Диапазон агентов, представляющих объекты VMware®.

Пример такого раздела в конфигурационном файле может выглядеть следующим образом:

Configuration server 192.168.70.249 user Administrator pass S1stemas datacenter artica temporal /tmp logfile /tmp/vmware_plugin.log entities_list /tmp/vmware_entities_list.txt transfer_mode tentacle tentacle_ip 192.168.70.81 tentacle_port 41121 tentacle_opts local_folder /var/spool/pandora/data_in pandora_url http://192.168.70.81/pandora_console api_pass 1234 api_user admin api_user_pass pandora event_mode 0 event_pointer_file /tmp/vmware_events_pointer.txt

Если вы используете плагин в системах MS Windows®, необходимо будет заменить все пути к файлам на пути, совместимые с Windows®.

Сканирование объектов

Чтобы использовать эту функцию в Discovery, добавьте нужную конфигурацию в Extra settings.

Из-за размеров инфраструктур VMware, характерных для клиентов Enterprise, полное сканирование всех доступных объектов при каждом запуске может вызвать проблемы с производительностью.

Чтобы избежать этой ситуации, плагин мониторинга VMware имеет файл объектов ( entities_list ), в котором хранится список объектов, сканируемых при первом запуске.

Пока существует этот файл, мониторинг ограничен перечисленными в нем объектами.

Если вам необходимо периодическое сканирование инфраструктуры VMware, вы можете удалять этот файл время от времени (например, каждый час) с помощью cron системы.

Переименование объектов

Чтобы использовать эту функцию в Discovery, добавьте нужную конфигурацию в Extra settings.

Переименование объектов осуществляется с помощью токена RENAME и позволяет вам переименовывать объекты, обнаруженные плагином. При использовании этой функции Агенты, созданные в Pandora FMS, будут отображаться с новым присвоенным именем. Структура данного раздела выглядит следующим образом:

<настоящее имя> TO <новое имя>

Пример конфигурации этого раздела может быть следующим:

#Rename entities Rename Debian 11 TO Virtual Machine 1 RedHat 12 TO Web server ESX Workstation TO Host Work Sales

Исключение объектов

Чтобы использовать эту функцию в Discovery, добавьте нужную конфигурацию в Extra settings.

Плагин позволяет исключать объекты по типу или по отдельности, оба варианта описаны ниже.

Отбрасывание объектов по типу осуществляется с использованием токена REJECT. В этом разделе вы можете отбрасывать объекты в соответствии с их типом; например, все виртуальные машины или все хосты ESX. Возможные значения, которые может принимать этот раздел, следующие: all_datastore, all_datacenter, all_esx, all_vm.

Конфигурация этой секции, которая отбрасывает все объекты, будет выглядеть следующим образом:

#Dismissed entities Reject all_datastore all_datacenter all_esx all_vm

Для выполнения отбрасывания объектов по отдельности необходимо будет удалить их из файла объектов, созданного плагином. Плагин создает этот файл в месте, указанном в параметре entities_list (по умолчанию /tmp/vmware_entities_list.txt). Плагин заполняет содержимое этого файла при первом запуске, или когда его не существует, создавая список всех обнаруженных объектов. Примером файла может быть следующее:

Datacenter artica Datastore datastore_1 datastore2 ESX 192.168.70.252 VM Pandora FMS 4.0.3 Debian2 Debian3 Debian4 Redhat debian5 Debian6 Debian8 Debian7 Debian11 Debian10 Debian9 NSM Pandora vcenter suse11.2

Файл конфигурации разделен на несколько токенов: Datacenter, Datastore, ESX и VM, где перечислены различные объекты. После создания файла конфигурации плагин будет считывать из этого файла объекты для мониторинга. Чтобы отбросить объект, достаточно удалить его из этого файла. Если, например, вам не нужно проводить мониторинг объектов: Debian2, datastore2, NSM, suse11.2 и 192.168.70.252, конфигурационный файл будет выглядеть следующим образом:

Datacenter artica Datastore datastore_1 ESX VM Pandora FMS 4.0.3 Debian3 Debian4 Redhat debian5 Debian6 Debian8 Debian7 Debian11 Debian10 Debian9 Pandora vcenter

Эта функция позволяет распределить нагрузку на мониторинг, ограничивая количество объектов, отслеживаемых при каждом выполнении плагина. Ниже описаны различные методы распределения нагрузки.

Конфигурация мониторинга

Чтобы использовать эту функцию в Discovery, добавьте нужную конфигурацию в Extra settings.

В следующих разделах файла настраиваются модули, созданные для каждого типа объекта. В разделах используются токены. Datacenter, Datastore, ESX, VM. В этих разделах вы можете включить/выключить модули для мониторинга. В следующем примере мы создали конфигурацию, выбрав модули, которые мы хотим создать для ESX и виртуальных машин:

... #ESX Modules ESX cpuUsagePercent disabled diskRead enabled diskWrite enabled #VM Modules VM diskReadLatency disabled diskWriteLatency disabled diskRate enabled ...

Каждая строка конфигурации соответствует одному модулю. В приведенном примере модули будут созданы со значениями по умолчанию, но можно настроить имя, описание и ограничения для Предупреждающего и Критического состояний Модуля. Примером такой конфигурации может быть следующее:

... #VM Modules ESX diskReadLatency disabled diskWriteLatency disabled diskRate name = Tasa Disco; desc = Tasa Lec/Esc disco; limits_warn = 5 10; limits_crit = 0 4 ...

Для конфигурации модуля доступны следующие опции:

- <модуль> disabled: Модуль НЕ будет создан.

- <модуль> enabled: Модуль БУДЕТ создан (со значениями по умолчанию).

- <модуль> name = <имя>; desc = <описание>; limits_warn <lim_warn>; limits_crit <lim_crit» Модуль будет создан с указанным именем и описанием, а также будут определены пороговые значения для самого высокого и самого низкого состояний Предупреждения и Критического.

Очень важно обратить внимание на структуру строк конфигурационного файла и особенно проверить, чтобы символ ; был присоединен к имени и описанию Модуля. Эти две строки НЕ РАВНЫ (см. пробелы перед символом ; ):

diskRate name = Tasa Disco; desc = Tasa Lec/Esc disco; limits_warn = 5 10; limits_crit = 0 4 diskRate name = Tasa Disco ; desc = Tasa Lec/Esc disco ; limits_warn = 5 10; limits_crit = 0 4

На модули ссылаются по их короткому имени - эквивалентному имени, которое легче набрать в командной строке. Таблица соответствия кратких и расширенных названий находится в следующем разделе.

Проанализируйте пример конфигурации, приведенный выше. Модуль Disk Rate был настроен на создание со следующими значениями:

* Имя: Скорость Диска * Описание: Скорость Записи/Чтения Диска * Min Warning: 5 * Max Warning: 10 * Min Critical: 0 * Max Critical: 4

Есть модули, которые генерируются динамически, например, связанные с дисками или сетевыми интерфейсами. Для этих метрик плагин создает Модуль для каждого обнаруженного элемента. Эти модули обычно имеют специальные названия, например, в Pandora FMS:

Disk Free [0] Disk Free [1] Disk Free [2] ...

В этих случаях, поскольку имя имеет динамическую часть, допускается использование макроса %s, который будет заменен на переменную часть имени Модуля. Пример динамической конфигурации модуля выглядит следующим образом:

diskFree name = Disk (%s) free space; desc = Free space for disk; limits_warn = 0 0; limits_crit = 0 0

В этом случае имя модуля по умолчанию:

Disk Free [0]

И оно будет переименовано в:

Disk (0) free space

Также можно настроить текстовые строки для границ предупреждающего и критического состояний модулей. Конфигурация будет выглядеть следующим образом:

powerState name = Estado funcionamiento; desc = Estado funcionamiento VM; limits_warn = .*suspended.*; limits_crit = .*poweredOff.*

Можно настроить регулярные выражения для обеспечения большей гибкости при установке ограничений.

Пользовательские метрики производительности

Чтобы использовать эту функцию в Discovery, добавьте нужную конфигурацию в Extra settings.

В этом разделе можно настроить новые модули, связанные с Performance Counters для виртуальных машин и ESX. Для настройки нового модуля производительности необходимо использовать следующую структуру:

custom_performance type = mem; metric = swapinRate; module_type = generic_data; name = Swap In Rate; desc = Swap In Rate for host; limits_warn = 0 0; limits_crit = 0 0

Настраиваются следующие параметры:

- type: Тип метрик, подлежащих мониторингу. Виды метрики следующие:

- cpu: Характеристики центрального процессора.

- mem: Память.

- disk: Диск, хранилище.

- net: Сеть.

- sys: Система.

- metric: Метрика для мониторинга (ниже объясняется, где можно найти наиболее доступные метрики).

- module_type: Тип Модуля Pandora FMS (например: generic_data).

- name: Название Модуля.

- desc: Описание Модуля.

- limits_warn: Пределы для состояния Предупреждение.

- limits_crit: Пределы для Критического состояния.

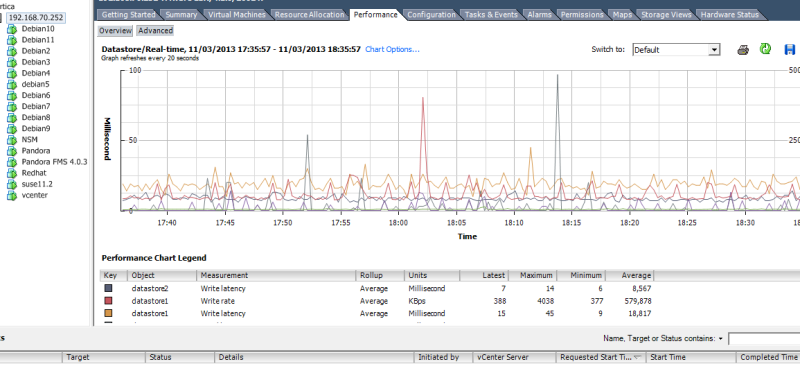

Вы можете ознакомиться с наиболее доступными техниками для каждого типа в разделе Performance каждого объекта. Этот вид находится внутри vCenter и показывает метрики производительности, которые можно отслеживать с помощью плагина. VMware®. Например, на следующем изображении показан вид de Performance для хоста ESX.

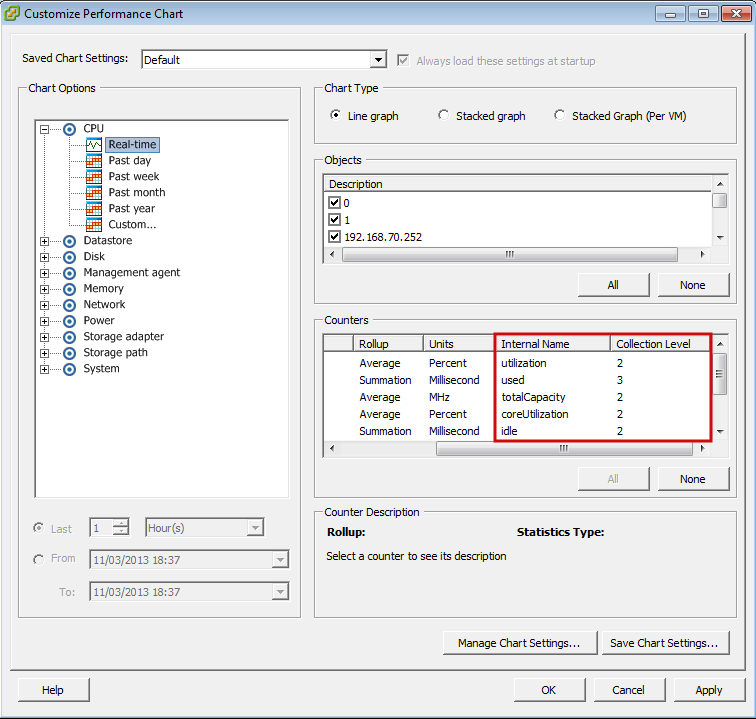

Чтобы увидеть полный список всех инструментов в соответствии с их типом, нажмите на кнопку Advanced, а затем на кнопку Char option. Вы увидите список со всеми типами инструментов и соответствующими инструментами каждого типа:

Для каждого типа метрики появится ряд счетчиков, которые являются переменными, которые мы сможем отслеживать с помощью Pandora FMS. Для мониторинга переменной нам нужен ее Internal Name. Кроме того, необходимо убедиться, что уровень статистики, настроенный в vCenter, позволяет отображать искомую переменную, сравнив ее с полем Collection Level метрики.

Например, если вам нужно посмотреть использование процессора хоста ESX, мы найдем переменные типа cpu для ESX и из доступных выберем utilization. В конфигурационный файл (в данном случае в раздел ESX) нужно добавить следующую строку:

custom_performance type = cpu; metric = utilization; module_type = generic_data; name = CPU Utilization; desc = CPU Utilization for ESX; limits_warn = 0 0; limits_crit = 0 0

Мониторинг нескольких Центров Обработки Данных с помощью одного и того же агента

Каждый модуль плагина, настроенный в Агенте, контролирует один ЦОД, поэтому если вы хотите контролировать несколько ЦОД с помощью одного и того же Программного Агента Pandora FMS, необходимо принять следующие меры.

- Необходимо добавить

module_pluginдля каждого ЦОД, который необходимо контролировать; например:

module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter1.conf module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter2.conf

- В каждом файле конфигурации необходимо будет изменить параметры: logfile, entities_list, event_pointer_file. Конфигурационные файлы будут выглядеть следующим образом:

vmware-plugin-datacenter1.conf

... logfile /tmp/vmware_plugin_datacenter1.log entities_list /tmp/vmware_entities_list_datacenter1.txt event_pointer_file /tmp/vmware_events_pointer_datacenter1.txt ...

vmware-plugin-datacenter2.conf

... logfile /tmp/vmware_plugin_datacenter2.log entities_list /tmp/vmware_entities_list_datacenter2.txt event_pointer_file /tmp/vmware_events_pointer_datacenter2.txt ...

- Если вы также хотите сделать копию событий, необходимо иметь еще два модуля плагина с соответствующими конфигурационными файлами и активировать флаг.

event_mode. Конфигурация module_plugin будет выглядеть следующим образом:

module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter1.conf module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter1-events.conf module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter2.conf module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter2-events.conf

Разделите нагрузку по мониторингу между несколькими серверами Pandora FMS

Параметры конфигурационного файла плагина позволяют легко распределить нагрузку мониторинга между несколькими серверами Pandora FMS. Возьмем, к примеру, следующую структуру среды виртуализации:

DC

|

|- Datastore_1

|- DataStore_2

|

|- ESX_1

|- mv1.1

|- mv1.2

|- mv1.3

|- ESX_2

|- mv2.1

|- mv2.2

|- mv2.3

Он имеет два сервера Pandora FMS для мониторинга. Простым способом разделения нагрузки может быть мониторинг центра данных, хранилищ данных и ESX на первом сервере и всех виртуальных машин на втором сервере. Конфигурационные файлы плагина будут следующими:

Сервер 1:

Reject all_vm

Сервер 2:

Reject all_datacenter all_datastore all_esx

Сервер 1 следит за всем за исключением виртуальных машин, а Сервер 2 только за виртуальными машинами.

Другим способом распределения нагрузки может быть разделение мониторинга по ESX; первый сервер Pandora FMS будет отслеживать все, что связано с первым сервером ESX, а второй - все, что связано со вторым ESX. Для этого мы разделим файл entities_list.txt на два файла и настроим два выполнения плагина в разных агентах. Файлы entities_list.txt будут выглядеть следующим образом:

Сервер 1:

Datacenter DC Datastore Datastore_1 ESX ESX_1 VM mv1.1 mv1.2 mv1.3

Сервер 1 пропускает все, что связано со второй группой объектов VMware, поэтому он отвечает за мониторинг половины среды.

Сервер 2:

Datastore DataStore_2 ESX ESX_2 VM mv2.1 mv2.2 mv2.3

Сервер 2 опускает все, что связано с первой группой объектов VMware в дополнение к ЦОД, поскольку за ним следит сервер 1.

Конфигурация отбрасываемых объектов очень гибкая и позволяет разделить нагрузку, назначая определенное количество объектов каждому агенту Pandora FMS.

Примеры файлов конфигурации

Архив со всеми деактивированными модулями

#These lines are comments #Datacenter Modules Datacenter ping disabled check443 disabled #Datastore Modules Datastore capacity disabled freeSpace disabled overallocation disabled freeSpaceBytes disabled #ESX Modules ESX bootTime disabled cpuInfo disabled memorySize disabled overallCpuUsage disabled overallMemoryUsage disabled powerState disabled sslThumbprint disabled uptime disabled vnicInfo disabled hostAlive disabled connectionState disabled diskRead disabled diskWrite disabled diskReadLatency disabled diskWriteLatency disabled netReceived disabled netTransmitted disabled netPkgRx disabled netPkgTx disabled cpuUsagePercent disabled memoryUsagePercent disabled netUsage disabled diskRate disabled maxDiskLatency disabled haStatus disabled #VM Modules VM bootTime disabled connectionState disabled consumedOverheadMemory disabled cpuAllocation disabled diskFree disabled guestState disabled host disabled hostAlive disabled hostMemoryUsage disabled hostName disabled ipAddress disabled macAddress disabled maxCpuUsage disabled maxMemoryUsage disabled memoryAllocation disabled memoryOverhead disabled overallCpuDemand disabled overallCpuUsage disabled powerState disabled privateMemory disabled sharedMemory disabled toolsRunningStatus disabled triggeredAlarmState disabled virtualImagePath disabled uptimeSeconds disabled diskRead disabled diskWrite disabled diskReadLatency disabled diskWriteLatency disabled netReceived disabled netTransmitted disabled netPkgRx disabled netPkgTx disabled cpuUsagePercent disabled memoryUsagePercent disabled netUsage disabled diskRate disabled maxDiskLatency disabled heartbeat disabled cpuReady disabled snapshotCounter disabled

Таблица соответствия кратких имен

datacenter

| Полное Имя | Короткое Имя |

|---|---|

| Ping | ping |

| Check 443 port | check443 |

Datastores

| Полное Имя | Короткое Имя |

|---|---|

| Capacity | capacity |

| Free Space | freeSpace |

| Disk Overallocation | overallocation |

| Free Space Bytes | freeSpaceBytes |

ESX

| Полное Имя | Короткое Имя |

|---|---|

| Boot Time | bootTime |

| CPU Info | cpuInfo |

| Memory Size | memorySize |

| Overall CPU Usage | overallCpuUsage |

| Overall Memory Usage | overallMemoryUsage |

| Power State | powerState |

| SSL Thumbprint | sslThumbprint |

| Uptime | uptime |

| VNIC Info | vnicInfo |

| Host Alive | hostAlive |

| Connection State | connectionState |

| Disk Read | diskRead |

| Disk Write | diskWrite |

| Disk Read Latency | diskReadLatency |

| Disk Write Latency | diskWriteLatency |

| Data received | netReceived |

| Data transmitted | netTransmitted |

| Packages Received | netPkgRx |

| Packages Transmitted | netPkgTx |

| CPU Usage | cpuUsagePercent |

| Memory Usage | memoryUsagePercent |

| Net Usage | netUsage |

| Disk Rate | diskRate |

| Max Disk Latency | maxDiskLatency |

| HA Status | haStatus |

| Sensor* | systemHealthInfo |

Виртуальные машины

| Полное Имя | Короткое Имя |

|---|---|

| Boot Time | bootTime |

| Connection State | connectionState |

| Consumed Overhead Memory | consumedOverheadMemory |

| CPU Allocation | cpuAllocation |

| Disk Free | diskFree |

| Guest State | guestState |

| Host Info | host |

| Host Alive | hostAlive |

| Host Memory Usage | hostMemoryUsage |

| Host Name | hostName |

| IP Address | ipAddress |

| MAC Address | macAddress |

| Max CPU Usage | maxCpuUsage |

| Max Memory Usage | maxMemoryUsage |

| Memory Allocation | memoryAllocation |

| Memory Overhead | memoryOverhead |

| Overall CPU Demand | overallCpuDemand |

| Overall CPU Usage | overallCpuUsage |

| Power State | powerState |

| Private Memory | privateMemory |

| Shared Memory | sharedMemory |

| Tools Running Status | toolsRunningStatus |

| Trigger Alarm State | triggeredAlarmState |

| Uptime Seconds | uptimeSeconds |

| Virtual Image Path | virtualImagePath |

| Disk Read | diskRead |

| Disk Write | diskWrite |

| Disk Read Latency | diskReadLatency |

| Disk Write Latency | diskWriteLatency |

| Data received | netReceived |

| Data transmitted | netTransmitted |

| Packages Received | netPkgRx |

| Packages Transmitted | netPkgTx |

| CPU Usage | cpuUsagePercent |

| Memory Usage | memoryUsagePercent |

| Net Usage | netUsage |

| Disk Rate | diskRate |

| Max Disk Latency | maxDiskLatency |

| HeartBeat | heartbeat |

| CPU Ready | cpuReady |

| Number Snapshots | snapshotCounter |

| HA Status | haStatus |

Таблица событий

Этот список событий предоставляется для облегчения задачи настройки оповещений о событиях в Pandora FMS. Полный и актуальный перечень всех возможных событий можно найти в документации VMware

| Событие | Степень тяжести | Тип события | Группа | |

|---|---|---|---|---|

| An account was created on host {host.name} | Informational | System | All | |

| Account {account} was removed on host {host.name} | Informational | System | All | |

| An account was updated on host {host.name} | Informational | System | All | |

| The default password for the root user on the host {host.name} has not been changed | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} triggered an action | Informational | System | All | |

| Created alarm '{alarm.name}' on {entity.name} | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} sent email to {to} | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} cannot send email to {to} | Critical | System | All | |

| Reconfigured alarm '{alarm.name}' on {entity.name} | Informational | System | All | |

| Removed alarm '{alarm.name}' on {entity.name} | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} ran script {script} | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} did not complete script: {reason.msg} | Critical | System | All | |

| Alarm '{alarm.name}': an SNMP trap for entity {entity.name} was sent | Informational | System | All | |

| Alarm '{alarm.name}' on entity {entity.name} did not send SNMP trap: {reason.msg} | Critical | System | All | |

| Alarm '{alarm.name}' on {entity.name} changed from {from.@enum.ManagedEntity.Status} to {to.@enum.ManagedEntity.Status} | Informational | System | All | |

| All running virtual machines are licensed | Informational | System | All | |

| User cannot logon since the user is already logged on | Informational | System | All | |

| Cannot login {userName}@{ipAddress} | Critical | System | All | |

| The operation performed on host {host.name} in {datacenter.name} was canceled | Informational | System | All | |

| Changed ownership of file name {filename} from {oldOwner} to {newOwner} on {host.name} in {datacenter.name}. | Informational | System | All | |

| Cannot change ownership of file name {filename} from {owner} to {attemptedOwner} on {host.name} in {datacenter.name}. | Critical | System | All | |

| Checked cluster for compliance | Informational | System | All | |

| Created cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| Removed cluster {computeResource.name} in datacenter {datacenter.name} | Informational | System | All | |

| Insufficient capacity in cluster {computeResource.name} to satisfy resource configuration in {datacenter.name} | Critical | System | All | |

| Reconfigured cluster {computeResource.name} in datacenter {datacenter.name} | Informational | System | All | |

| Configuration status on cluster {computeResource.name} changed from {oldStatus.@enum.ManagedEntity.Status} to {newStatus.@enum.ManagedEntity.Status} in {datacenter.name} | Informational | System | All | |

| Created new custom field definition {name} | Informational | System | All | |

| Removed field definition {name} | Informational | System | All | |

| Renamed field definition from {name} to {newName} | Informational | System | All | |

| Changed custom field {name} on {entity.name} in {datacenter.name} to {value} | Informational | System | All | |

| Cannot complete customization of VM {vm.name}. See customization log at {logLocation} on the guest OS for details. | Informational | System | All | |

| An error occurred while setting up Linux identity. See log file '{logLocation}' on guest OS for details. | Critical | System | All | |

| An error occurred while setting up network properties of the guest OS. See the log file {logLocation} in the guest OS for details. | Critical | System | All | |

| Started customization of VM {vm.name}. Customization log located at {logLocation} in the guest OS. | Informational | System | All | |

| Customization of VM {vm.name} succeeded. Customization log located at {logLocation} in the guest OS. | Informational | System | All | |

| The version of Sysprep {sysprepVersion} provided for customizing VM {vm.name} does not match the version of guest OS {systemVersion}. See the log file {logLocation} in the guest OS for more information. | Critical | System | All | |

| An error occurred while customizing VM {vm.name}. For details reference the log file {logLocation} in the guest OS. | Critical | System | All | |

| dvPort group {net.name} in {datacenter.name} was added to switch {dvs.name}. | Informational | System | All | |

| dvPort group {net.name} in {datacenter.name} was deleted. | Informational | System | All | |

| Informational | System | All | ||

| dvPort group {net.name} in {datacenter.name} was reconfigured. | Informational | System | All | |

| dvPort group {oldName} in {datacenter.name} was renamed to {newName} | Informational | System | All | |

| HA admission control disabled on cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| HA admission control enabled on cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| Re-established contact with a primary host in this HA cluster | Informational | System | All | |

| Unable to contact a primary HA agent in cluster {computeResource.name} in {datacenter.name} | Critical | System | All | |

| All hosts in the HA cluster {computeResource.name} in {datacenter.name} were isolated from the network. Check the network configuration for proper network redundancy in the management network. | Critical | System | All | |

| HA disabled on cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| HA enabled on cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| A possible host failure has been detected by HA on {failedHost.name} in cluster {computeResource.name} in {datacenter.name} | Critical | System | All | |

| Host {isolatedHost.name} has been isolated from cluster {computeResource.name} in {datacenter.name} | Warning | System | All | |

| Created datacenter {datacenter.name} in folder {parent.name} | Informational | System | All | |

| Renamed datacenter from {oldName} to {newName} | Informational | System | All | |

| Datastore {datastore.name} increased in capacity from {oldCapacity} bytes to {newCapacity} bytes in {datacenter.name} | Informational | System | All | |

| Removed unconfigured datastore {datastore.name} | Informational | System | All | |

| Discovered datastore {datastore.name} on {host.name} in {datacenter.name} | Informational | System | All | |

| Multiple datastores named {datastore} detected on host {host.name} in {datacenter.name} | Critical | System | All | |

| <internal> | Informational | System | All | |

| File or directory {sourceFile} copied from {sourceDatastore.name} to {datastore.name} as {targetFile} | Informational | System | All | |

| File or directory {targetFile} deleted from {datastore.name} | Informational | System | All | |

| File or directory {sourceFile} moved from {sourceDatastore.name} to {datastore.name} as {targetFile} | Informational | System | All | |

| Reconfigured Storage I/O Control on datastore {datastore.name} | Informational | System | All | |

| Configured datastore principal {datastorePrincipal} on host {host.name} in {datacenter.name} | Informational | System | All | |

| Removed datastore {datastore.name} from {host.name} in {datacenter.name} | Informational | System | All | |

| Renamed datastore from {oldName} to {newName} in {datacenter.name} | Informational | System | All | |

| Renamed datastore from {oldName} to {newName} in {datacenter.name} | Informational | System | All | |

| Disabled DRS on cluster {computeResource.name} in datacenter {datacenter.name} | Informational | System | All | |

| Enabled DRS on {computeResource.name} with automation level {behavior} in {datacenter.name} | Informational | System | All | |

| DRS put {host.name} into standby mode | Informational | System | All | |

| DRS is putting {host.name} into standby mode | Informational | System | All | |

| DRS cannot move {host.name} out of standby mode | Critical | System | All | |

| DRS moved {host.name} out of standby mode | Informational | System | All | |

| DRS is moving {host.name} out of standby mode | Informational | System | All | |

| DRS invocation not completed | Critical | System | All | |

| DRS has recovered from the failure | Informational | System | All | |

| Unable to apply DRS resource settings on host {host.name} in {datacenter.name}. {reason.msg}. This can significantly reduce the effectiveness of DRS. | Critical | System | All | |

| Resource configuration specification returns to synchronization from previous failure on host '{host.name}' in {datacenter.name} | Informational | System | All | |

| {vm.name} on {host.name} in {datacenter.name} is now compliant with DRS VM-Host affinity rules | Informational | System | All | |

| {vm.name} on {host.name} in {datacenter.name} is violating a DRS VM-Host affinity rule | Informational | System | All | |

| DRS migrated {vm.name} from {sourceHost.name} to {host.name} in cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| DRS powered On {vm.name} on {host.name} in {datacenter.name} | Informational | System | All | |

| Virtual machine {macAddress} on host {host.name} has a duplicate IP {duplicateIP} | Informational | System | All | |

| A vNetwork Distributed Switch {dvs.name} was created in {datacenter.name}. | Informational | System | All | |

| vNetwork Distributed Switch {dvs.name} in {datacenter.name} was deleted. | Informational | System | All | |

| vNetwork Distributed Switch event | Informational | System | All | |

| The vNetwork Distributed Switch {dvs.name} configuration on the host was synchronized with that of the vCenter Server. | Informational | System | All | |

| The host {hostJoined.name} joined the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The host {hostLeft.name} left the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The host {hostMember.name} changed status on the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The vNetwork Distributed Switch {dvs.name} configuration on the host differed from that of the vCenter Server. | Warning | System | All | |

| vNetwork Distributed Switch {srcDvs.name} was merged into {dstDvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} was blocked in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The port {portKey} was connected in the vNetwork Distributed Switch {dvs.name} in {datacenter.name} | Informational | System | All | |

| New ports were created in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| Deleted ports in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The dvPort {portKey} was disconnected in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} entered passthrough mode in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} exited passthrough mode in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} was moved into the dvPort group {portgroupName} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} was moved out of the dvPort group {portgroupName} in {datacenter.name}. | Informational | System | All | |

| The port {portKey} link was down in the vNetwork Distributed Switch {dvs.name} in {datacenter.name} | Informational | System | All | |

| The port {portKey} link was up in the vNetwork Distributed Switch {dvs.name} in {datacenter.name} | Informational | System | All | |

| Reconfigured ports in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} was unblocked in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The vNetwork Distributed Switch {dvs.name} in {datacenter.name} was reconfigured. | Informational | System | All | |

| The vNetwork Distributed Switch {oldName} in {datacenter.name} was renamed to {newName}. | Informational | System | All | |

| An upgrade for the vNetwork Distributed Switch {dvs.name} in datacenter {datacenter.name} is available. | Informational | System | All | |

| An upgrade for the vNetwork Distributed Switch {dvs.name} in datacenter {datacenter.name} is in progress. | Informational | System | All | |

| Cannot complete an upgrade for the vNetwork Distributed Switch {dvs.name} in datacenter {datacenter.name} | Informational | System | All | |

| vNetwork Distributed Switch {dvs.name} in datacenter {datacenter.name} was upgraded. | Informational | System | All | |

| Host {host.name} in {datacenter.name} has entered maintenance mode | Informational | System | All | |

| The host {host.name} is in standby mode | Informational | System | All | |

| Host {host.name} in {datacenter.name} has started to enter maintenance mode | Informational | System | All | |

| The host {host.name} is entering standby mode | Informational | System | All | |

| {message} | Critical | System | All | |

| Host {host.name} in {datacenter.name} has exited maintenance mode | Informational | System | All | |

| The host {host.name} could not exit standby mode | Critical | System | All | |

| The host {host.name} is no longer in standby mode | Informational | System | All | |

| The host {host.name} is exiting standby mode | Informational | System | All | |

| Sufficient resources are available to satisfy HA failover level in cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| General event: {message} | Informational | System | All | |

| Error detected on {host.name} in {datacenter.name}: {message} | Critical | System | All | |

| Issue detected on {host.name} in {datacenter.name}: {message} | Informational | System | All | |

| Issue detected on {host.name} in {datacenter.name}: {message} | Warning | System | All | |

| User logged event: {message} | Informational | System | All | |

| Error detected for {vm.name} on {host.name} in {datacenter.name}: {message} | Critical | System | All | |

| Issue detected for {vm.name} on {host.name} in {datacenter.name}: {message} | Informational | System | All | |

| Issue detected for {vm.name} on {host.name} in {datacenter.name}: {message} | Warning | System | All | |

| The vNetwork Distributed Switch corresponding to the proxy switches {switchUuid} on the host {host.name} does not exist in vCenter Server or does not contain this host. | Informational | System | All | |

| A ghost proxy switch {switchUuid} on the host {host.name} was resolved. | Informational | System | All | |

| The message changed: {message} | Informational | System | All | |

| {componentName} status changed from {oldStatus} to {newStatus} | Informational | System | All | |

| Cannot add host {hostname} to datacenter {datacenter.name} | Critical | System | All | |

| Added host {host.name} to datacenter {datacenter.name} | Informational | System | All | |

| Administrator access to the host {host.name} is disabled | Warning | System | All | |

| Administrator access to the host {host.name} has been restored | Warning | System | All | |

| Cannot connect {host.name} in {datacenter.name}: cannot configure management account | Critical | System | All | |

| Cannot connect {host.name} in {datacenter.name}: already managed by {serverName} | Critical | System | All | |

| Cannot connect host {host.name} in {datacenter.name} : server agent is not responding | Critical | System | All | |

| Cannot connect {host.name} in {datacenter.name}: incorrect user name or password | Critical | System | All | |

| Cannot connect {host.name} in {datacenter.name}: incompatible version | Critical | System | All | |

| Cannot connect host {host.name} in {datacenter.name}. Did not install or upgrade vCenter agent service. | Critical | System | All | |

| Cannot connect {host.name} in {datacenter.name}: error connecting to host | Critical | System | All | |

| Cannot connect {host.name} in {datacenter.name}: network error | Critical | System | All | |

| Cannot connect host {host.name} in {datacenter.name}: account has insufficient privileges | Critical | System | All | |

| Cannot connect host {host.name} in {datacenter.name} | Critical | System | All | |

| Cannot connect {host.name} in {datacenter.name}: not enough CPU licenses | Critical | System | All | |

| Cannot connect {host.name} in {datacenter.name}: incorrect host name | Critical | System | All | |

| Cannot connect {host.name} in {datacenter.name}: time-out waiting for host response | Critical | System | All | |

| Host {host.name} checked for compliance. | Informational | System | All | |

| Host {host.name} is in compliance with the attached profile | Informational | System | All | |

| Host configuration changes applied. | Informational | System | All | |

| Connected to {host.name} in {datacenter.name} | Informational | System | All | |

| Host {host.name} in {datacenter.name} is not responding | Critical | System | All | |

| dvPort connected to host {host.name} in {datacenter.name} changed status | Informational | System | All | |

| HA agent disabled on {host.name} in cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| HA is being disabled on {host.name} in cluster {computeResource.name} in datacenter {datacenter.name} | Informational | System | All | |