Supervision d’environnement virtuel

Surveillance d’environnement virtuel

Les environnements virtuels ont une grande importance dans les architectures informatiques de toutes les entreprises et c'est pour ça que sa supervision est essentielle. Avec Pandora FMS Enterprise vous aurez accés à Amazon EC2, VMware, Nutanix, XenServer, OpenNebula, IBM, HMC et HPVM.

Voir aussi Discovery PFMS 2.0 Applications.

Amazon EC2

Pour surveiller EC2 dans des environnements Enterprise, veuillez vous diriger vers ce lien Discovery

Ce guide correspond au composant OpenSource pour la surveillance de EC2

Cette surveillance spécifique utilise le CloudWatch API pour surveiller ses instances dans le service Amazon EC2. Il faut avoir Cloudwatch d’activé dans son instance. Vous pouvez obtenir le plugin gratuit dans la section de la bibliothèque de modules.

L’idée principale de ce plugin de serveur à distance, c’est d’obtenir une information de ses instances en utilisant le serveur de plugin de Pandora FMS. Cela signifie qu’il faudra inscrire le plugin dans le serveur et configurer les différents modules pour qu’ils récupèrent l’information de ses serveurs EC2.

Voici un exemple de l’exécution :

/home/slerena/ec2_plugin.sh \

-A AKIAILTVCAS26GTKLD4A \

-S CgmQ6DxUWES05txju+alJLoM57acDudHogkLotWk \

-i i_9d0b4af1 \

-n AWS/EC2 \

-m CPUUtilization

Il renverra un % de valeur numérique de la métrique CPUUtilization dans l’instance i-9d0b4af1

Pour l’installation, il faudra :

1. Avoir JAVA de disponible dans son serveur Pandora FMS avec son répertoire correspondant JAVAHOME.

2. Copier ce plugin sur un chemin d’accès et définir les autorisations sur 755 et définir le chemin d’accès de base dans la variable AWS_CLOUDWATCH_HOME qui est présente dans les premières lignes du plugin. Il faut éditer les premières lignes du plugin.

Le plugin a différents fichiers :

/ec2_plugin.sh - Plugin itself /bin/* - Composants d’Amazon CloudWatch (Surveillance) Command Line Tools, inclus dans ce paquet. Ces scripts sont distribués sous la Licence Apache.

Mettez le paquet complet dans un répertoire accessible pour le serveur. Par exemple :

/usr/share/pandora_server/plugin/ec2

Et définissez le AWS_CLOUDWATCH_HOME dans /usr/share/pandora_server/plugin/ec2

En cas de doute sur l’installation, exécutez directement cette commande :

/usr/share/pandora_server/plugin/ec2/mon-cmd --version

Vous devriez voir apparaître un message similaire à :

Amazon CloudWatch CLI version 1.0.9.5 (API 2010-08-01)

Si vous obtenez la même chaîne, alors le plugin peut être utilisé.

Si non, il faudra sûrement installer et configurer de façon adéquate les outils de ligne de commandes d’Amazon CloudWatch (surveillance).

Installation

Pré-requis :

- Assurez-vous d’avoir la version Java 1.5 ou une version plus récente d’installée sur votre système :

java -version

- Décompressez le fichier

.zipde déploiement. - Définissez les variables suivantes de l’environnement :

AWS_CLOUDWATCH_HOME- Le répertoire où sont copiés les fichiers de déploiement pour les tester avec :

Unix: ls ${AWS_CLOUDWATCH_HOME}/bin (should list mon-list-metrics ...)

Windows: dir %AWS_CLOUDWATCH_HOME%\bin (should list mon-list-metrics ...)

JAVA_HOME- Répertoire Home de l’installation de Java.- Ajoutez à Path le suivant

${AWS_CLOUDWATCH_HOME}/bin

- Sur Windows :

%AWS_CLOUDWATCH_HOME%\bin à son chemin d’accès

Configuration

Mettez vos références AWS d’utilisateur dans l’outil de ligne de commandes. Il existe deux façons pour fournir les références :

- Les mots de passe AWS

- En utilisant les certificats X.509

Utilisation de mots de passe AWS

- Indiquez de façon explicite les références dans la ligne de commande :

- –I ACCESS_KEY –S SECRET_KEY

- Créer un fichier identifiant. Le déploiement comprend un fichier de modèle :

${AWS_CLOUDWATCH_HOME}/credential-file-path.template.

Editez une copie de ce fichier pour ajouter votre information.Sur UNIX, limitez les autorisations pour le propriétaire du fichier d'identifiants (credential-file) :

$ chmod 600 <archive crée précédemment>.

Une fois l’archive créé, il existe plusieurs façons pour le référencer :

- Fixez la variable suivante de l’environnement :

export AWS_CREDENTIAL_FILE=<credential-file>

- Vous pouvez aussi fournir l’option suivante avec chaque commande :

- –aws-credential-file <credential file>

Utilisation de certificats X.509

Enregistrez votre certificat et mots de passe privés dans les fichiers : e.g. my-cert.pem et my-pk.pem.

Il existe deux modes pour fournir l’information certifiée à la ligne de commandes :

- Fixez les variables suivantes d’environnement :

EC2_CERT=/path/to/cert/file EC2_PRIVATE_KEY=/path/to/key/file

- Indiquez les fichiers directement sur la ligne de commandes pour toutes les commandes :

<command> \

--ec2-cert-file-path=/path/to/cert/file \

--ec2-private-key-file-path=/path/to/key/file

Installation des propriétés de JVM

En fixant la variable de l’environnement SERVICE_JVM_ARGS, vous pourrez passer de façon arbitraire les propriétés JVM à la ligne de commande.

Par exemple, la ligne suivante fixe les propriétés sur Linux/UNIX :

export SERVICE_JVM_ARGS="-Dhttp.proxyHost=http://my.proxy.com -Dhttp.proxyPort=8080"

Mise en marche

Vérifiez que votre installation fonctionne correctement. Exécutez la commande suivante :

$ mon-cmd --help

Vous devriez voir la page d’utilisation pour toutes les commandes de surveillance.

$ mon-list-metrics --headers

Vous devriez également voir une ligne d’en-tête. Si vous avez quelques métriques définies, vous devriez la voir aussi.

VMware

Avec Pandora FMS Enterprise, vous pourrez avoir accès à VMware Monitoring Plugin, un plugin qui permet d’avoir facilement l’architecture VMware sous contrôle.

Architecture VMware à surveiller

Avec ce système, il est possible de surveiller les architectures comme ci-dessous :

Pandora FMS peut surveiller VCenter, des serveurs ESXi et les composants qui virtualisent : Datastores et Machines Virtuelles. Pandora FMS s’appuie sur l’API que fournit le SDK de VMware par Perl pour la collecte de données.

Surveillance avec Discovery Application VMware

Suivez les étapes décrites sur Discovery pour surveiller votre infrastructure VMware grâce à Discovery.

Pré-requis de VMware

Les pré-requis pour le fonctionnement de la tâche de surveillance de VMware sont les suivant :

- Pandora FMS v7.0NG.732 ou plus récent.

- VMware vSphere SDK pour Perl

Configuration du vCenter pour la surveillance

Discovery Applications VMware utilise les métriques qui fournissent l’API des vCenter et ESXi de VMware. La disponibilité de ces métriques dépend des niveaux configurés pour la collecte de statistiques.

Ces niveaux peuvent être modifiés dans le menu vCenter Server Settings et dans l’option Statistics. Pour chaque option de temps et chaque niveau, vous obtiendrez la description des compteurs que collecte le vCenter. Le niveau minimum pour surveiller avec le plugin de Pandora FMS est le Niveau 2.

En dépendant de la configuration du vCenter, il est possible que quelques modules ne fassent pas l’objet de rapport de données sur Pandora FMS. Ceci peut être dû à :

- Il faut d'installer quelque plugins sur le vCenter.

- Qu’il soit nécessaire d’installer un agent VMware (vmware-tools) dans l’entité.

- Simplement parce que l’entité est éteinte (machine virtuelle ou ESXi).

Pour résoudre ces problèmes, il faudra consulter la documentation de VMware.

Quelques solutions, comme par exemple la surveillance de l’état de l’hardware (Hardware Status), pourraient nécessiter une configuration avancée, aussi bien pour le vCenter que les host qui supportent les ESX.

Déploiement de la surveillance de VMware

A partir de la version 732 de Pandora FMS, la surveillance de VMware s’effectue en utilisant le système Discovery Applications .

Si pour une raison particulière, vous souhaitez configurer manuellement le plugin en dehors de cette fonctionnalité, vous pouvez utiliser le mode classique décrit ci-dessous.

S’il est requis de déployer ou de mettre à jour votre version du plugin de VMware® par une autre plus récente, veuillez suivre les étapes décrites ci-après :

Déploiement manuel du plugin

1. Accéder au répertoire dans lequel les fichiers du plugin VMware ont été extraits.

2. Copiez vmware-plugin.{pl,conf} au répertoire correspondant.

sudo cp vmware-plugin.pl vmware-plugin.conf /usr/share/pandora_server/util/plugin/

sudo chown pandora:apache /usr/share/pandora_server/util/plugin/vmware-plugin.{pl,conf}

sudo chmod g+w /usr/share/pandora_server/util/plugin/vmware-plugin.conf

3. Vérifiez les données nécessaires pour configurer le plugin et utiliser l'API de Pandora FMS.

Dans le menu "Configuration" de la console de Pandora FMS, vous pouvez assigner un mot de passe à l’API, tout comme les autorisations d’origines.

4. Editez le fichier de configuration vmware-plugin.conf

5. Vérifiez la disponibilité de VMware® SDK for Perl

Vous pouvez lancer un script avec le contenu suivant pour valider votre installation de VMware® SDK Perl

#!/usr/bin/perl use strict; use warnings; use VMware::VIRuntime; print "VMware SDK Version: " . $VMware::VIRuntime::VERSION . "\n";

Exécutez le script :

perl check_vmware.pl

La sortie doit être similaire à la suivante :

VMware SDK Version: 6.5.0

Vérifiez que la version du SDK est supérieure ou égale à la version de vos produits VMware®.

A partir de la versión 717 du plugin de VMware®, il faudra aussi installer la bibliothèque perl PluginTools.pm, (disponible aussi avec le serveur sur /usr/lib/perl5/PandoraFMS) dans l’équipement où vous souhaiterez le déployer (copier /usr/lib/perl5/PandoraFMS dans l’équipement qui exécutera le plugin).

Installation de VMware vSphere SDK pour Perl

L’url du centre de téléchargements pour le software software VMware® requis est :

https://my.vmware.com/web/vmware/details?downloadGroup=VS-PERL-SDK65&productId=614

Installation SDK Linux

Les versions du SDK testées avec ce processus d’installation ont été les 4.1, 5.1, 6.0, 6.5

Il est toujours recommandé d’utiliser la version SDK avec sa version de software VMware correspondante. Par exemple, il est recommandé d’utiliser le software 4.1 VMware avec la version 4.1 du SDK.

Tout d’abord, décompressez le SDK avec la commande suivante :

# tar -xzvf VMware-vSphere-Perl-SDK-x.x.x-xxxxxx.i386.tar.gz

Maintenant, compilez et installez le SDK avec les commandes suivantes :

# perl Makefile.PL # make # make install

Si l’installation s’est effectuée correctement et n’a présentée aucune erreur, vous pourrez vous connecter avec le vCenter® en suivant la commande suivante :

# /usr/lib/vmware-viperl/apps/general/connect.pl \

--server <vcenter_ip> \

--username <vcenter_user> \

--password <vcenter_pass>

La réponse devrait être semblable à celle-ci :

Connection Successful Server Time : 2013-02-21T16:24:05.213672Z

Mise à jour SDK 6.5 vers d’autres versions

Si la mise à jour du SDK de VMware est en cours, nous recommandons de suivre les étapes suivantes :

- Installez les outils pour développeurs :

yum groupinstall "Developer Tools"

- Installez CPAN :

yum install perl-CPAN

- Installez quelques dépendances :

yum install openssl-devel perl-Class-MethodMaker yum install epel-release

- Décompressez les archives d’installation de VMware® SDK Perl :

tar xvzf VMware-vSphere-Perl-SDK-6.5.0-4566394.x86_64.tar.gz

- Accédez au répertoire :

cd vmware-vsphere-cli-distrib

- Lancez l’installateur :

./vmware-install.pl

Pour CentOS 8 suivez aussi les étapes suivantes :

# Enable epel repo: yum install epel-release # Enable powertools: yum install dnf-utils yum config-manager --set-enabled PowerTools # Note: For centos 8 install custom made RPMs from Artica repo: `yum install http://firefly.artica.es/centos8/perl-Crypt-SSLeay-0.73_07-1.gf.el8.x86_64.rpm` before install SDK # Install the vmware SDK -- Custom RPM 6.5: `yum install http://firefly.artica.es/centos8/VMware-vSphere-Perl-SDK-6.5.0-4566394.x86_64.rpm`

Pendant l’installation :

- Acceptez la licence.

- Indiquez ne pas utiliser les modules pré-construits pour VMware® SDK.

- Acceptez l’installation automatique des modules par le biais du système automatisé par CPAN.

- Vérifiez que tous les pré-requis ont été installés correctement.

- Indiquez le répertoire où les modules de VMware SDK Perl devront être installés.

Note: Dans certains cas, le paquet perl UUID peut générer des erreurs en s’installant dans CentrOS 7. Réalisez les étapes suivantes pour ajouter le composant :

- Installez les dépendances nécessaires pour UUID-0.03

yum install libuuid-devel perl-JSON-PP

- Téléchargez le paquet du code de http://search.cpan.org/~cfaber/UUID-0.03/UUID.pm

wget http://search.cpan.org/CPAN/authors/id/C/CF/CFABER/UUID-0.03.tar.gz

- Décompressez le fichier et accéder au répertoire

tar xvzf UUID-0.03.tar.gz cd UUID-0.03

- Générez les archives nécessaires pour la compilation du module Perl

perl Makefile.PL

- Compilez le module Perl

make

- Vous devrez recevoir une réponse semblable à

Manifying blib/man3/UUID.3pm

- Installez le nouveau module compilé

make install

Une fois les modules en attente installés, retournez exécuter le processus d’installation de VMware® SDK Perl :

./vmware-install.pl

Note : Le désinstallateur de VMware® n’efface pas complètement les bibliothèques de modules VMware précédentes.

Vérifiez que les bibliothèques ont été installées correctement sur /usr/lib/vmware-vcli/VMware/share/ avant de continuer

Suivez ces étapes manuellement :

- Vider les anciennes bibliothèques

rm -rf /usr/share/perl5/vendor_perl/VMware rm -rf /usr/share/perl5/VMware

- Ajouter les nouvelles bibliothèques VMware

cp -R /usr/lib/vmware-vcli/VMware/share/VMware /usr/share/perl5/vendor_perl/

Une fois effectué, un script peut être lancé avec le contenu suivant, pour valider l’installation de VMware SDK Perl

#!/usr/bin/perl use strict; use warnings; use VMware::VIRuntime; print "VMware SDK Version: " . $VMware::VIRuntime::VERSION . "\n";

Exécutez le script :

perl check_vmware.pl

La sortie doit être la suivante :

VMware SDK Version: 6.5.0

Si la sortie est différente, veuillez vérifier que vous avez bien suivi correctement toutes les étapes ou mettez-vous en relation avec l’assistance sur https://support.pandorafms.com/integria/ .

Les dépendances SDK pour CentOS 7 et CentOS 8 sont :

gdbm-devel glibc-devel glibc-headers kernel-headers libdb-devel libuuid-devel make openssl perl-Business-ISBN perl-Business-ISBN-Data perl-Class-Inspector perl-Class-MethodMaker perl-Convert-BinHex perl-Crypt-SSLeay perl-Digest perl-Digest-MD5 perl-Email-Date-Format perl-Encode-Locale perl-ExtUtils-Install perl-ExtUtils-MakeMaker perl-ExtUtils-Manifest perl-ExtUtils-ParseXS perl-File-Listing perl-HTML-Parser perl-HTML-Tagset perl-HTTP-Cookies perl-HTTP-Daemon perl-HTTP-Date perl-HTTP-Message perl-HTTP-Negotiate perl-IO-HTML perl-IO-SessionData perl-IO-Socket-IP perl-IO-Socket-SSL perl-JSON-PP perl-LWP-MediaTypes perl-LWP-Protocol-https perl-MIME-Lite perl-MIME-Types perl-MIME-tools perl-MailTools perl-Mozilla-CA perl-Net-HTTP perl-Net-LibIDN perl-Net-SMTP-SSL perl-Net-SSLeay perl-SOAP-Lite perl-Test-Harness perl-TimeDate perl-URI perl-WWW-RobotRules perl-XML-LibXML perl-XML-NamespaceSupport perl-XML-Parser perl-XML-SAX perl-XML-SAX-Base perl-devel perl-libwww-perl pyparsing systemtap-sdt-devel glibc glibc-common libblkid libmount libsmartcols libuuid util-linux

Pour CentOS 8 installez les RPMs perl-Crypt-SSLeay du répértoire de Artica :

yum install `http://firefly.artica.es/centos8/perl-Crypt-SSLeay-0.73_07-1.gf.el8.x86_64.rpm`

Vous pouvez intaller les dépendances extras pour plugin avec la commande suivnte :

`yum install perl-Archive-Zip perl-JSON`

Vous pouvez installer les dépendances de chiffré de mot de passe avec la commande suivante :

`yum install openssl-devel perl-Crypt-CBC perl-Digest-SHA`

Vous pouvez télécharger les RMP personnalisés de perl-Crypt-OpenSSL-AES depuis le répertoire de Ártica :

- Pour CentOS 7.

`yum install https://sourceforge.net/projects/pandora/files/Tools%20and%20dependencies%20%28All%20versions%29/RPM%20CentOS%2C%20RHEL/perl-Crypt-OpenSSL-AES-0.02-1.el7.x86_64.rpm`

- Pour CentOS 8.

`yum install https://sourceforge.net/projects/pandora/files/Tools%20and%20dependencies%20%28All%20versions%29/RPM%20CentOS%2C%20RHEL/perl-Crypt-OpenSSL-AES-0.02-1.el8.x86_64.rpm`

Installation SDK sur Windows

La version de PERL, qui est distribuée avec le vSphere SDK, ne fonctionne pas avec les bibliothèques de VMware pour PERL. Pour résoudre ce problème, suivez les étapes suivantes :

- Installez le VMware vSphere SDK.

- Installez Strawberry PERL version 5.12 de http://strawberryperl.com/releases.html.

- Copiez le répertoire :

//C:\AProgramFiles%\VMware\VMware vSphere CLI\Perl\lib\VMware//

vers

//C:\strawberry\perl\lib//.

- Désinstallez le VMware® vSphere SDK.

Configuration du plugin

Vous pouvez configurer le plugin de VMware® manuellement ou en utilisant l’extension pour console disponible, joint avec les archives téléchargeables du plugin de VMware®.

En configurant le plugin manuellement

Nous recommandons d’utiliser l’extension disponible sur votre console de Pandora FMS pour administrer les multiples configurations du plugin de VMware®.

Vous pouvez éditer manuellement le fichier de configuration. Sachez que les lignes qui commencent par '#' seront interprétées comme des commentaires.

Par défaut l'extension de VMware® découvre toutes les entités et ajoute les vérifications par défaut. Par le biais du fichier de configuration, vous pourrez configurer la supervision et choisir quelles variables vous souhaitez superviser.

Le fichier de configuration contient toute les informations nécessaires pour la supervision, groupée dans les sections suivantes :

Tous les erreurs rélatives au fichier de configuratuin sont présentés dans le journal des erreurs du serveur Pandora FMS et en outre le visualiseur d'évennements de la console Pandora FMS. Donc, vous pourrez voir s'il existe quelque erreur sur le fichier de condiguration en consultant n'importe quel de ces deux sources.

Configuration globale

La configuration générale est définie par le token Configuration et contient les paramètres suivantes :

- server

FQDN ou IP du serveur VMware® à surveiller

- user

Utilisateur avec des droits de lecture sur vCenter®

- pass

Mot de passe de l’utilisateur dans vCenter®

- datacenter

Nom du datacenter (par défaut : ha-datacenter)

- temporal

Répertoire de travail temporel, par défaut : /tmp

- logfile

Archive de log, par défaut /tmp/vmware_plugin.log

- entities_list

Archive d’entités à surveiller, par défaut /tmp/vmware_entitites_list.txt

- transfer_mode

Mode de transfert de XML à Pandora qui peut être tentacle ou local, par défaut : local :

- tentacle : Il envoi les fichiers XML au serveur Pandora FMS en utilisant le protocole Tentacle.

- local : Il copie les fichiers vers un dossier local ; l'agent doit être exécuté dans la même machine où se trouve le dossier local.

- tentacle_client

Afin d'utiliser Tentacle en tant qu'outil de tranfert, il doit être configuré en tant que client : tentacle_client.

- tentacle_ip

Adresse du serveur de Pandora FMS, par défaut : 127.0.0.1

- use_encrypted_password

Utiliser des mots de passe chiffrés (1) ou pas (0)

- tentacle_port

Port pour communications Tentacle, par défaut : 41121

- tentacle_opts

Options extra pour Tentacle à distance

- local_folder

Dans transfert local, dossier de destination pour les XML de rapport /var/spool/pandora/data_in

- pandora_url

Adresse web de la console de Pandora FMS, par défaut

http://127.0.0.1/pandora_console

- api_pass

Mot de passe de la API de la console de Pandora FMS

- api_user

Utilisateur avec accès à l’API de Pandora FMS

- api_user_pass

Mot de passe de l’utilisateur avec accès à l’API

- retry_send

Réessayer (1) o non (0) l’envoi de XML en cas d’erreur (semblable à buffer_xml)

- event_mode

Récupérer l’information (1) des évènements de VMware o non (0)

- event_pointer_file

Archive des indices auxiliaires pour des évènements VMware, par défaut /tmp/vmware_events_pointer.txt

- virtual_network_monitoring

Il active (1) ou désactive (0) la supervision de commutateurs virtuels (standard)

Encrypt passwords

Utiliser des mots de passe cryptés dans le fichier de configuration

- verbosity

Niveau de debug (recommandé : 1)

- threads

Nombre maximum de hilos à utiliser (par défaut 1, recommandé : 4)

- interval

Intervalle en secondes des agents et modules qui se généreront (ajuster conformément à la fréquence d’exécution du plugin)

- recon_interval

Intervalle en secondes après que le fichier temporaire de caché s’auto-élimine pour re-scanner l’infrastructure VMware® de nouveau.

- group

Servers Groupe de destination des agents générés par le plugin, par exemple Servers ou Workstations.

- virtual_network_monitoring

Il active (1) ou désactive (0) la supervision de commutateurs virtuels (standard)

- use_ds_alias_as_name

Il active (1) ou désactive (0) l'utilisation d'un alias en tant que nom d'agent sur des agent de stockage de données-.

Server, datacenter, user, pass et interval peuvent être modifiés depuis la console Pandora FMS.

Si vous utilisez actuellement Pandora FMS 5.0 ou une version supérieure et que vous souhaitez utiliser les extensions du plugin ou la surveillance d’évènements, vous devrez configurer correctement l’API de Pandora FMS. Pour cela, vous devrez ajouter un mot de passe à l’API et permettre l’accès aux adresses pertinentes dans la liste d’accès de l’API. Ces champs se définissent dans la configuration générale de la console de Pandora FMS.

L'utilisateur que vous utiliserez avec le mot de passe de l'API doit avoir des autorisations de lecture et écriture afin d'enregistrer les évennements. En outre rappelez-vous d'inclure les agents Datacenter dans le plan de supervision puisque les évennemens pour la Console sont créés à partir de ces agents.

Un exemple dans cette section dans le fichier de configuration pourrait être le suivant :

Configuration server 192.168.70.249 user Administrator pass S1stemas datacenter artica temporal /tmp logfile /tmp/vmware_plugin.log entities_list /tmp/vmware_entities_list.txt transfer_mode tentacle tentacle_ip 192.168.70.81 tentacle_port 41121 tentacle_opts local_folder /var/spool/pandora/data_in pandora_url http://192.168.70.81/pandora_console api_pass 1234 api_user admin api_user_pass pandora event_mode 0 event_pointer_file /tmp/vmware_events_pointer.txt

Si vous utilisez le plugin dans des systèmes MS Windows® il sera nécessaire de changer toutes les chemins des fichiers par des chemins compatibles avec Windos®.

Scan d'entités

Afin d'utiliser cette fonctionnalité dans Discovery, ajoutez la configuration souhaitée dans Extra settings.

En raison de la taille des infrastructures VMware® qui characterise les clients Enterprise, un scan général de toutes les entités disponibles dans chaque exécution pourrait déclencher des problèmes de performance.

Afin d'éviter cette situation, le plugin de supervision de VMware® dispose du fichier d'entités ( entities_list ) où la liste d'entités est stockée scannés dans la première exécution.

Tandis que le fichier existe, la supervision sera limitée aux entités indiquées dedans.

Si vous avez besoin d'un scan périodique de votre infrastructure VMware®, vous pouvez supprimer ce fichier te temps en temps (par exemple, chaque heure) en utilisant le cron du système.

Renommage d'entités

Pour utiliser cette fonctionnalité dans Discovery, ajoutez la configuration souhaitée dans Extra settings.

Le renommage d'entités se fait en utilisant le token RENAME et permet de changer le nom des entités découvertes par le plugin. En utilisant cette fonctionnalité, les agents créés dans Pandora apparaîtront avec le nouveau nom attribué. La structure de cette section est la suivante :

<nom actuel> TO <nouevau nom>

Un exemple de configuration de cette section pourrait être le suivant :

#Rename entities Rename Debian 11 TO Virtual Machine 1 RedHat 12 TO Web server ESX Workstation TO Host Work Sales

Rejet d'entités

Pour utiliser cette fonctionnalité dans Discovery, ajoutez la configuration souhaitée dans Extra settings.

Le plugin permet de fair un rejet des entités par type ou de manière individuelle, on vous explique les deux options ci-dessous.

Le rejet des types d'entités se fait en utilisant le token REJECT. Dans cette section vous pouvez écarter les entités selon leur type ; par exemple toutes les machines virtuelles ou toutes les hôtes ESX. Les valeurs possibles que cette section peut prende sont les suivants :

all_datastore

all_datacenter

all_esx

all_vm

all_ipaddresses

Une configuration de cette section qui écarte toutes les entités serait la suivante :

#Dismissed entities Reject all_datastore all_datacenter all_esx all_vm

Afin d'écarter les entités de manière individuelle, il sera nécessaire de les effacer du fichier d'entités créé par le plugin. Le plugin crée ce fichier dans la localisation indiquée dans le paramètre entities_list (par défaut /tmp/vmware_entities_list.txt). Le plugin remplit le contenu de ce fichier avec la première exécution, ou tandis qu'elle n'existe pas, en créant une liste avec toutes les entités découvertes.

Un exemple de fichier pourrait être le suivant :

Datacenter artica Datastore datastore_1 datastore2 ESX 192.168.70.252 VM Pandora FMS 4.0.3 Debian2 Debian3 Debian4 Redhat debian5 Debian6 Debian8 Debian7 Debian11 Debian10 Debian9 NSM Pandora vcenter suse11.2

Le fichier de configuration est divisé entre quelques tokens : Datacenter, Datastore, ESX et VM, où les différentes entités sont listées. Une fois le fichier de configuration créé, le plugin lira de ce fichier les entités à superviser. Pour écarter une entité vous avez seulement à l'effacer depuis ce fichier. Si, par exemple, vous n'avez pas besoin de superviser les entités : Debian2, datastore2, NSM, suse11.2 et 192.168.70.252, le fichier de configuration devrait donc être pareille à ceci :

Datacenter artica Datastore datastore_1 ESX VM Pandora FMS 4.0.3 Debian3 Debian4 Redhat debian5 Debian6 Debian8 Debian7 Debian11 Debian10 Debian9 Pandora vcenter

Cette fonctionnalité permet de faire une distribution de la charge de supervision limitant le nombre d'entités supervisées dans chaque exécution du plugin. Nous vous explicons ci-dessous plusieures techniques de distribution de charge.

La section Reject, du plugin de supervision d'environnements VMware® contient en outre l'option suivante :

all_ipaddresses

Si cette instruction est présente, l'addresse IP dans le XML ne sera pas mise à jour. Ça signifie que si vous activez cette option, le plugin/tâche de Discovery de VMware ne mettra à jour le champ ip address des agents. Cette instruction est aussi valide pour les tâches de reconnaissance du Discovery sobre VMware®.

Configuration de surveillance

Pour utiliser cette fonctionnalité sur Discovery, ajoutez la configuration souhaitée dans Extra settings

Les sections suivantes de l’archive configurent les modules créés par chaque type d’entité. Les sections utilisent les tokens Datacenter, Datastore, ESX, VM. Dans ces dernières, vous pourrez activer/désactiver les modules à surveiller. Dans l’exemple suivant, nous avons réalisé une configuration en sélectionnant les modules que nous souhaitons créer pour les ESX et les machines virtuelles :

... #ESX Modules ESX cpuUsagePercent disabled diskRead enabled diskWrite enabled #VM Modules VM diskReadLatency disabled diskWriteLatency disabled diskRate enabled ...

Chaque ligne de configuration correspond à un module. Dans l’exemple précédent, les modules seront créés avec les valeurs par défaut, mais il est possible de configurer le nom, la description et les limites pour les états d’Avertissement et Critique du module. Voici un exemple de cette configuration :

... #VM Modules VM diskReadLatency disabled diskWriteLatency disabled diskRate name = Tasa Disco; desc = Tasa Lec/Esc disco; limits_warn = 5 10; limits_crit = 0 4 ...

Les options disponibles pour la configuration des modules sont les suivantes :

- <module> disabled : le module NON se créera

- <module> enabled : le module OUI se créera (avec les valeurs par défaut).

- <module> name = <nom>; desc = <description>; limits_warn <lim_warn>; limits_crit <lim_crit» le module se créera avec le nom et la description fournis. De plus, les seuils maximaux et minimaux se définiront pour les états Avertissement et Critique.

Il est très important de prendre en compte la structure des lignes de l’archive de configuration et surtout de voir le caractère ; qui est collé au nom et à la description du module. Ces deux lignes NE SONT PAS ÉQUIVALENTES (voir les espaces avant le caractère ; ):

diskRate name = Tasa Disco; desc = Tasa Lec/Esc disco; limits_warn = 5 10; limits_crit = 0 4 diskRate name = Tasa Disco ; desc = Tasa Lec/Esc disco ; limits_warn = 5 10; limits_crit = 0 4

Les modules sont référencés par leur court nom, une abréviation équivalente et plus simple à écrire dans la ligne de commandes. La table de correspondance des noms abrégés et développés se trouve dans la section suivante.

Analysons la configuration de l’exemple précédent. Nous avons configuré le module Disk Rate qui se créera avec les valeurs suivantes :

* Nom : Tasa Disco * Description: Tasa Lec/Esc disco * Min Warning: 5 * Max Warning: 10 * Min Critical: 0 * Max Critical: 4

Certains modules se gèrent de façon dynamique, par exemple ceux relatifs aux disques ou interfaces réseau. Pour ces métriques, le plugin crée un module pour chaque élément découvert. Ces modules ont généralement des noms spéciaux sur Pandora FMS, par exemple :

Disk Free [0] Disk Free [1] Disk Free [2] ...

Dans ces cas, comme le nom a une partie dynamique, l’usage de la macro % est possible, qui sera substituée par la partie variable du nom du module. Un exemple de configuration des modules serait le suivant :

diskFree name = Disk (%s) free space; desc = Free space for disk; limits_warn = 0 0; limits_crit = 0 0

Dans ce cas, le nom du module par défaut est :

Disk Free [0]

Puis s’appellera :

Disk (0) free space

A partir de la version 5.0, il est possible de configurer des chaînes de caractères pour les limites des états Avertissement et Critique des modules. La configuration serait comme la suivante :

powerState name = état en fonctionnement; desc = état en fonctionnement VM; limits_warn = .*suspended.*; limits_crit = .*poweredOff.*

Il est possible de configurer des expressions régulières pour jouir d’une flexibilité plus grande pour établir les limites.

En configurant la surveillance VMware

Suivez les étapes décrites sur : Discovery pour configurer la surveillance de votre infrastructure VMware grâce à Discovery.

Exécution du plugin VMware

Pour vérifier le fonctionnement de votre configuration, vous pouvez exécuter :

perl /usr/share/pandora_server/util/plugin/vmware-plugin.pl /usr/share/pandora_server/util/plugin/vmware-plugin.conf

Note :

- Sur VMware SDK 6.5.0. Si vous recevez la sortie suivante pendant l’exécution du plugin :

Server version unavailable at 'https://your_vmwre_fqdn:443/sdk/vimService.wsdl' at /usr/local/lib64/perl5/VMware/VICommon.pm line 734.

La solution est apporté en ajustant les versions des bibliothèques LWP de Perl :

cpan install GAAS/libwww-perl-5.837.tar.gz

Nous recommandons vivement d’utiliser Discovery Applications VMware pour surveiller votre infrastructure.

Ainsi, vous pouvez choisir différentes façons d’automatiser l’exécution du plugin de surveillance VMware :

Programmer l’exécution depuis l’agent de Pandora FMS

Utiliser l’agent de Pandora FMS

Copier vmware-plugin.{pl,conf} de sorte à ce qu’il soit accessible par l’agent de Pandora FMS :

sudo cp \

/usr/share/pandora_server/util/plugin/vmware-plugin.{pl,conf} \

/etc/pandora/plugins/

Pour créer un fichier de configuration

vmware-plugin-events.conf

copiez vmware-plugin.conf et en modifiez manuellement event_mode à 1.

A présent, il faut ajouter un nouveau module de type plugin à l’archive de configuration de l’agent, avec la ligne suivante :

module_plugin perl \ /etc/pandora/plugins/vmware-plugin.pl \ /etc/pandora/plugins/vmware-plugin.conf

Si vous souhaitez, en plus, la copie des évènements, vous devez créer un autre module plugin avec une archive de configuration différente qui permette la copie d’évènement. La formulation serait la suivante :

module_plugin perl \ /etc/pandora/plugins/vmware-plugin.pl \ /etc/pandora/plugins/vmware-plugin-events.conf

Dans des systèmes Windows, il faudra indiquer l’interprète utilisé. La commande serait :

module_plugin perl "C:\Program Files\pandora_agent\util\vmware-plugin.pl" "C:\Program Files\pandora_agent\util\vmware-plugin.conf"

Dans les sections suivantes, les paramètres de l’archive de configuration du plugin sont expliqués en détails dans les sections suivantes.

Le plugin de VMware peut prendre beaucoup de temps pour l’exécution en raison du nombre d’entités inscrites.

Nous recommandons la surveillance par Discovery pour que ce soit DiscoveryServer lui même qui se charge de ces tâches.

Si vous décidez de le surveiller d’une autre façon, il se pourrait qu’il soit nécessaire de distribuer la charge entre plusieurs agents software de Pandora FMS ou de choisir un autre mode de programmation. Toute l’information concernant cela se trouve dans les sections suivantes.

Programmer l’exécution depuis le cron du système

Vous pouvez programmer l’exécution du plugin depuis le propre cron du système. Sachez que la valeur d’intervalle des éléments générés (interval dans la configuration) et la fréquence d’exécution doivent être cohérents :

# Input to add to crontab, set a range of 600 to use this setting/10 * * * * root perl /usr/share/pandora_server/util/plugin/vmware-plugin.pl /usr/share/pandora_server/util/plugin/vmware-plugin.conf

L'exemple précédente montre la ligne à ajouter à crontab. Configurez un intervalle de 600 pour utiliser cette configuration.

Surveillance de l’architecture virtuelle VMware

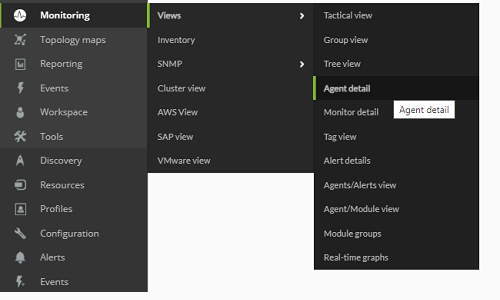

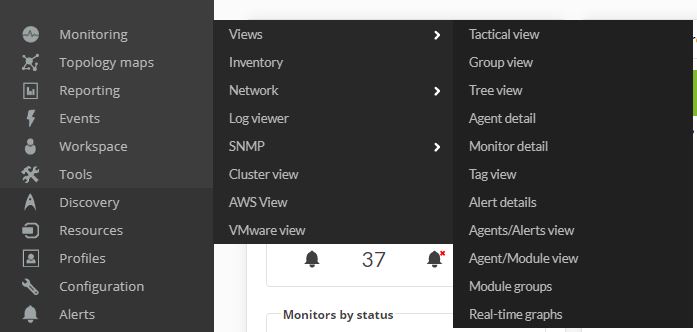

Pour voir le résultat de l’exécution du plugin, il suffit d’accéder au sous-menu Agent Detail, dans le menu Views.

Dans cette vue, les agents créés par le plugin apparaîtront avec les autres agents de Pandora FMS.

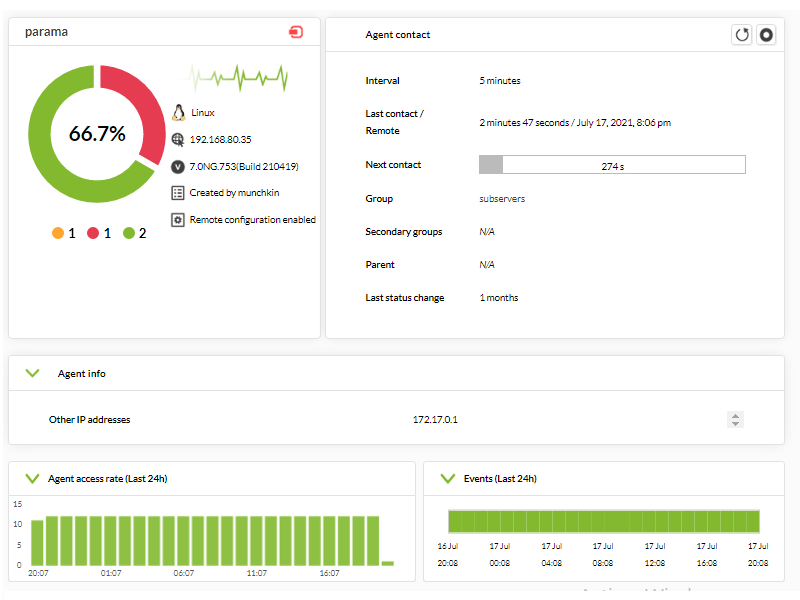

Si nous appuyons sur le nom d’un agent, nous verrons la vue de l’agent de Pandora FMS, où les modules surveillés apparaîtront par le plugin VMware.

Par défaut, le plugin déploie une surveillance basique pour chacun des éléments VMware. La configuration par défaut pour les différentes entités est la suivante :

Surveillance par défaut pour Datacenter

- Ping

- Check 443 port

Surveillance par défaut pour Datastore

- Capacity

- Free Space

- Disk Overallocation

- Free Space Bytes

Surveillance par défaut pour ESXi

- CPU Usage

- Memory Usage

- Data received

- Data transmitted

- Disk Read Latency

- Disk Write Latency

- Host Alive

- Disk Rate

- Net Usage

Surveillance par défaut pour machines virtuelles

- CPU Usage

- Memory Usage

- Tools Running Status

- Host Alive

- Disk Free

- Disk Read Latency

- Disk Write Latency

- Data received

- Data transmitted

- Net Usage

La section suivante détaille tous les modules disponibles et l’information que rapporte chaque module.

Modules des agents de l’architecture virtuelle VMware

Quelques modules pourraient ne pas être disponibles, tout dépend de la version de VMware et de la configuration de l’environnement. Dans les tables suivantes, les différents modules disponibles ainsi que leurs caractéristiques de disponibilité y sont décrits.

Le plugin permet de configurer Performance Counters, personnalisés pour les hosts ESX et machines virtuelles. Vous pourrez voir comment procéder dans la section qui détaille le contenu de l’archive de configuration.

Modules pour agents de type Datacenter

| Module | Description | Version API | Disponibilité |

|---|---|---|---|

| Ping | Test ping sur la machine qui supporte le vCenter | Tous | Toujours |

| Check 443 port | Test sur le port 443 de la machine qui supporte le vCenter | Tous | Toujours |

Modules pour agents de type Datastore

| Module | Description | Version API | Disponibilité |

|---|---|---|---|

| Capacity | Capacité maximale du Datastore en bytes | Tous | Toujours |

| Free Space | Pourcentage d’espace libre du Datastore | Tous | Toujours |

| Disk Overallocation | Pourcentage de sur-assignation du disque | ≥v4.0 | Toujours |

| Free Space Bytes | Quantité d’espace libre en bytes | Touss | Toujours |

Modules pour agents du types host ESXi

| Modules | Description | Version API | Disponibilité |

|---|---|---|---|

| Boot Time | Dernière date à laquelle s’est allumé l’host | Tous | Toujours |

| CPU Info [x] | Information générale de CPU (un module se crée par CPU de ESXi) | Tous | Si connecté |

| Memory Size | Quantité totale de mémoire physique de l’host en Bytes | Tous | Si connecté |

| Overall CPU Usage | Somme de l’usage de tous les CPUs en Mhz | Tous | Si connecté |

| Overall Memory Usage | Overall Memory Usage of VMware Hosts | Tous | Si connecté |

| Power State | Etat de l’énergie de l’host | ≥v2.5 | Toujours |

| SSL Thumbprint | Empreinte SSL de l’host | ≥v4.0 | Si configuré |

| Uptime | Uptime de l’host en secondes | ≥v4.1 | Si connecté |

| VNIC Info [x] | Information sur les interfaces de réseaux virtuelles de l’host | Tous | Si connecté et configuré |

| Host Alive | Module qui vaut 1 si le ESX est connecté et 0 dans le cas contraire. | Tous | Toujours |

| Connection State | Etat de la connection de l’host | Tous | Toujours |

| Disk Read | Taux de Kbps lus du disque | Tous | Niveau stats ≥2 |

| Disk Write | Taux de Kbps écrits du disque | Tous | Niveau stats ≥2 |

| Disk Read Latency | Latence de lecture du disque en millisecondes | Tous | Niveau stats ≥2 |

| Disk Write Latency | Latence d’écriture du disque en millisecondes | Tous | Niveau stats ≥2 |

| Data received | Taux de Kbps reçu de l’host | Tous | Niveau stats ≥2 |

| Data transmitted | Taux de Kbps envoyés de l’host | Tous | Niveau stats ≥2 |

| Packages Received | Nombre de paquet reçus dans l’intervalle | Tous | Niveau stats ≥2 |

| Packages Transmitted | Nombre de paquets envoyés dans l’intervalle | Tous | Niveau stats ≥2 |

| CPU Usage | Pourcentage d’utilisation de CPU | Tous | Niveau stats ≥2 |

| Memory Usage | Pourcentage d’utilisation de la mémoire RAM | Toutes | Niveau stats ≥2 |

| Net Usage | Données de réseau reçues et envoyées de toutes les NICs | Tous | Niveau stats ≥2 |

| Disk Rate | Taux I/O ajouté dans KB/sec | Tous | Niveau stats ≥2 |

| Max. Disk Latency | Latence maximale de tous les disques | Tous | Niveau stats ≥2 |

| HA Status | Etat HA de l’host | ≥v5.0 | Si configuré |

| Sensor* | Etat des capteurs de hardware (un module par capteur) | Tous | ESXi >= 3.5 |

Modules pour agents de type machine virtuelle

Ces modules fournissent l’information depuis le point de vue de l’architecture VMware. Si vous désirez surveiller d’autres paramètres relatifs à la machine virtuelle, il faudrait prendre d’autres options en considération, comme la Surveillance avec agents logiciels ou la Surveillance virtuelle.

| Module | Description | Version API | Disponibilité |

|---|---|---|---|

| Boot Time | Dernière date à laquelle s’est allumée la machine virtuelle | Tous | Si connecté |

| Connection State | Etat de la connexion | Tous | Toujours |

| Consumed Overhead Memory | Quantité de mémoire utilisée par la machine virtuelle en MB | ≥v4.0 | Si configuré |

| CPU Allocation | Information sur les ressources assignées au CPU de la machine virtuelle | Tous | Si configuré |

| Disk Free [x] | Pourcentage libre du disque de la machine virtuelle. (Il y aura un module pour chaque disque qui contient la machine virtuelle) | Tous | Si configuré |

| Guest State | Mode d’opération du système d'exploitation hôte | Tous | Si configuré |

| Host Info | Information sur l’host VMware | Tous | Si configuré |

| Host Alive | Module qui vaut 1 si la machine virtuelle est en cours d’exécution et 0 dans le cas contraire. | Tous | Toujours |

| Host Memory Usage | Mémoire utilisée par la machine virtuelle en MB | Tous | Si connecté |

| Host Name | Nom associé à l’host associé | Tous | Si configuré |

| IP Address [x] | Adresse IP de la machine. (Il en apparaîtra une par interface de réseau disponible) | ≥v4.1 | Si configuré |

| MAC Address [x] | Adresse MAC de la machine. (Il en apparaîtra une par interface de réseau disponible.) | Tous | Si configuré |

| Max CPU Usage | Limite supérieure d’utilisation de la CPU de la machine virtuelle | Tous | Si connecté |

| Max Memory Usage | Limite supérieure d’utilisation de la mémoire RAM de la machine virtuelle | Tous | Si connecté |

| Memory Allocation | Limite des ressources pour la mémoire | Tous | Si configuré |

| Memory Overhead | Quantité de mémoire utilisée par la machine virtuelle au-delà des besoins du système d'exploitation hôte en Bytes | Tous | Si configuré |

| Overall CPU Demand | Statistiques basiques sur le rendement de la CPU en Mhz | ≥v4.0 | Si connecté |

| Overall CPU Usage | Statistiques basiques sur l’usage du CPU en Mhz | Tous | Si connecté |

| Power State | Etat actuel de la machine virtuelle | Tous | Toujours |

| Private Memory | Quantité de mémoire en MB accordée exclusivement à la machine virtuelle sans partage | ≥v4.0 | Si connecté |

| Shared Memory | Quantité de mémoire en MB accordée à la machine virtuelle de la mémoire partagée | ≥v4.0 | Si connecté |

| Tools Running Status | Etat actuel de l’exécution de VMware Tools installé dans le système d'exploitation hôte | ≥v4.0 | Si configuré |

| Trigger Alarm State | Etat des alarmes de VMware | Toutes | Si configuré |

| Uptime Seconds | Uptime de la machine virtuelle en secondes | ≥v4.1 | Si connecté |

| Virtual Image Path | Chemin d’accès de l’archive de configuration de la machine virtuelle (.vmx) | Tous | Toujours |

| Disk Read | Taux de Kbps lus par le disque | Tous | Niveau stats ≥2 |

| Disk Write | Taux de Kbps écrits par le disque | Tous | Niveau stats ≥2 |

| Disk Read Latency | Latence de lecture du disque en millisecondes | Tous | Niveau stats ≥2 |

| Disk Write Latency | Latence d’écriture du disque en millisecondes | Tous | Niveau stats ≥2 |

| Data received | Taux de Kbps reçus de l’host | Tous | Niveau stats ≥2 |

| Data transmitted | Taux de Kbps envoyés de l’host | Tous | Niveau stats ≥2 |

| Packages Received | Nombre de paquets reçus dans l’intervalle | Tous | Niveau stats ≥2 |

| Packages Transmitted | Nombre de paquets envoyés dans l’intervalle | Tous | Niveau stats ≥2 |

| CPU Usage | Pourcentage d’utilisation de CPU | Tous | Niveau stats ≥2 |

| Memory Usage | Pourcentage d’utilisation de la mémoire RAM | Tous | Niveau stats ≥2 |

| Net Usage | Données de réseau reçues et envoyées des NICs | Tous | Niveau stats ≥2 |

| Disk Rate | Taux I/O ajouté en KB/sec | Tous | Niveau stats ≥2 |

| Max. Disk Latency | Latence maximale de tous les disques | Tous | Niveau stats ≥2 |

| HeartBeat | Nombre de heartbeats de la machine virtuelle | Tous | Niveau stats ≥2 |

| CPU Ready | Pourcentage de temps pendant lequel la machine est prête mais pas en place pour s’exécuter dans le CPU physique | Tous | Niveau stats ≥2 |

| Number Snapshots | Nombre de snapshots pour la machine virtuelle (ce module peut affecter le rendement de la surveillance'. C’est pour cela qu’il est recommandé de l’exécuter avec une haute valeur d’intervalle. Par exemple, chaque heure.) | Tous | Si configuré |

| HA Status | Etat HA pour la machine virtuelle | ≥v5.0 | Si configuré |

Quelques modules nécessitent d’avoir installés les VMware tools

Surveillance d’évènements VMware

Cette fonctionnalité réalise une copie des évènements présents dans le vCenter de VMware à la liste des évènements de Pandora FMS.

Ces évènements sont parvenus à faire partie du flux d’évènements normaux de Pandora FMS et restent associés de façon automatique à l’agent qui représente le vCenter auquel ils proviennent (si l’agent existe au moment de la création de l’évènement).

Dans le processus de dump des évènements, l’information et la sévérité que VMware indique lors de la création de l’évènement sont respectées, de telle sorte que les évènements avec un niveau de sévérité critique, avertissant, ou informatif conserveront ces niveaux dans Pandora FMS. L’image suivante montre un exemple d’information détaillée d’un évènement de dump de VMware à Pandora FMS.

Avec tous les évènements présents sur Pandora FMS, vous pourrez réaliser toutes les actions disponibles pour la gestion des évènements, comme par exemple la création d’alertes, la configuration de filtres, l’ouverture d’incidences, etc.

Gestion et visualisation de l’architecture virtuelle VMware

Accompagné du plugin VMware, deux extensions sont distribuées, VMware Manager® et VMware View®. VMware View permet de visualiser tous les composants de l’architecture VMware® de façon pratique. De plus, avec VMware Manager®, vous pourrez gérer des machines virtuelles en arrêtant, en démarrant, en réinitialisant ou en suspendant son activité depuis la console de Pandora FMS.

En utilisant VMware View

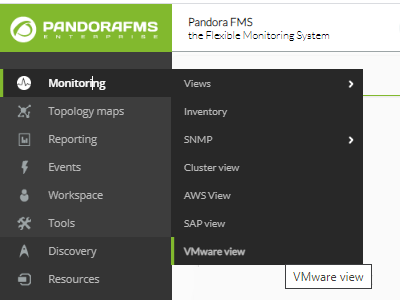

Pour commencer à utiliser le viseur des architectures VMware®, allez vers Monitoring > VMware view.

Si vous n'avez pas aucun appareil à superviser ou vous n'avez pas configuré l'API des vCenter® et ESXi VMware® vous obtiendrez quelque chose de pareille à l'image suivante :

Si le plugin se trouve en état opératif, vous recevrez le message suivant (cliquez sur Show) :

L’extension VMware vous montrera une carte semblable à celle ci-dessous avec toute l’architecture VMware®.

La carte contient les éléments de l’architecture VMware (machines virtuelles, ESX, Datastores et Datacenters) avec différents icônes qui les identifient, comme l’état des agents de Pandora FMS qui représentent chaque élément. De plus, la relation qui existe est montrée entre machines virtuelles, ESX et Datacenter. De cette façon, l’état de l’architecture VMware® peut se voir en un coup d’oeil.

Cette extension a des options qui aident à améliorer la visualisation de l’architecture en cachant des éléments, en augmentant la taille des lettres et en permettant de faire un zoom pour pouvoir voir les éléments de plus près.

En utilisant les options précédentes, nous ne montrerons que ceux de Datacenter et de ESX.

VMware View Dashboards

Pour des versions de Pandora FMS 5.0 ou plus, VMware View apporte deux vues supplémentaires en plus de la vue de carte topologique de l’architecture virtuelle. Les nouveaux tabs permettent d’interchanger entre les différentes vues de la VMware View.

La première vue est un dashboard général, sur lequel vous pourrez jeter un coup d’oeil sur l’état général de l’architecture virtuelle en nombres, c’est-à-dire, combien de machines virtuelles, host ESXi ou datastores ont des problèmes. De plus, vous pourrez voir des paramètres de performance généraux grâce aux graphiques qui montrent les 5 machines virtuelles qui consomment le plus de mémoire, de CPU, de disque et de réseau sur l’ensemble de l’architecture virtuelle.

La seconde vue permet de voir les paramètres de performance de chaque host ESX. Dans cette vue, vous pourrez choisir un host ESX qui sera chargé du tableau de bord sur lequel se présentera l’état de l’host et des machines virtuelles, comme des métriques de performance relatives à l’utilisation de CPU, de mémoire, de disque et de réseau de l’host ESXi. De plus, cette vue permet aussi de voir des graphiques montrant les machines virtuelles qui consomment le plus de ressources (CPU, mémoire, disque et réseau) de l’host sélectionné.

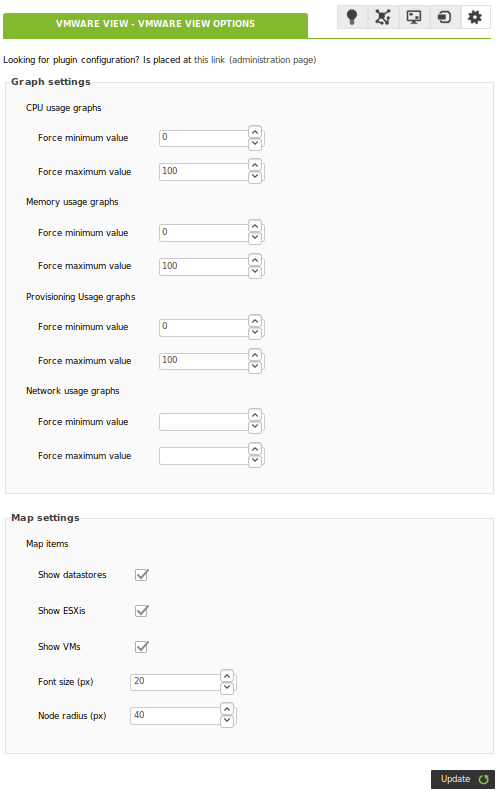

VMware View Options Tab

L’extension de VMWare est incluse avec Pandora FMS Console Enterprise. Elle dispose d’un panneau de configuration sur lequel il est possible d’y établir des dashboards et des cartes :

- Vous pourrez ajuster les seuils de vue (minimum et maximum) des graphiques des dashboards.

- Vous pourrez ajuster la configuration de la vue de la carte par défaut.

- Il contient un lien au système de gestion des configurations.

Accessible dans l’onglet des options du VMWare View :

En utilisant le VMware Manager depuis les agents

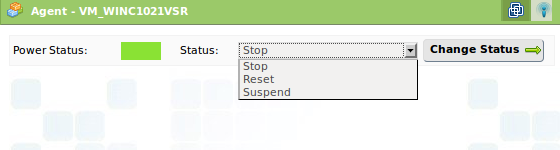

Pour utiliser l’extension VMware® Manager, il faut aller sur la vue d’opération d’un agent qui correspond à une machine virtuelle dans l’architecture VMware. Dans cette vue, vous pourrez voir un icône avec le symbole de VMware qui correspond à l’extension.

L’extension VMware Manager permet de gérer des machines virtuelles depuis la console de Pandora FMS. L’extension montre l’état actuel de la machine virtuelle avec un code de couleurs :

- Vert = allumée (machine virtuelle en exécution).

- Orange = en veille (machine virtuelle dont l'exécution est en pause)

- Gris = arrêtée (la machine virtuelle n'est pas en exécution).

De plus, les états disponibles sont montrés dans un menu et permettent de changer l’état de la machine virtuelle en le sélectionnant, en cliquant sur Change Status.

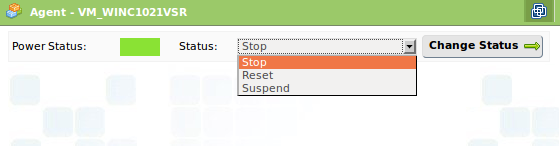

En sélectionnant l’état Stop et cliquant Change status :

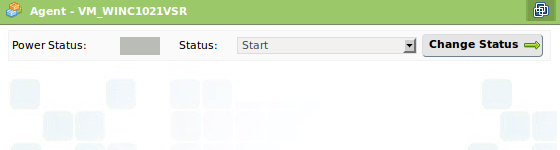

Cela provoquerait l’arrêt de la machine et la vue de l’extension VMware Manage changerait en montrant que la machine est désormais arrêtée, comme on peut le voir sur l’image suivante :

Cette extension requiert l’installation du SDK de VMware® pour Perl dans la même machine qui supporte la console de Pandora FMS. Sans ce pré-requis, l’extension ne fonctionnera pas.

Si vous avez configuré la surveillance en utilisant RENAME, cet avantage ne fonctionnera pas contre les objectifs renommés.

Métriques de performance personnalisées

Pour utiliser cette fonctionnalité sur Discovery, ajoutez la configuration souhaitée dans Extra settings

Dans cette section, vous pouvez configurer de nouveaux modules relatifs à Performance Counters pour les machines virtuelles et les ESX. Pour configurer un nouveau module de rendement, il faudra utiliser la structure suivante :

custom_performance type = mem; metric = swapinRate; module_type = generic_data; name = Swap In Rate; desc = Swap In Rate for host; limits_warn = 0 0; limits_crit = 0 0

Les paramètres à configurer sont :

- type : type de métrique à surveiller. Les types de métrique sont :

- cpu : CPU

- mem ': Memory

- disk : Disk

- net : Network

- sys : System

- metric : métrique à surveiller (Plus loin dans le document, il vous sera indiqué comment voir les métriques disponibles).

- module_type : type de module de Pandora FMS (par exemple : generic_data).

- name : nom du module.

- desc: description du module.

- limits_warn: limites par l’état d’Avertissement.

- limits_crit: limites pour l’état Critique.

Vous pourrez consulter les métriques disponibles pour chaque type, dans l’aparté Performance de chaque entité. Cette vue se trouve dans le vCenter et montre les métriques de rendement qui peuvent être surveillées avec le plugin VMware. Par exemple, l’image suivante montre la vue Performance pour un host ESX.

Pour voir la liste liste complète de toutes les métriques selon leur type, vous devrez cliquer sur le bouton “Advanced” puis sur le bouton “Char option”. Vous verrez une liste avec tous les types de métriques et celles respectives à chaque types seront dans une fenêtre comme le montre l’image suivante.

Pour chaque type de métrique, une série de compteurs apparaîtra, représentant les variables que nous pourrons surveiller avec Pandora FMS. Pour surveiller une variable, il faut son “Internal Name”. De plus, nous devrons nous assurer que le niveau de statistiques, configuré dans le vCenter, permette de montrer la variable que nous recherchons, en le comparant avec le champs “Collection Level” de la métrique.

Si, par exemple, nous souhaitons voir l’utilisation de CPU d’un host ESX, nous chercherons les variables type “cpu” pour un ESX et parmi celles disponibles, nous choisirons “utilization”. La ligne que nous devrons ajouter à l’archive de configuration, dans ce cas-ci dans la section ESX, sera la suivante :

custom_performance type = cpu; metric = utilization; module_type = generic_data; name = CPU Utilization; desc = CPU Utilization for ESX; limits_warn = 0 0; limits_crit = 0 0

Surveillance de plusieurs Datacenter avec un même agent

Chaque module plugin configuré dans l’agent surveille un datacenter, c’est pourquoi si on désire surveiller plusieurs datacenter avec un même agent software de Pandora FMS, il faudra prendre en compte les considérations suivantes :

- Il faut ajouter un

module_pluginpour chaque datacenter à surveiller, par exemple :

module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter1.conf module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter2.conf

- Dans chaque archive de configuration, il faudrait changer les paramètres : logfile, entities_list, event_pointer_file. Les archives de configuration resteraient comme les suivantes :

vmware-plugin-datacenter1.conf

... logfile /tmp/vmware_plugin_datacenter1.log entities_list /tmp/vmware_entities_list_datacenter1.txt event_pointer_file /tmp/vmware_events_pointer_datacenter1.txt ...

vmware-plugin-datacenter2.conf

... logfile /tmp/vmware_plugin_datacenter2.log entities_list /tmp/vmware_entities_list_datacenter2.txt event_pointer_file /tmp/vmware_events_pointer_datacenter2.txt ...

- Si, en plus, vous souhaitez réaliser la copie des évènements, vous devrez avoir deux modules plugin en plus, avec les archives respectives de configuration et en activant le flag

event_mode. La configuration des module_plugin serait comme la suivante :

module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter1.conf module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter1-events.conf module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter2.conf module_plugin /etc/pandora/plugins/vmware-plugin.pl /etc/pandora/plugins/vmware-plugin-datacenter2-events.conf

Diviser la charge de la surveillance entre plusieurs serveurs de Pandora

Les options de l’archive de configuration du plugin permettent de distribuer facilement la charge de surveillance entre plusieurs serveurs de Pandora FMS. Par exemple, supposons que nous ayons la structure suivante dans notre environnement de virtualisation :

DC

|

|- Datastore_1

|- DataStore_2

|

|- ESX_1

|- mv1.1

|- mv1.2

|- mv1.3

|- ESX_2

|- mv2.1

|- mv2.2

|- mv2.3

Dans notre environnement, nous disposons de deux serveurs de Pandora FMS pour réaliser la surveillance. Une manière simple de diviser la charge serait de surveiller le Datacenter, les Datastores et les ESX dans le premier serveur et toutes les machines virtuelles dans le second. Les archives de configuration du plugin seraient les suivantes :

Serveur 1 :

Reject all_vm

Serveur 2 :

Reject all_datacenter all_datastore all_esx

Le serveur 1 surveille tout sauf les machines virtuelles et le Serveur 2 surveille les machines virtuelles.

Une autre façon de distribuer la charge serait de diviser la surveillance par ESX : le premier serveur de Pandora FMS surveillerait tout ce qui est relatif au premier serveur ESX et le second, tout ce qui appartiendrait au second serveur ESX. Grâce à cela, nous diviserons l’archive entities_list.txt en deux archives et nous configurerons deux exécutions du plugin dans différents agents. Les archives entities_list.txt seraient telles que :

Serveur 1 :

Datacenter DC Datastore Datastore_1 ESX ESX_1 VM mv1.1 mv1.2 mv1.3

Le Serveur 1 ignore tout ce qui est lié au second groupe d’entités VMware, c’est pourquoi il se charge de surveiller que la moitié de l’environnement.

Serveur 2 :

Datastore DataStore_2 ESX ESX_2 VM mv2.1 mv2.2 mv2.3

Le Serveur 2 ignore tout ce qui est lié au premier groupe d’entités VMware en plus du Datacenter, puisque ce dernier est surveillé par le Serveur 1.

La configuration des entités exclues est très flexible et permet de diviser la charge qui attribue quelques entitées à chaque agent de Pandora FMS.

Exemples d’archive configuration

Archive avec tous les modules désactivés

#These lines are comments #Datacenter Modules Datacenter ping disabled check443 disabled #Datastore Modules Datastore capacity disabled freeSpace disabled overallocation disabled freeSpaceBytes disabled #ESX Modules ESX bootTime disabled cpuInfo disabled memorySize disabled overallCpuUsage disabled overallMemoryUsage disabled powerState disabled sslThumbprint disabled uptime disabled vnicInfo disabled hostAlive disabled connectionState disabled diskRead disabled diskWrite disabled diskReadLatency disabled diskWriteLatency disabled netReceived disabled netTransmitted disabled netPkgRx disabled netPkgTx disabled cpuUsagePercent disabled memoryUsagePercent disabled netUsage disabled diskRate disabled maxDiskLatency disabled haStatus disabled #VM Modules VM bootTime disabled connectionState disabled consumedOverheadMemory disabled cpuAllocation disabled diskFree disabled guestState disabled host disabled hostAlive disabled hostMemoryUsage disabled hostName disabled ipAddress disabled macAddress disabled maxCpuUsage disabled maxMemoryUsage disabled memoryAllocation disabled memoryOverhead disabled overallCpuDemand disabled overallCpuUsage disabled powerState disabled privateMemory disabled sharedMemory disabled toolsRunningStatus disabled triggeredAlarmState disabled virtualImagePath disabled uptimeSeconds disabled diskRead disabled diskWrite disabled diskReadLatency disabled diskWriteLatency disabled netReceived disabled netTransmitted disabled netPkgRx disabled netPkgTx disabled cpuUsagePercent disabled memoryUsagePercent disabled netUsage disabled diskRate disabled maxDiskLatency disabled heartbeat disabled cpuReady disabled snapshotCounter disabled

Table de correspondance des noms courts

Datacenter

| Nom délivré | Nom court |

|---|---|

| Ping | ping |

| Check 443 port | check443 |

Datastores

| Nom délivré | Nom court |

|---|---|

| Capacity | capacity |

| Free Space | freeSpace |

| Disk Overallocation | overallocation |

| Free Space Bytes | freeSpaceBytes |

ESX

| Nom délivré | Nom court |

|---|---|

| Boot Time | bootTime |

| CPU Info | cpuInfo |

| Memory Size | memorySize |

| Overall CPU Usage | overallCpuUsage |

| Overall Memory Usage | overallMemoryUsage |

| Power State | powerState |

| SSL Thumbprint | sslThumbprint |

| Uptime | uptime |

| VNIC Info | vnicInfo |

| Host Alive | hostAlive |

| Connection State | connectionState |

| Disk Read | diskRead |

| Disk Write | diskWrite |

| Disk Read Latency | diskReadLatency |

| Disk Write Latency | diskWriteLatency |

| Data received | netReceived |

| Data transmitted | netTransmitted |

| Packages Received | netPkgRx |

| Packages Transmitted | netPkgTx |

| CPU Usage | cpuUsagePercent |

| Memory Usage | memoryUsagePercent |

| Net Usage | netUsage |

| Disk Rate | diskRate |

| Max Disk Latency | maxDiskLatency |

| HA Status | haStatus |

| Sensor* | systemHealthInfo |

Machines Virtuelles

| Nom délivré | Nom court |

|---|---|

| Boot Time | bootTime |

| Connection State | connectionState |

| Consumed Overhead Memory | consumedOverheadMemory |

| CPU Allocation | cpuAllocation |

| Disk Free | diskFree |

| Guest State | guestState |

| Host Info | host |

| Host Alive | hostAlive |

| Host Memory Usage | hostMemoryUsage |

| Host Name | hostName |

| IP Address | ipAddress |

| MAC Address | macAddress |

| Max CPU Usage | maxCpuUsage |

| Max Memory Usage | maxMemoryUsage |

| Memory Allocation | memoryAllocation |

| Memory Overhead | memoryOverhead |

| Overall CPU Demand | overallCpuDemand |

| Overall CPU Usage | overallCpuUsage |

| Power State | powerState |

| Private Memory | privateMemory |

| Shared Memory | sharedMemory |

| Tools Running Status | toolsRunningStatus |

| Trigger Alarm State | triggeredAlarmState |

| Uptime Seconds | uptimeSeconds |

| Virtual Image Path | virtualImagePath |

| Disk Read | diskRead |

| Disk Write | diskWrite |

| Disk Read Latency | diskReadLatency |

| Disk Write Latency | diskWriteLatency |

| Data received | netReceived |

| Data transmitted | netTransmitted |

| Packages Received | netPkgRx |

| Packages Transmitted | netPkgTx |

| CPU Usage | cpuUsagePercent |

| Memory Usage | memoryUsagePercent |

| Net Usage | netUsage |

| Disk Rate | diskRate |

| Max Disk Latency | maxDiskLatency |

| HeartBeat | heartbeat |

| CPU Ready | cpuReady |

| Number Snapshots | snapshotCounter |

| HA Status | haStatus |

Table d’évènements

Cette liste d’évènements permet de faciliter la tâche de configuration des alertes des évèenments sur Pandora FMS. Pour obtenir une référence complète et mise à jour de tous les évènements possibles, vous devrez consulter la documentation que VMware possède à ce propos.

| Evènement | Sévérité | Type d’évènement | Groupe | |

|---|---|---|---|---|

| An account was created on host {host.name} | Informational | System | All | |

| Account {account} was removed on host {host.name} | Informational | System | All | |

| An account was updated on host {host.name} | Informational | System | All | |

| The default password for the root user on the host {host.name} has not been changed | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} triggered an action | Informational | System | All | |

| Created alarm '{alarm.name}' on {entity.name} | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} sent email to {to} | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} cannot send email to {to} | Critical | System | All | |

| Reconfigured alarm '{alarm.name}' on {entity.name} | Informational | System | All | |

| Removed alarm '{alarm.name}' on {entity.name} | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} ran script {script} | Informational | System | All | |

| Alarm '{alarm.name}' on {entity.name} did not complete script: {reason.msg} | Critical | System | All | |

| Alarm '{alarm.name}': an SNMP trap for entity {entity.name} was sent | Informational | System | All | |

| Alarm '{alarm.name}' on entity {entity.name} did not send SNMP trap: {reason.msg} | Critical | System | All | |

| Alarm '{alarm.name}' on {entity.name} changed from {from.@enum.ManagedEntity.Status} to {to.@enum.ManagedEntity.Status} | Informational | System | All | |

| All running virtual machines are licensed | Informational | System | All | |

| User cannot logon since the user is already logged on | Informational | System | All | |

| Cannot login {userName}@{ipAddress} | Critical | System | All | |

| The operation performed on host {host.name} in {datacenter.name} was canceled | Informational | System | All | |

| Changed ownership of file name {filename} from {oldOwner} to {newOwner} on {host.name} in {datacenter.name}. | Informational | System | All | |

| Cannot change ownership of file name {filename} from {owner} to {attemptedOwner} on {host.name} in {datacenter.name}. | Critical | System | All | |

| Checked cluster for compliance | Informational | System | All | |

| Created cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| Removed cluster {computeResource.name} in datacenter {datacenter.name} | Informational | System | All | |

| Insufficient capacity in cluster {computeResource.name} to satisfy resource configuration in {datacenter.name} | Critical | System | All | |

| Reconfigured cluster {computeResource.name} in datacenter {datacenter.name} | Informational | System | All | |

| Configuration status on cluster {computeResource.name} changed from {oldStatus.@enum.ManagedEntity.Status} to {newStatus.@enum.ManagedEntity.Status} in {datacenter.name} | Informational | System | All | |

| Created new custom field definition {name} | Informational | System | All | |

| Removed field definition {name} | Informational | System | All | |

| Renamed field definition from {name} to {newName} | Informational | System | All | |

| Changed custom field {name} on {entity.name} in {datacenter.name} to {value} | Informational | System | All | |

| Cannot complete customization of VM {vm.name}. See customization log at {logLocation} on the guest OS for details. | Informational | System | All | |

| An error occurred while setting up Linux identity. See log file '{logLocation}' on guest OS for details. | Critical | System | All | |

| An error occurred while setting up network properties of the guest OS. See the log file {logLocation} in the guest OS for details. | Critical | System | All | |

| Started customization of VM {vm.name}. Customization log located at {logLocation} in the guest OS. | Informational | System | All | |

| Customization of VM {vm.name} succeeded. Customization log located at {logLocation} in the guest OS. | Informational | System | All | |

| The version of Sysprep {sysprepVersion} provided for customizing VM {vm.name} does not match the version of guest OS {systemVersion}. See the log file {logLocation} in the guest OS for more information. | Critical | System | All | |

| An error occurred while customizing VM {vm.name}. For details reference the log file {logLocation} in the guest OS. | Critical | System | All | |

| dvPort group {net.name} in {datacenter.name} was added to switch {dvs.name}. | Informational | System | All | |

| dvPort group {net.name} in {datacenter.name} was deleted. | Informational | System | All | |

| Informational | System | All | ||

| dvPort group {net.name} in {datacenter.name} was reconfigured. | Informational | System | All | |

| dvPort group {oldName} in {datacenter.name} was renamed to {newName} | Informational | System | All | |

| HA admission control disabled on cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| HA admission control enabled on cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| Re-established contact with a primary host in this HA cluster | Informational | System | All | |

| Unable to contact a primary HA agent in cluster {computeResource.name} in {datacenter.name} | Critical | System | All | |

| All hosts in the HA cluster {computeResource.name} in {datacenter.name} were isolated from the network. Check the network configuration for proper network redundancy in the management network. | Critical | System | All | |

| HA disabled on cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| HA enabled on cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| A possible host failure has been detected by HA on {failedHost.name} in cluster {computeResource.name} in {datacenter.name} | Critical | System | All | |

| Host {isolatedHost.name} has been isolated from cluster {computeResource.name} in {datacenter.name} | Warning | System | All | |

| Created datacenter {datacenter.name} in folder {parent.name} | Informational | System | All | |

| Renamed datacenter from {oldName} to {newName} | Informational | System | All | |

| Datastore {datastore.name} increased in capacity from {oldCapacity} bytes to {newCapacity} bytes in {datacenter.name} | Informational | System | All | |

| Removed unconfigured datastore {datastore.name} | Informational | System | All | |

| Discovered datastore {datastore.name} on {host.name} in {datacenter.name} | Informational | System | All | |

| Multiple datastores named {datastore} detected on host {host.name} in {datacenter.name} | Critical | System | All | |

| <internal> | Informational | System | All | |

| File or directory {sourceFile} copied from {sourceDatastore.name} to {datastore.name} as {targetFile} | Informational | System | All | |

| File or directory {targetFile} deleted from {datastore.name} | Informational | System | All | |

| File or directory {sourceFile} moved from {sourceDatastore.name} to {datastore.name} as {targetFile} | Informational | System | All | |

| Reconfigured Storage I/O Control on datastore {datastore.name} | Informational | System | All | |

| Configured datastore principal {datastorePrincipal} on host {host.name} in {datacenter.name} | Informational | System | All | |

| Removed datastore {datastore.name} from {host.name} in {datacenter.name} | Informational | System | All | |

| Renamed datastore from {oldName} to {newName} in {datacenter.name} | Informational | System | All | |

| Renamed datastore from {oldName} to {newName} in {datacenter.name} | Informational | System | All | |

| Disabled DRS on cluster {computeResource.name} in datacenter {datacenter.name} | Informational | System | All | |

| Enabled DRS on {computeResource.name} with automation level {behavior} in {datacenter.name} | Informational | System | All | |

| DRS put {host.name} into standby mode | Informational | System | All | |

| DRS is putting {host.name} into standby mode | Informational | System | All | |

| DRS cannot move {host.name} out of standby mode | Critical | System | All | |

| DRS moved {host.name} out of standby mode | Informational | System | All | |

| DRS is moving {host.name} out of standby mode | Informational | System | All | |

| DRS invocation not completed | Critical | System | All | |

| DRS has recovered from the failure | Informational | System | All | |

| Unable to apply DRS resource settings on host {host.name} in {datacenter.name}. {reason.msg}. This can significantly reduce the effectiveness of DRS. | Critical | System | All | |

| Resource configuration specification returns to synchronization from previous failure on host '{host.name}' in {datacenter.name} | Informational | System | All | |

| {vm.name} on {host.name} in {datacenter.name} is now compliant with DRS VM-Host affinity rules | Informational | System | All | |

| {vm.name} on {host.name} in {datacenter.name} is violating a DRS VM-Host affinity rule | Informational | System | All | |

| DRS migrated {vm.name} from {sourceHost.name} to {host.name} in cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| DRS powered On {vm.name} on {host.name} in {datacenter.name} | Informational | System | All | |

| Virtual machine {macAddress} on host {host.name} has a duplicate IP {duplicateIP} | Informational | System | All | |

| A vNetwork Distributed Switch {dvs.name} was created in {datacenter.name}. | Informational | System | All | |

| vNetwork Distributed Switch {dvs.name} in {datacenter.name} was deleted. | Informational | System | All | |

| vNetwork Distributed Switch event | Informational | System | All | |

| The vNetwork Distributed Switch {dvs.name} configuration on the host was synchronized with that of the vCenter Server. | Informational | System | All | |

| The host {hostJoined.name} joined the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The host {hostLeft.name} left the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The host {hostMember.name} changed status on the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The vNetwork Distributed Switch {dvs.name} configuration on the host differed from that of the vCenter Server. | Warning | System | All | |

| vNetwork Distributed Switch {srcDvs.name} was merged into {dstDvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} was blocked in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The port {portKey} was connected in the vNetwork Distributed Switch {dvs.name} in {datacenter.name} | Informational | System | All | |

| New ports were created in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| Deleted ports in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The dvPort {portKey} was disconnected in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} entered passthrough mode in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} exited passthrough mode in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} was moved into the dvPort group {portgroupName} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} was moved out of the dvPort group {portgroupName} in {datacenter.name}. | Informational | System | All | |

| The port {portKey} link was down in the vNetwork Distributed Switch {dvs.name} in {datacenter.name} | Informational | System | All | |

| The port {portKey} link was up in the vNetwork Distributed Switch {dvs.name} in {datacenter.name} | Informational | System | All | |

| Reconfigured ports in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| dvPort {portKey} was unblocked in the vNetwork Distributed Switch {dvs.name} in {datacenter.name}. | Informational | System | All | |

| The vNetwork Distributed Switch {dvs.name} in {datacenter.name} was reconfigured. | Informational | System | All | |

| The vNetwork Distributed Switch {oldName} in {datacenter.name} was renamed to {newName}. | Informational | System | All | |

| An upgrade for the vNetwork Distributed Switch {dvs.name} in datacenter {datacenter.name} is available. | Informational | System | All | |

| An upgrade for the vNetwork Distributed Switch {dvs.name} in datacenter {datacenter.name} is in progress. | Informational | System | All | |

| Cannot complete an upgrade for the vNetwork Distributed Switch {dvs.name} in datacenter {datacenter.name} | Informational | System | All | |

| vNetwork Distributed Switch {dvs.name} in datacenter {datacenter.name} was upgraded. | Informational | System | All | |

| Host {host.name} in {datacenter.name} has entered maintenance mode | Informational | System | All | |

| The host {host.name} is in standby mode | Informational | System | All | |

| Host {host.name} in {datacenter.name} has started to enter maintenance mode | Informational | System | All | |

| The host {host.name} is entering standby mode | Informational | System | All | |

| {message} | Critical | System | All | |

| Host {host.name} in {datacenter.name} has exited maintenance mode | Informational | System | All | |

| The host {host.name} could not exit standby mode | Critical | System | All | |

| The host {host.name} is no longer in standby mode | Informational | System | All | |

| The host {host.name} is exiting standby mode | Informational | System | All | |

| Sufficient resources are available to satisfy HA failover level in cluster {computeResource.name} in {datacenter.name} | Informational | System | All | |

| General event: {message} | Informational | System | All | |

| Error detected on {host.name} in {datacenter.name}: {message} | Critical | System | All | |

| Issue detected on {host.name} in {datacenter.name}: {message} | Informational | System | All | |

| Issue detected on {host.name} in {datacenter.name}: {message} | Warning | System | All | |

| User logged event: {message} | Informational | System | All | |

| Error detected for {vm.name} on {host.name} in {datacenter.name}: {message} | Critical | System | All | |

| Issue detected for {vm.name} on {host.name} in {datacenter.name}: {message} | Informational | System | All | |

| Issue detected for {vm.name} on {host.name} in {datacenter.name}: {message} | Warning | System | All | |