Sections

- Qu’est-ce que la science des données et que peut-elle apporter à l’informatique ?

- Cycle de vie d’un projet de science des données en informatique

- Techniques et modèles pour automatiser les processus IT

- Outils les plus utilisés en science des données appliquée à l’informatique

- Différences entre science des données, IA, BI et analyse de données en IT

- Comment Pandora FMS permet d’appliquer la science des données en informatique

- Vers une gestion informatique pilotée par les données

Si tu te demandes comment les boutiques en ligne devinent ce que tu veux acheter pour mieux te pousser à vider ton salaire en clics impulsifs, ce n’est pas de la magie, c’est de la science. Plus précisément, la science des données, un concept qui s’applique dans de nombreux domaines : des achats, la météo, des décisions stratégiques, politiques ou militaires… et bien sûr, la gestion informatique.

C’est pourquoi nous allons aujourd’hui analyser en profondeur cette discipline, en nous concentrant sur la manière de l’appliquer pour faciliter la gestion de notre infrastructure technologique.

Nous verrons ainsi que son objectif n’est pas (uniquement) de concrétiser la dystopie de 1984, mais d’une façon bien plus sinistre que ce qu’Orwell avait imaginé.

Qu’est-ce que la science des données et que peut-elle apporter à l’informatique ?

La définition formelle (et ennuyeuse) la décrit comme le processus d’extraction de connaissances à partir de données en utilisant des techniques statistiques, des algorithmes de machine learning et des analyses avancées, appliqué à la résolution de problèmes opérationnels dans le domaine informatique.

Autrement dit, utiliser les données pour optimiser notre gestion technologique.

Dans des environnements aux infrastructures de plus en plus complexes (mélange de cloud, on-premise, edge…), où le volume d’informations explose, la science des données permet de transformer des métriques, logs et événements en connaissances exploitables.

Ces connaissances permettent notamment :

- L’automatisation d’opérations répétitives,

- Une sécurité proactive renforcée face aux menaces, plutôt que réactive,

- Une meilleure prise de décision, grâce à une base factuelle et non à l’intuition ou à l’argument classique : « On a toujours fait comme ça ».

Dans le contexte de la science des données, on retrouve des concepts comme le big data ou l’IA, en particulier depuis que les volumes de données collectées explosent.

Le big data désigne ces volumes massifs de données. L’IA, elle, permet d’analyser et d’apprendre à partir de ces données pour faire des prédictions ou détecter des schémas impossibles à voir « à la main » ou avec une analyse classique.

Avec une bonne application de la science des données, on passe de rapports statiques à des modèles prédictifs qui anticipent les pannes de serveurs, optimisent les capacités et détectent des intrusions sophistiquées.

Différences entre la science des données, l’analyse de données et l’ingénierie des données

Comme toujours lorsqu’un domaine devient à la mode, des termes et des « experts » fleurissent de partout. Il est donc essentiel de bien comprendre la différence entre ces notions, qui coexistent dans l’écosystème de la gestion de l’information.

Voici un tableau récapitulatif de leurs rôles respectifs :

|

Science des données |

Analyse de données |

Ingénierie des données |

|

Crée des modèles prédictifs et des insights avancés exploitables |

Interprète les données historiques. Limité pour prédire ou décider |

Met en place l’infrastructure nécessaire à l’analyse ou à la science des données |

|

Répond au « pourquoi ça va se produire » |

Analyse « ce qui s’est passé » |

Garantit la livraison et le stockage des données |

|

Utilise du machine learning avancé |

Utilise SQL et des visualisations graphiques, par exemple |

Maîtrise l’ETL (Extract, Transform, Load) et les bases de données |

À ce stade, tu réalises peut-être que la capacité actuelle de collecter des données massives ne profite pas seulement aux gouvernements, à Zuckerberg ou à Google pour leur supervision, mais qu’elle peut aussi améliorer la gestion IT au quotidien.

Dans ce cas, il est essentiel de bien commencer et de lancer un projet de science des données de façon optimale.

Cycle de vie d’un projet de science des données en informatique

Pour concrétiser un projet, mieux vaut suivre des méthodes éprouvées que réinventer la roue. Dans ce cas, on peut appliquer le modèle OSEMN (Obtain, Scrub, Explore, Model, Interpret) comme cycle de vie pour les projets de science des données appliqués aux opérations informatiques.

Il suffit de suivre les étapes de cet acronyme :

Obtain (Obtenir)

Cette étape consiste à collecter la matière première : pas de science sans données. Il s’agit donc d’obtenir les données critiques depuis tous les recoins de notre infrastructure technologique.

Évidemment, chaque système est unique, façonné par nos traumatismes non résolus, donc le processus varie. Cependant, ces sources sont souvent critiques et communes :

- Métriques de performance (CPU, RAM, bande passante…)

- Logs des systèmes et applications

- Événements réseau (traps SNMP)

- Données de la CMDB (Configuration Management Database) contenant la configuration des actifs de notre petit empire numérique

Il faut reconnaître que descendre à la mine pour extraire ces données est une tâche fastidieuse dès que l’infrastructure devient un peu complexe. Certaines données sont disponibles, d’autres nécessitent des accès, et certaines doivent être configurées pour être collectées.

C’est pourquoi un outil de supervision comme Pandora FMS facilite grandement cette étape. Pandora centralise la collecte, la simplifie (par exemple via une CMDB intégrée) et réduit considérablement les délais et les efforts.

Scrub (Nettoyer)

Un projet de science des données sera aussi bon que la qualité des données collectées dans l’étape précédente. L’étape suivante consiste donc à nettoyer les données.

Cela inclut :

- Éliminer le bruit, c’est-à-dire séparer les données pertinentes des inutiles (ex. : logs de débogage sans valeur).

- Corriger les valeurs anormales (ex. : métriques CPU supérieures à 100 %).

Explore (Explorer)

C’est ici que nous commençons à extraire les premiers enseignements de cette mer de données, ce qui implique généralement :

- Identifier les motifs émergents dans les données. Par exemple : à quelle heure les serveurs dépassent-ils régulièrement 90 % d’utilisation de la RAM ?

- Visualiser les corrélations, pour comprendre les causes de ces schémas. Exemple : l’augmentation de latence réseau coïncide-t-elle avec les sauvegardes planifiées ?

Histogrammes, graphiques de relations entre variables, regroupement de données… Les techniques varient, et la compétence de l’équipe joue un rôle décisif ici.

Model (Modéliser)

Ce projet de science des données n’est pas un caprice. Il vise à nous aider à mieux gérer, notamment via cette précieuse capacité de prédiction qui anticipe et optimise, plutôt que de nous laisser courir partout pour éteindre des incendies.

Cela implique d’entraîner des algorithmes pour prédire des scénarios. Certains seront complexes (à base d’IA), d’autres plus simples, comme une régression permettant d’estimer la capacité future.

Interpret (Interpréter)

Tout ce travail génère des résultats qui ne doivent pas rester dans un tiroir, mais être traduits en actions concrètes à ce stade.

Par exemple, il peut être nécessaire d’ajouter des serveurs on-premise pour éviter des interruptions ou goulots d’étranglement affectant la productivité. Ou encore, d’ajuster la capacité d’hébergement web en fonction des pics saisonniers de votre activité.

Techniques et modèles pour automatiser les processus IT

Les étapes 3 et 4 du cycle de vie précédent sont les plus intéressantes en pratique, car elles nous permettent d’appliquer des techniques concrètes pour améliorer la gestion IT—ce qui est bien notre objectif final.

Voyons ces techniques de plus près, avec des exemples concrets d’usage de la science des données dans l’IT.

Classification

L’agrégation et l’analyse de données peuvent produire beaucoup d’informations—mais toutes ne seront pas pertinentes. Passer de l’aveuglement à l’inondation d’alertes revient à fuir Alien pour tomber sur Predator, et cela conduit vite à une fatigue informationnelle.

Pour l’éviter, il faut classifier et prioriser les alertes en Critiques, Avertissements, Informatives…

Il est essentiel de savoir s’il y a une intrusion, utile de savoir qu’une mise à jour s’est bien passée, mais inutile de recevoir une alerte pour chaque copie de fichier ou chaque synchro cloud.

Pandora FMS aide à appliquer cette technique, car il réduit la fatigue d’alerte via un système personnalisable adapté à chaque infrastructure.

Régression

La régression sert à prédire certaines tendances, comme la capacité disque. Pandora FMS, via ses fonctions de supervision prédictive, permet de faire ce capacity planning basé sur les données.

En supposant un comportement plus ou moins linéaire, cela nous permet de savoir combien de jours il reste avant que le disque soit plein, ou combien de requêtes base de données on aura dans un mois.

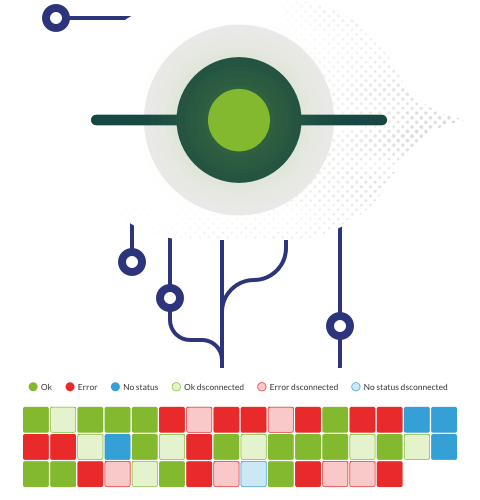

Clustering

Cette méthode consiste à regrouper les éléments selon leurs similitudes (serveurs web, bases de données critiques…) et permet une surveillance par groupe au lieu d’un suivi élément par élément, ainsi que des politiques de gestion homogènes.

Cela permet de mettre de l’ordre dans le chaos, et Pandora FMS permet aussi la supervision de clusters et leur création selon vos besoins spécifiques.

En combinant cette technique avec la classification, on peut définir les nœuds critiques, des alertes personnalisées pour chacun, etc.

Détection d’anomalies

Cela peut révéler des pannes matérielles ou de services, ou pire encore : une intrusion d’un acteur malveillant.

L’enjeu est ici d’identifier de manière proactive les comportements suspects et de détecter les anomalies dès qu’elles apparaissent.

À cet effet, Pandora FMS dispose d’un moteur de détection d’anomalies (MADE) qui réalise cette détection automatiquement.

En analyse prescriptive, si le système détecte que le serveur DB-1701 (oui, la référence est facile—pas de point bonus) est à 98 % de capacité, il peut avertir qu’en poursuivant cette tendance, une panne surviendra dans 15 minutes.

Ainsi, la science des données permet d’éviter une panne, plutôt que d’apprendre qu’elle est survenue, accompagnée de quinze emails d’utilisateurs furieux.

Répartir les charges, ajuster les conteneurs, modifier les politiques de sauvegarde… La prédiction adaptée à notre infrastructure est l’un des Graals d’un projet de science des données réussi.

Mais alors, comment obtenir cette prédiction ?

IA et Machine Learning dans les opérations IT

Dans le cas de Pandora FMS, l’objectif final du moteur MADE est l’entraînement et l’utilisation de modèles d’IA pour détecter les problèmes à l’avance.

Mais ces modèles peuvent faire bien plus : ils permettent d’améliorer la gestion proactive de la capacité, des ressources, de l’assignation intelligente de tickets…

Bien entendu, nous pouvons aussi créer et entraîner nos propres modèles, que ce soit à partir de zéro ou en utilisant des outils spécialisés, que nous allons voir ensuite.

Outils les plus utilisés en science des données appliquée à l’IT

Lorsqu’il s’agit de modéliser dans notre projet (étape 4 du cycle de vie), en transformant les données en actions et en outils utiles à la gestion IT, nous avons de nombreuses options selon nos connaissances, le temps disponible et, bien sûr, le budget.

Voici les principaux outils permettant de concrétiser la science des données :

- Python/R : Pour développer des modèles personnalisés et, en général, le choix classique dans la plupart des situations.

- TensorFlow/PyTorch : Bibliothèques populaires pour le développement de Deep Learning.

- Apache Spark : Un moteur de traitement de données open source conçu pour l’analyse à grande échelle (avec lequel on peut interagir en Python, par exemple via Pyspark).

- Jupyter Notebooks : Pratiquement la norme pour créer des documents d’analyse interactifs.

- Services Cloud : Comme Amazon Sagemaker, pour construire, entraîner et déployer des modèles depuis le cloud sans avoir à tout configurer on-premise.

Ce ne sont pas les seuls outils : Google Colab, Kaggle, Anaconda… Le choix est si vaste que vous risquez bien de procrastiner à les tester, tandis que votre projet n’avance pas.

Différences entre science des données, IA, BI et analyse de données en IT

La science des données est très en vogue, mais comme toute tendance, elle finit par être détournée ou mal utilisée, avec une touche de marketing pour tout rebaptiser. Il est donc préférable de clarifier les malentendus.

La science des données utilise des méthodes, des processus, des algorithmes, de la modélisation et plus encore pour extraire des connaissances des données, avec une approche d’interprétation, de prédiction et de prescription. Mais la science des données n’est pas :

- Juste de la programmation. Même si elle est utilisée pour la modélisation ou la collecte/nettoyage de données, la science des données comprend aussi du machine learning et des statistiques.

- Juste de l’analyse de données. C’est une partie de la discipline, mais la science des données va bien au-delà.

- Juste de l’IA. L’intelligence artificielle peut être un outil en science des données (surtout pour prédire/prescrire), mais ce n’est pas le seul : on peut aussi utiliser la régression ou d’autres analyses statistiques.

- La BI (Business Intelligence). Cette intelligence d’affaires repose traditionnellement sur des données historiques et statiques, bien que son évolution intègre des concepts comme le BAM (Business Activity Monitoring). La science des données va plus loin en construisant des modèles qui améliorent la prise de décision.

Voici un tableau comparatif des principales caractéristiques de chaque concept :

|

Concept |

Prédictif |

Temps réel |

Action automatique |

Profondeur technique |

|

Science des données |

✓ |

Parfois |

Parfois |

Élevée |

|

IA |

✓ |

Parfois |

✓ |

Élevée |

|

BI |

✗ |

✗ |

✗ |

Moyenne |

|

Analyse de données |

✗ |

Parfois |

✗ |

Moyenne-Faible |

Comment Pandora FMS permet d’appliquer la science des données en IT

Étant donné que la science des données consiste à collecter, filtrer, analyser les données, modéliser et déployer des solutions, un outil de supervision global comme Pandora FMS aide à supporter la plus grande charge d’un tel projet.

Nous avons déjà vu quelques exemples en abordant les étapes de mise en œuvre d’un projet, mais ce ne sont pas les seuls.

- Par exemple, il facilite la collecte grâce à l’extraction unifiée de données via des agents, des API, etc. Cela permet de démarrer le projet plus rapidement et plus simplement.

- Il peut créer des systèmes d’alertes personnalisées lorsque l’on applique des techniques comme la classification ou le clustering.

- Application de l’IA pour la détection d’anomalies avec son moteur MADE.

- Visualisation avancée des éléments clés issus du projet de science des données, grâce à ses tableaux de bord personnalisés.

Cette science a besoin de données, et des outils de supervision avancés comme Pandora FMS sont des experts pour les collecter, les corréler, les afficher et les classer.

Vers une gestion informatique pilotée par les données

Bien souvent, la gestion d’une infrastructure IT repose sur les compétences, l’intuition ou les habitudes de ses administrateurs. Ou elle est construite autour des capacités des outils disponibles, plutôt que sur des processus optimaux.

Aujourd’hui, avec l’essor du big data, la gestion pilotée par les données s’est imposée dans la plupart des domaines, car, en s’appuyant sur des preuves spécifiques à chaque organisation, elle permet une meilleure optimisation.

Il ne faut pas tomber dans le paradoxe selon lequel la technologie — à l’origine même de cette gestion fondée sur les données — ne s’appliquerait pas à elle-même. Ce serait l’illustration parfaite de l’adage : « Les cordonniers sont les plus mal chaussés ».

Un bon projet de science des données apportera des bénéfices concrets, comme par exemple :

- Réduction du MTTR (Mean Time To Repair) : Grâce à des modèles prédictifs et des alertes personnalisées.

- Réduction des coûts : Par l’optimisation des ressources cloud/on-premise, la diminution des défaillances et des dépenses associées, etc.

- Sécurité renforcée : Permettant, par exemple, de mieux contrer les redoutables attaques zero-day grâce à la détection d’anomalies.

Concernant l’avenir de la science des données, chacun y va de sa prédiction. Mais ceux qui s’y connaissent savent aussi que ces prévisions valent autant qu’un billet de six euros.

Cela dit, certaines tendances émergent clairement en science des données, comme par exemple :

- AIOps : Ou intelligence artificielle pour les opérations IT, qui vise à l’intégrer avec l’apprentissage automatique pour améliorer et automatiser la gestion.

- Modèles hybrides : Combinant règles expertes, deep learning et autres techniques, pour tirer le meilleur de chaque approche et compenser leurs faiblesses.

- Automatisation totale : Allant de la détection des incidents jusqu’à leur résolution sans intervention humaine.

L’avenir n’est écrit nulle part, surtout pas dans ce domaine, même si beaucoup essaient de le vendre avant de l’avoir construit. Mais la vérité, c’est qu’aujourd’hui, la science des données devrait être au cœur de la gestion des infrastructures IT modernes.

La mettre en œuvre ne signifie pas forcément un projet pharaonique. Même les architectures les plus modestes peuvent tirer un énorme bénéfice de leurs données et les transformer en avantage concurrentiel.

Après tout, les concurrents les plus intelligents le font déjà.

Un seul outil peut-il avoir une visibilité mondiale ?