Configuración

El plugin hace uso de unos endpoints de la rest api de Spark, para poder acceder a ellos desde el plugin tendremos que tener una serie de puertos activos y que no los bloquee el firewall, estos son los siguientes :

firewall-cmd --permanent --zone=public --add-port=6066/tcp

firewall-cmd --permanent --zone=public --add-port=7077/tcp

firewall-cmd --permanent --zone=public --add-port=8080-8081/tcp

firewall-cmd --permanent --zone=public --add-port=4040/tcp

firewall-cmd --permanent --zone=public --add-port=18080/tcp

firewall-cmd --reload6066: Rest url (cluster mode).

7077: Server master.

8080 : Web UI.

4040: Para aplicaciones en ejecución.

18080: Para el history server.

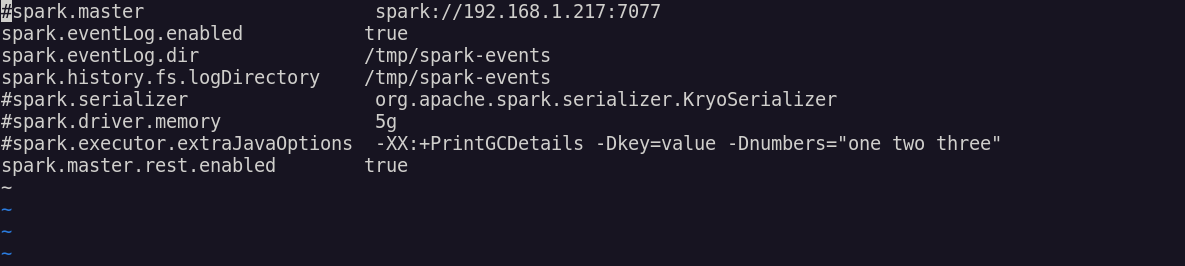

Para poder hacer uso del history server tendremos que activar spark.eventLog.enabled, spark.eventLog.dir y spark.history.fs.logDirectory en spark-defaults.conf.

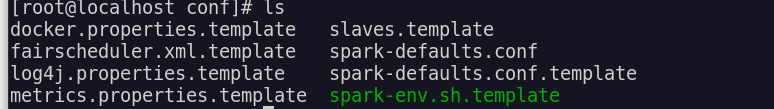

Podemos encontrar una plantilla del conf en /conf

Crearemos en esa ruta el archivo con:

vi spark-defaults.confY lo dejaremos así, puedes elegir la ruta en la que quieres guardar los eventos.

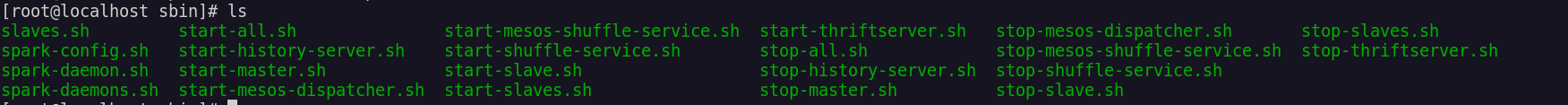

Ahora podremos activar el history server, en /sbin la misma ruta donde se activa el master, los workers, etc.

Lo iniciaremos con :

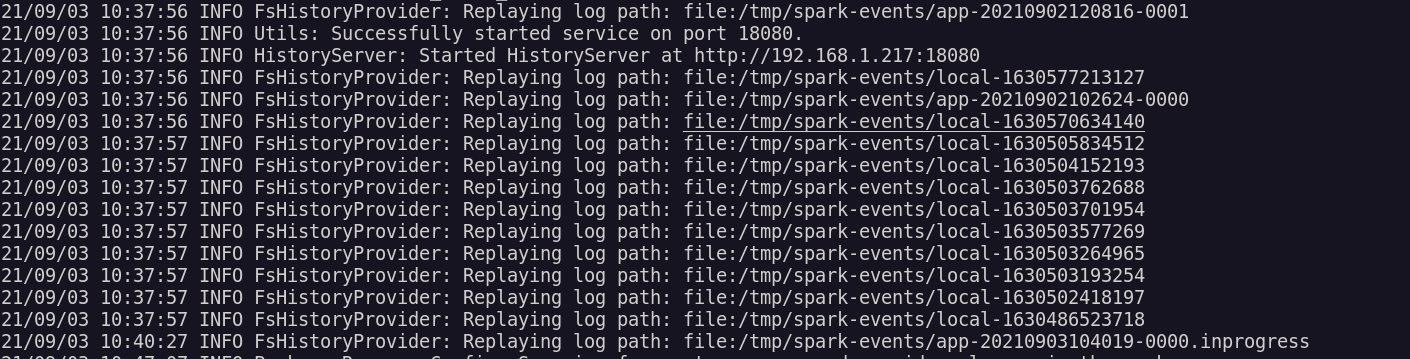

./start-history-server.shSi vamos al log que nos devuelve la salida veremos como correctamente se ha iniciado y su url.

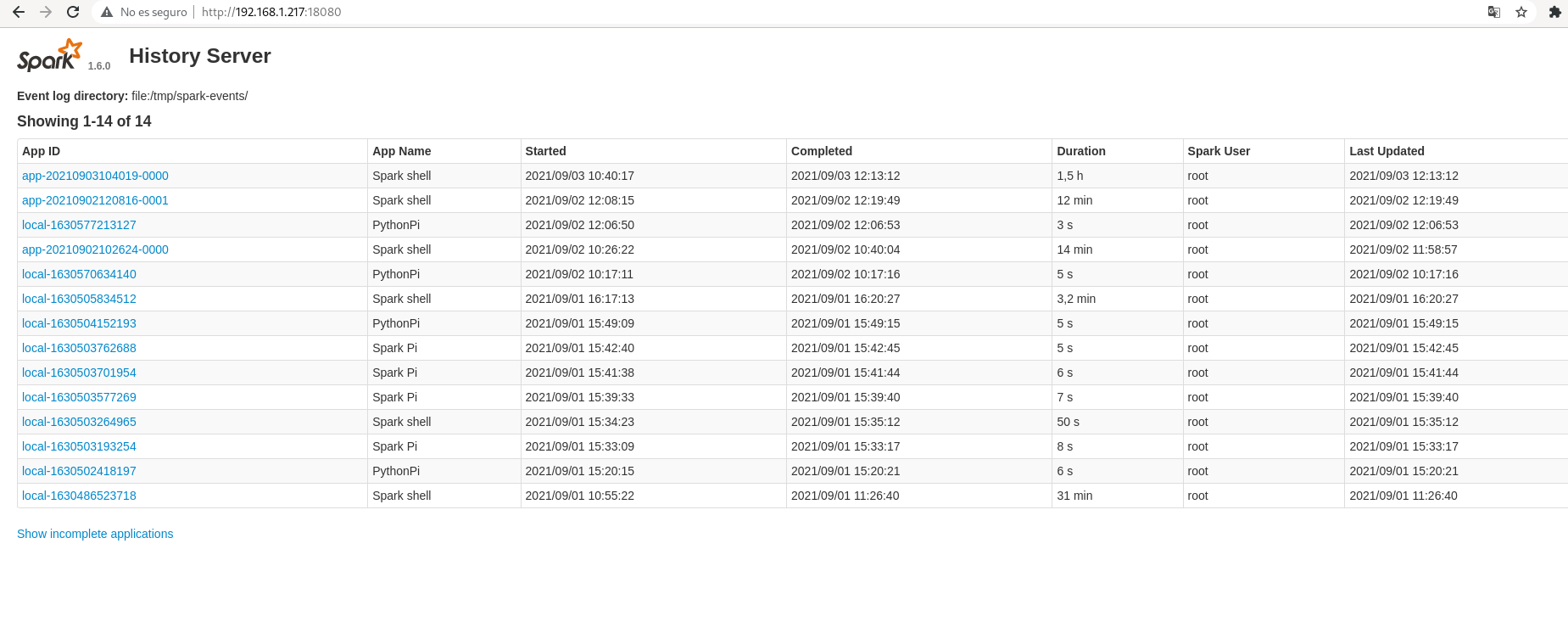

Si accedemos a la url veremos como nos sale el history server.

Nota:

Esto se presupone, pero para que funcione el plugin se tendrá que tener activo el server maestro, así como tener aplicaciones en ejecución o que han sido ejecutadas y han finalizado, ya que es de las aplicaciones de lo que cogeremos las métricas, concretamente de sus ejecutores.